ChristianP

Adhérent Infoclimat-

Compteur de contenus

2904 -

Inscription

-

Dernière visite

-

Jours gagnés

1

Type de contenu

Profils

Forums

Calendrier

Tout ce qui a été posté par ChristianP

-

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

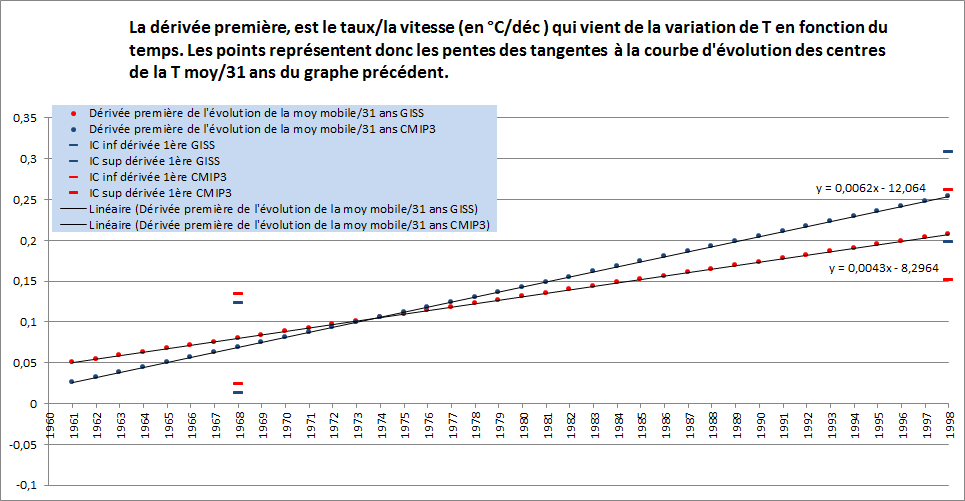

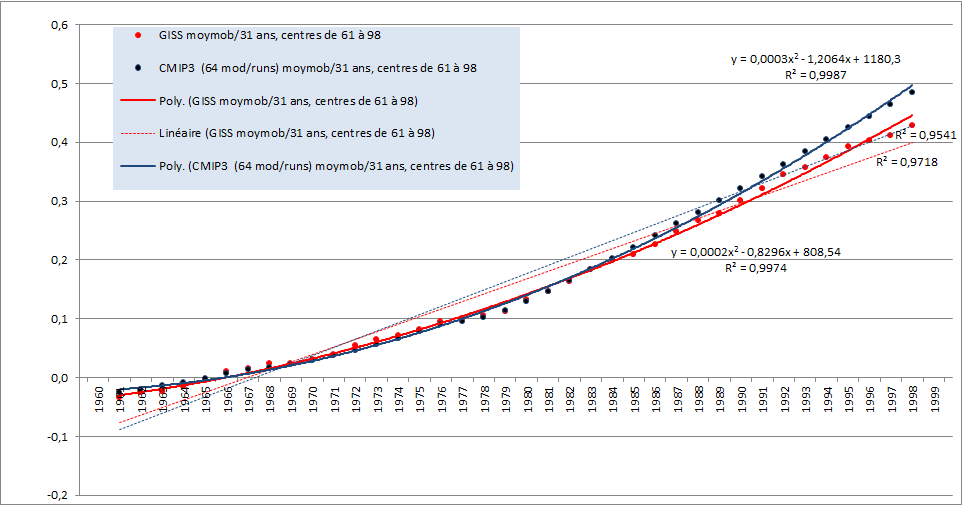

Merci Gpiton pour le boulot d'extraction et de tracés des modèles de l'AR5, un à un, en prime pour tous les scénarios. Ca se saurait, si pour vérifier la significativité d'un changement d'accélération sur le fond (et non avec du bruit à gogo !), il suffisait sans le comprendre, de lire le GIEC ou autres, de citer leurs chiffres sortis du contexte sans préciser, qu'ils ne sont pas significativement différents sur le fond à cause des courtes périodes concernées. C'est de plus en plus volontairement dans ton cas, vu qu'on t'a informé x fois comment savoir (si tu ne comprends pas le texte du GIEC) s'ils concernent un écart sur le fond, un écart avec le bruit, et/ou des variations internes visibles dans 30 ans. Tout le monde est capable de voir que ça varie à court-terme, que ça diverge sur 15 ans et sur d'autres périodes internes à 30 ans, qu'il y a des écarts en apparence sur des graphes, des valeurs centrales différentes, quand il y a du bruit mélangé au signal sur ces courtes périodes, mais sur le fond, ça demande autre chose, vu que les modèles ne sont pas conçus et bons pour ces échelles. Le GIEC ne va pas rabâcher x fois pour ceux qui se lavent le cerveau sur le fil conducteur robuste, quand il publie ailleurs dans le texte, des chiffres très utiles pour une autre échelle ! Donc arrête de jouer ici au faux ignorant ou mets toi au boulot pour intégrer une fois pour toutes les bases. Le fil rouge sous-jacent à garder en tête est clair : Si tu lis des chiffres du GIEC en oubliant volontairement systématiquement ce fil rouge, qui est que le signal climatique est très bien vu pour l'échelle climatique minimale (il faut 2 échantillons de climat,de 30 ans au moins, donc pour une tendance, c'est sur 60 ans au moins, comme par exemple, sur les 62 ans plus haut), et que les variations à court-terme divergentes, ne changent rien d'important pour le fond pour le moment et qu'elles sont utiles à faire ressortir pour l'analyse des variations internes visibles, ce n'est même pas la peine de continuer à le consulter. Les scientifiques en sont à tenter d'expliquer et de prévoir les variations dans 30 ans, comme pourquoi précisément une tendance /10, /15 ou /30 ans, est plus faible ou plus forte que celle de fond et que celles des modèles. Donc ils décortiquent tous les bruits (au sens très général, qu'ils soient habituels ou non, naturels ou non) suspects de faire varier la T à ces échelles. Ils font ressortir les divergences à ce niveau, montrent où ça ne colle pas assez pour se permettre une prévis interne à 30 ans efficace. Mais toi tu passes ton temps à nous sortir ces chiffres uniquement pour faire croire que ça a très probablement un sens important pour le signal de fond, alors que c'est l'inverse qui est le plus probable d'après eux. Maintenant, le pire, c'est que tu veux faire passer ces citations hors contexte du court-terme, comme une méthode un peu sérieuse et assez correcte pour tester si une accélération est significativement différente entre obs et modèles. Tu utilises des tendances/30 ans pour la chercher sans même afficher les IC des obs et des modèles sur ton graphe, alors que ton choix augmente proportionnellement le bruit d'un facteur 3 (!) plutôt que d'utiliser la moyenne/30-31 ans ! Si tu avais collé les IC aux valeurs des obs et des modèles sur ton graphe préféré, tu verrais déjà qu'il n'y a pas de diff significative et donc que c'est impossible mathématiquement d'observer et d'envisager une accélération significativement différente entre obs et modèles à cette échelle (dans le bruit aux courtes échelles, il n'y a rien de nouveau, tu pourras toujours en trouver des variations de vitesses au nanomètre tant que tu y es, mais même un élève de primaire sait que ça n'a pas de sens pour la T finale de la journée de se fixer sur les baisses et hausses horaires de T, mais dès que ça parle climat, c'est incroyable comme le cerveau de certains coince sur des bases aussi élémentaires !) Et oui ton IC sur une valeur de tendance décennale même moyenne/30 ans, est proportionnellement 3 fois plus grand que pour la moyenne/30 ans. L'IC plus important proportionnellement, ne sort pas du saint esprit, il est produit par ton choix volontaire inadapté à notre cas (chercher une accélération significativement différente sur le fond entre obs et modèles) et tu nous refiles cette proportion industrielle de bruit, alors que ça fait x messages qu'on te le signale et qu'on t'explique pourquoi l'estimation d'une tendance/30 ans est plus sensible au même niveau de bruit dans l'absolu que pour une moyenne/30 ans. Ce n'est pas parce que les scientifiques utilisent des tendances /x années pour d'autres raisons, que c'est utile pour notre cas. C'est le contexte qui décide du choix : chercher une accélération significativement différente sur le fond, nécessite de virer du bruit et pas d'en rajouter que ce soit dans l'absolu ou en proportion ! C'est quand même le comble quand on veut démontrer qu'il existe un changement significatif d'accélération entre les obs et les modèles, de vouloir absolument masquer le signal de fond, avec une quantité de bruit, alors qu'il faut faire l'inverse, virer assez de bruit, sans trop déformer le signal de fond, afin de visualiser comment évolue le signal de fond et trouver une éventuelle accélération différente sur le fond. Ton "mais", est très symptomatique de l'erreur fondamentale, probablement volontaire depuis que tu as été informé en long et en large des échelles. Tu n'es pas satisfait parce qu'il n'y a pas de variations assez visibles en moyenne mobile/31 ans, pas assez d'écarts à ton goût, avec les modèles et des variations à l'échelle minimale climatique pour lesquels il sont faits. Ca ne plait pas que ça colle trop au modèles et allez hop (!), que je te rajoute une bonne couche de proportion de bruit en utilisant les tendances déc/30 ans, pour masquer le signal de fond et faire ressortir de fausses variations pour ce fond, vu qu'elles viennent de la proportion de bruit ajouté + du non respect du modèle de ces tendances, afin que que ça varie bien plus visuellement à cause du bruit pour tromper le lecteur, pour nous dire entre les lignes : Regardez, ça change bien sur le fond , alors que tu as contaminé le signal avec du bruit et en te basant sur l'utilisation tordues de citations de chiffres du GIEC qui ne concernent pas le fond, mais des périodes courtes ! Et dans le prochain message, tu vas nous ressortir la même tambouille, malgré les x explications. Oui ce sont des variations très intéressantes à décortiquer pour arriver à les prévoir, mais elles sont considérées comme négligeables pour le fond, tant qu'elles ne sont pas significatives pour lui, que ce soit physiquement, ou au moins mathématiquement, si la physique manque de mesures pour le déterminer. Ca se saurait si on pouvait avec des citations de valeurs non significativement différentes entre obs et modèles, démontrer un changement/une différence d'accélération significative pour le fond. Pour commencer à envisager une accélération significativement différente entre les obs et les modèles, il suffisait simplement de démontrer que les tendances de ton graphe préféré sur les tendances décennales/ 30 ans pour notre période où ça diverge, sont significativement différentes. Il te faut d'abord des IC des estimations stats des obs et modèles (donc coller au mimimum mentalement les IC, voir plus bas les infos pour remplacer ton point d'interrogation sur l'IC des modèles) Il y a du monde qui l'a déjà fait, bien avant ton graphe, je l'ai vérifié encore sur les points concernés de ton graphe. Il n'y a pas de différences significatives de tendances /30 ans obs/modèles, donc pas de différences significatives d'accélération. Et oui, il est impossible d'observer une accélération significativement différente sans d'abord relever une tendance significativement différente entre les obs et modèles (pour la période concernée par la divergence récente), vu que la dérivée première (les taux, les vitesses en °C/déc, non pas de ton graphe, mais celles données par les pentes des tangentes à la courbe d'évolution de la T moy mobile/31 ans) non significativement différente, ne peut donner une dérivée seconde (l'accélération en °C/déc^2) qui le soit. Un lycéen de première qui n'a pas abordé les calculs de significativité, pouvait étudier les variations de la fonction locale concernée par la divergence. Là tu n'as pas de problèmes avec le modèle linéaire pour suivre la véritable forme de l'évolution des pentes d' une courbe d'évolution du climat (donc des moyennes d'au moins 30 ans) Il aurait d'abord zoomé sur la période concernée entre les deux flèches à partir de 1961 à maintenant, 98 (car en valeur moyenne mobile/31 ans centrée), pour extraire la fonction locale dont on veut étudier les variations en partant d'une partie où les données sont assez proches pour que les divergences antérieures ne biaisent pas la détermination de la fonction pour la divergence qu'on cherche à étudier (au lieu de 1961, en regardant de plus près au zoom, j'aurais même dû commencer en 64, mais bon ça ne change rien) : Le zoom des moyennes mobiles/31 ans et deux fonctions y ajustées pour les obs et modèles, qui donnent les primitives à dériver : Là un lycéen dans son programme n'a normalement pas de quoi tester et vérifier qu'il n'y a pas une différence significative entre la linéaire et la quadratique (Il n'y a aucune raison objective de choisir la quadratique plutôt que la linéaire que ce soit pour les obs ou pour les modèles, ceci déjà à cause du bruit dans l'estimation, donc après les IC des tendances/30 ans, pas d'accélération différente sur le fond aussi sur cette base. Avec la linéaire, l'accélération est nulle, vu que la dérivée seconde, y" = 0, qu'on peut extraire avec les règles de dérivation, de l'équation linéaire de la droite fonction d'origine y du graphique. Il ne faut pas confondre, croissance différente avec accélération présente ou différente, avant même de parler de différence significative, donc sur le fond.) Le lycéen qui ne peut le savoir, poursuit l'analyse des variations à partir des quadratiques où il a une chance de trouver une accélération qui change entre les modèles et ou obs, faute de pouvoir en estimer la significativité. Il trace donc la dérivée première (les équations y du graphe suivant, sont en fait des y' , les dérivées premières des équations des fonctions quadratiques du graphe précédent): Là même sans les IC présents, il pourra déjà dire que le réchauffement est toujours croissant aussi bien dans les modèles, que dans les obs (quand il y aura un changement d'évolution du climat lui-même (et non à l'intérieur de lui, vu qu'on ne voit pas le bruit interne à 30 ans, c'est prévu pour !), ça se verra aussi clairement sur ce genre de graphe d'évolution de la dérivée première) et que l'accélération est constante, uniforme et qu'elle n'a pas changé ni dans les modèles, ni dans les obs. Et oui la dérivée seconde, l'accélération, Y" est égale à une constante, en dérivant les équations y' , y"=0.0062°/déc^2 pour les modèles, y"=0.0043°C/déc^2 pour les obs. C'est à dire que c'est une accélération constante (ni croissante, ni décroissante), plate de chez plate (je n'ai pas tracé le graphe, avec 2 lignes horizontales, j'espère que c'est assez évident pour le monde !), différente entre les obs et modèles, mais pas significativement, loin de là, mais c'est clair que si ça persiste ça le deviendra et on le verra mathématiquement. Comme la significativité n'était déjà pas présente entre la linéaire et la quadratique, on ne pouvait pas récolter des IC au bout des pentes des dérivées premières, qui montrent une différence significative. On peut noter la différence significative de tangentes entre 1968 et et 98 (pour respecter l'indépendance des données), signe que le climat est significativement différent aussi bien dans les obs que dans les modèles (et y en a encore qui vont oser continuer nous dire que ça stagne (sous entendu sur le fond, vu que tout le monde voit bien que ça stagne dans le bruit.), parce qu'ils sont obnubilés par leur zoom volontairement bloqué sur les bruits internes sur 1 à 30 ans...) Pour la significativité de la différence /30 ans obs/modèles, comme il te manque celui pour les estimations stats/30 ans des modèles. Il suffit en première approximation, de remplacer ton point d'interrogation, par la valeur "générique" de +-0.055°, vu que ça varie selon les échantillons/30 ans et les séries d'obs, le plus souvent de 0.05° à 0.06° (en moy /30 ans ou en tendance /30 ans, les IC sont exactement du même ordre, ce sont exactement les mêmes valeurs qui entrent dans l'estimation stat de la tendance et de la moyenne) Il faut donc une différence de plus de 0.11° entre 2 séries indépendantes/ 30 ans pour commencer à considérer la significativité probable d'une différence de tendance, de moyenne/30 ans de T globale, avant d'envisager la moindre possibilité d' accélération différente sur le fond (même quand elle l'est visuellement à cause du bruit), mais aussi pour commencer à se pencher sur les détails, affiner les calculs d'IC et intégrer les autres sources d'erreur (par ex, de mesure et de détermination de la T globale pour les obs), car les IC de ces estimations stats des modèles, que tu peux calculer directement d'après les modèles /runs individuels que tu as récoltés (et non pas d'après la moyenne multi-modèles-runs d'un même scénario ou non, qu'on peut voir sur un de tes graphes et qui lisse mécaniquement ce bruit), seront plus larges que +-0.055°/30 ans, à cause du fait que les modèles ne savent pas simuler assez précisément le niveau de bruit de la réalité. Donc si ce n'est déjà pas significatif avec les plus petits IC possibles autour des estimations stats à partir des modèles, ce n'est pas la peine de perdre du temps dans les calculs précis. En injectant des IC d'environ +-0.055° autour des valeurs modèles/30 ans, c'est comme si on sous-entendait qu'ils ont parfaitement capté le niveau de bruit de l'évolution de T du monde réel aux pas fins, alors qu'il est connu qu'ils ont tendance à faire un peu trop varier la T d'un mois, d'une année sur l'autre, par rapport à la réalité. Pour calculer les IC directement à partir des modèles, il faut se prendre la tête et vérifier pour chaque run/modèle (donc à faire avec un programme, vu le temps que ça prend en manuel !), si la méthode de Tamino (celle dans le calculateur de SKS) ou autres méthodes correctes quand ce n'est pas le cas, s'appliquent, recalculer le modèle de bruit, les paramètres adaptés à la variabilité différente du run concerné, pour compenser l'auto-corrélation. Effectuer ça pour chaque run-modèle et moyenner pour récupérer les IC moyens des estimations du bruit à partir des modèles, comparables à ceux d' une seule expérience réelle, la notre. Donc on voit pourquoi, il vaut mieux commencer à avoir une idée de la proximité ou non de la significativité, en utilisant les IC des obs directement sur les modèles, en première approximation (si l'écart est assez important entre les IC des obs et des modèles avec cette approximation, ça évitera aussi les calculs détaillés aussi pour considérer que la différence est très probablement significative) Donc avec des tendances/30 ans qui ne sont pas significativement différentes (entre les obs et les modèles) pour la période concernée pour l'étude de la variation où ça diverge, ne peuvent pas générer d'accélération significativement différente. C'est mathématiquement impossible et c'est clair qu'il y a et aura toujours des variations plus ou moins importantes avec le bruit, rien de nouveau tant que les modèles ne seront pas capables de prévoir ce bruit et non pas simplement de simuler son apparence. -

Datalogger Vantage Vue incompatible

ChristianP a répondu à un sujet de alsavosges dans Instrumentation

Si tu n'as pas d'autres consoles pour tester le datalogger, il faut voir avec le SAV pour qu'il teste ta console et le datalogger. -

Datalogger Vantage Vue incompatible

ChristianP a répondu à un sujet de alsavosges dans Instrumentation

Si j'indique qu'un numéro de série est présent (et un point vert pour les versions compatibles) et qu'il n'est pas sur la face visible quand il est branché, la logique la plus basique c'est de retourner le datalogger et de regarder en détail l'objet en entier, toutes les faces, mais aussi tous les petits côtés (Il y a quand même pas mal d'appareils électroniques qui ont un numéro de série derrière et sur les côtés et non pas devant. S'il faut expliquer aussi les bases sur les objets de la vie courante, on ne va pas s'en sortir avec mes messages déjà habituellement longs ! ) Alors que je suis assez débordé, j'ai pris un temps non négligeable pour te rechercher ces liens où j'ai vu passer l'info sur le numéro de série, où ils parlent du point vert et des solutions. Non seulement tu ne regardes pas ton objet en panne pour y chercher le numéro de série, mais en plus tu traines les pieds pour lire les liens. Libre à toi d'avoir la flemme de ne pas les consulter, mais bon la prochaine fois je m'occuperai d'autres choses (même si l'anglais c'est pas ton truc, avec Google translate, on s'en sort et c'est vite fait de retrouver des messages qui affichent des numéros de série (qui eux sont dans la même langue) et de ne consulter en détail que ceux là, ou au moins de demander directement à Davis) Enfin, ça m'apprendra d'essayer d'aider quelqu'un qui semble moins motivé que moi pour résoudre son propre problème et qui en prime me "reproche" de ne pas avoir indiqué l'endroit exact d'un numéro de série si facile à trouver sur un élément électronique si minuscule (comme si on perdait du temps à mémoriser la position d'un numéro de série !) -

Datalogger Vantage Vue incompatible

ChristianP a répondu à un sujet de alsavosges dans Instrumentation

Yohan, où vois-tu que je parle de diode ? (T'es en manque de flash d'orages pour chercher des lumières partout) Ca n'a rien à voir avec un point vert. Démonte ton datalogger pour trouver le point vert (imprimé, peint, tout ce que tu veux, mais pas de foudre, ni de lumière !) Idem pour Alsavosges démonte et regarde (prends une loupe si nécessaire, mais bon le numéro de série est largement visible, où alors le vendeur t'as refilé n'importe quoi) Cherche dans les liens que je t'ai donnés, c'est indiqué quelque part, je l'ai lu, ou demande directement à Davis le numéro de série limite. -

Datalogger Vantage Vue incompatible

ChristianP a répondu à un sujet de alsavosges dans Instrumentation

Ici c'est sur l'USB, je n'ai que ce datalogger à point vert et c'est le seul qui fonctionne sur la seule console à firmware 3.x, j'en ai testé un paquet d'autres sur cette nouvelle console en 3.x, aucun ne fonctionne à part celui échangé. Essaie de voir avec le numéro de série, s'il ne t'a pas refilé un ancien modèle. http://www.wxforum.net/index.php?topic=18391.0 http://www.wxforum.net/index.php?topic=17198.0 http://www.wxforum.net/index.php?topic=18110.0 http://www.wxforum.net/index.php?topic=17691.0 -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

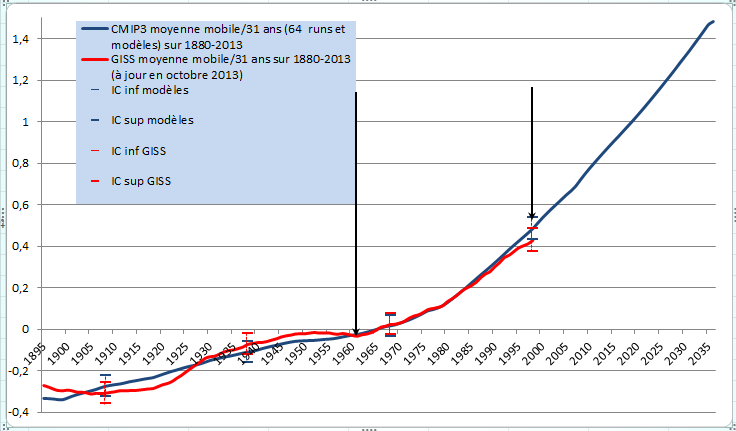

Oui je me faisais la même réflexion sur l'influence de la répartition des anomalies sur terre ou sur mer. C'est clair qu'avec un écart-type bien plus important dans les terres (une anomalie à +3 sigma sur 1000 km2 en pleine Russie, ça produit une anomalie en °C, bien plus importante que + 3 sigma en pleine mer près de l'équateur pour cette même surface), si les terres récoltent proportionnellement plus d'anomalies froides, alors que ce sont les mers qui récupèrent plus d' anomalies chaudes, l'anomalie globale ne peut que varier de façon différente dans le cas inverse. Je regrette et je ne comprends toujours pas pourquoi les spécialistes ne communiquent pas une anomalie non pas seulement en °C, mais en nombre d'ET global, déterminé à partir du nb d' ET de chaque maille (et non pas à partir de l'ET de la moyenne globale communiquée, qui ne peut pas faire ressortir la véritable anomalie de la planète, le vrai écart à la variabilité "normale", indépendant du fait qu'on relève plus ou moins d' anomalies +-, en mer et sur terre) Pour le moment sans ce paramètre, je reste toujours sur ma faim. En attendant pour Gpiton, il y a une méthode où on n'a pas à s'occuper de savoir si on respecte le modèle linéaire pour suivre l'évolution du climat, en utilisant la moyenne mobile / 31 ans qui affiche le signal de fond à l'échelle minimale pour parler d'évolution du climat (Pour un centrage correct une moyenne mobile avec un nombre impair, sur 31 ans au lieu de 30 ans, les IC espacés de 31 ans pour préserver l'indépendance des moyennes pour des comparaisons des moyennes / 31 ans) Je l'ai comparée à celle /31 ans des modèles CMIP3 que j'avais en stock (du moins uniquement ceux qui génèrent des données pour la période donnée sur 1880-2050), dont j'avais diffusé le fichier Excel en lien quelque part dans ce forum. Les IC ne prennent en compte que l'incertitude générale de l'estimation d'une moyenne, donc ils n'intègrent pas l'incertitude des modèles, ni celle de mesure et de détermination de la T globale, c'est à dire qu'on ne peut pas produire des IC plus petits. A une année donnée, correspond le centre d'une moyenne/31 ans (donc la dernière valeur, c'est le centre de la moyenne sur 1983-2013 : 1998). -

Le meilleur rapport performance/prix pour l'anémo, c'est l'Ultimeter 100 (mesure des rafales au plus gros pas de temps en 0.5 s pour les très basses vitesses, en quelques centièmes de seconde pour les plus courtes dans les vents forts. Plus ça souffle fort et plus la console enregistre les rafales sur un pas de temps court) De plus à Noël, un logiciel et le pluvio pro sont offerts : http://www.peetbros.com/shop/category.aspx?catid=46

-

Changement de la sonde de température / humidité de la Vantage pro2

ChristianP a répondu à un sujet de Yannick35 dans Instrumentation

Salut Christophe, Pas sur le composant Sensirion, il faut obligatoirement un filtre, sinon il sera rapidement détruit s'il est exposé directement à la condensation et aux saletés. Tu peux bricoler un filtre maison qui laisse un minimum d'air autour du composant, comme préconisé par Sensirion, mais bon comme ton composant est soudé contre un gros support (Davis), ça ne le rendra pas beaucoup plus réactif. Pour mon montage maison du SHT75 traité dans un autre sujet de ce forum (et sur ma page FB), on ne peut pas faire mieux au niveau réactivité, vu que le filtre est contre le composant qui n 'est pas soudé sur une mini carte comme le SHT11 ou 15 de Yannick. Toujours pas de problèmes sur le SHT75 avec mon double filtre en téflon dans l'abri à ventilation méca à 6 m/s où la condensation abondante dégouline dessus. "Il pleut" souvent à partir du composant, dans cet abri où le capteur et son fil, récupèrent de la saleté et l'eau de condensation en quantité industrielle et qui n'a rien à voir avec celle captée dans un abri MF, où je n'ai jamais vu une goutte tomber du bout d'un capteur, même lorsque l'intérieur des parois de l'abri MF dégouline (juste des micro gouttes sur le capteur, mais jamais de quoi goutter), alors que c'est très courant sur les de mêmes capteurs placés dans le méca (pour ceux qui peuvent y entrer). A noter que j'ai testé aussi ce composant sur une Vantage Vue première version (premier firmware) et sur une console V2 ancienne non numérique avec un firmware très ancien (un qui ne se met pas à jour par le Net et qui nécessite l'updater), sans problèmes, mêmes valeurs, c'est la carte ISS numérique qui a l'air de faire le boulot. Le meilleur rapport précision+ qualité du montage/prix, c'est le capteur SHT15 de Yannick qui a fait un bon et beau boulot. Pour la réactivité il suffit juste de trouver un ruban de téflon plus large que dans mon cas, pour englober l'ensemble de la mini carte + composant au plus près, sans laisser de failles à l'eau (donc coller la base du filtre qui elle sera en amont) -

Datalogger Vantage Vue incompatible

ChristianP a répondu à un sujet de alsavosges dans Instrumentation

Oui, vu que Davis l'a indiqué en début d'année sur sa page FB, j'en ai d'ailleurs échangé un gratuitement cet été. -

Aucune ! MF/ l'OMM utilisent le seuil de rayonnement direct pour la mesure de la durée d'insolation, alors que le pyranomètre mesure le global (=diffus + direct). Donc pour l'insolation, soit tu laisses faire IC qui utilise la formule MF qui calcule la DI à partir des données d'un pyrano (/10 mn dans IC) et tu regardes dans ta climato IC le résultat, soit tu utilises le logiciel gratuit fourni pas un bénévole (pour traiter tes relevés plus finement, /1 mn, car sur 10 mn dans IC, même si en moyenne ça va s'équilibrer, sur un jour donné, c'est moins précis que sur 1 mn), dans un message où tu es passé il n'y a pas très longtemps dans ce forum (tu trouvais ça compliqué), soit tu utilises la feuille Excel que j'avais donnée il y a des années (un message en parle quelque part dans ce forum, je ne connais plus son adresse)

-

Datalogger Vantage Vue incompatible

ChristianP a répondu à un sujet de alsavosges dans Instrumentation

C'est une faute volontaire de Davis (on en a parlé dans le forum quelque part), il faut donc faire échanger gratuitement (sauf frais de port) ton ancien datalogger par Davis (par l'intermédiaire du fournisseur de ta nouvelle console), contre un nouveau datalogger à point vert, compatible aussi avec les consoles au firmware >= 3.0 (Pour les autres ne pas mettre à jour son firmware vers 3.x , si on ne dispose pas du nouveau datalogger à point vert) -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

An apparent hiatus in global warming? Kevin E. Trenberth, John T. Fasullo http://onlinelibrary.wiley.com/doi/10.1002/2013EF000165/full Voilà une raison de plus pour laquelle on ne peut pas s'appuyer sur des périodes courtes pour invalider arithmétiquement des modèles sur le fond ( tant que les modèles ne simulent pas correctement l'amplitude et la durée de certains bruits), comme avec le fait qu'on relève de rares paliers de plus de 15-16 ans dans les modèles (quand ce bruit qui ne change rien au fond, sera bien simulé, on verra probablement dans les modèles, la même chose que l'on observe dans les obs analysées mathématiquement : une banalité de ce genre de palier) et donc pourquoi en attendant, il faut continuer à ne s'occuper que de suivre/comparer l'évolution des grandes moyennes (d'au moins 30 ans) pour lesquels ils sont conçus. -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Oui Gpiton, la valeur de ma dernière tendance hybride/30 ans n'est pas la bonne. Elle est en fait sur 29 ans (sur 1984-2012 au lieu de 1984-2013), car sans données disponibles sur 2013. La dernière tendance hybride possible/30 ans pour le moment, est bien de 0.187°/déc +-0.053° sur 1983-2012. Ca, c'est bien un fait que tu aurais pu démontrer mathématiquement, si je n'avais pas été d'accord. C'est justement le problème sur d'autres points que tu abordes, ce ne sont pas des faits, et ils sont sans rapport avec les erreurs mathématiques de ton graphe. Je ne vois pas de tests mathématiques valides qui montrent un changement significatif sur le fond, en attendant que les mesures physiques tranchent dans le vif. Ton graphe de synthèse sur l'évolution des tendances décennales sur 30 ans n'est pas un fait (tu dis que ce n'est pas un super indicateur, mais tu persistes quand même à utiliser dans ta réponse cette estimation de 0.26°/déc vers 2013, sans aucun sens), tant que tu ne respecteras les règles mathématiques du modèle sur lequel tu t'appuies (le linéaire) et en général celles élémentaires en stats, dont une des plus fondamentales : le respect de l'indépendance des données. Avec ces tendances glissantes, en plus de ne pas respecter les changements significatifs, tu rends fortement dépendantes les données et donc tu traces une fausse tendance linéaire et tu en tires des conclusions exactement comme si les données /30 ans étaient indépendantes (avec les centres des tendances espacés d'au moins 30 ans). En fait tu ne peux réaliser aucune régression linéaire valide sur les tendances/30 ans glissantes pour ta droite rouge (et encore moins extrapoler), car le nombre de degrés de liberté effectif est ridicule, on ne peut rien faire. Tu n'as en réalité que 2 points indépendants possibles sans chevauchement de données. Donc ton estimation de 0.26°/déc en prolongeant cette droite, c'est exactement comme si tu nous affirmais que 1 + 1 = 0.26, ça ne repose sur aucune règle mathématique valide (sans parler du fait que la prévis centrale de 0.26°/déc , n'est pas donnée pour fin 2013, mais pour une moyenne atteinte dans 22 ans ! Si on suivait toujours ton raisonnement biaisé, cette valeur de 0.26°/déc sur ton graphe serait à pointer en 2035 pour comparer la pente théorique (toute aussi fausse) avec la tienne) Pour que ta synthèse d'évolution des tendances/30 ans soit correcte, il suffit juste de respecter les points de changements significatifs de tendance : et de présenter tes tendances/30 ans de cette façon : Là elles seront indépendantes. La droite entre 2 points donnés, n'est pas une régression linéaire. C'est une liaison comme tu la réalises naturellement entre deux anomalies annuelles (ou autres) de T qui se suivent, où personne ne tentera une régression, vu que dans ce cas tout le monde trouve naturellement, que ça n'a pas de sens de calculer une tendance avec 2 points. Pour adapter ce graphe, il suffit juste de réduire certaines tendances à 30 ans (le dernier segment est bien plus long) et donc corriger les IC en conséquence (avec le calculateur de SKS, tu y parviendras facilement, par contre pour le modèle d'auto-corrélation, il faut changer de gamme d'années pour que le modèle de bruit calculé concerne le bon segment) , tout en respectant l'indépendance des données si tu choisis une autre période dans un même segment, donc en maintenant au minimum 30 ans d'écart, entre le centre de chaque tendance décennale/30 ans. C'est correct mathématiquement si tu choisis dans un même segment, la tendance/30 ans que tu souhaites. Par exemple pour le dernier, c'est une de celles sur 1975-2004 à 1984-2013, même la plus faible des tendances de mon graphe (du précédent message) que tu trouveras si tu veux, car ce sont les mêmes tendances/30 ans dans un même segment sans changement significatif. Pour d'autres segments, tu n'as pas trop de choix, vu que les tendances/30 ans appartenant au même segment, ne peuvent être nombreuses dans une tendance qui ne dure guère plus de 30 ans sans changement significatif. C'est donc dans le dernier segment que tu as le plus de liberté, justement parce que le réchauffement se poursuit sur le fond plus longtemps que 30 ans, toujours avec la même vigueur sur ce fond (et non pas sur 10, ou 16 ans ou autres tendances et moyennes, internes, jusqu'à ce qu'elles soient significativement différentes de la tendance de fond antérieure), ce que montre justement le palier de ton graphe vers 2003, qui n'est qu'une preuve de plus que la tendance/30 ans n'a pas évolué significativement (la tendance/30 ans varie de quelques miettes, un changement pour une simple stabilité réelle, aurait affiché une nette baisse sur ta courbe, comme après 1945, étant donné qu'il faut bien que ta tendance /30 tombe à 0.05°/déc +-0.055° pour afficher une stabilité et ce n'est pas en gardant la même tendance/30 ans vers 0.17°/déc, mais en se réduisant nettement pour tomber à 0.05°/déc, qu'on arrive à une stagnation significative et différente) C'est un fait mathématique qu'il n'y a probablement pas de changements sur le fond avec une confiance à 95%. Tu as plus à l'air de tenter volontairement de le masquer par des moyens que tu sais invalides depuis le temps que tu lis sur ce sujet, alors qu'il en existe des bons et que tu les connais. Si tu veux présenter des faits qui contredisent mon affirmation basée sur les tests mathématiques conformes avec ce que nous dit la physique pour le moment, c'est très simple, présente nous des résultats de calculs de tests valides (même si ce n'est pas toi qui les effectue), qui montrent que le changement est significatif sur le fond. Ce sera un fait qu'il y a un changement significatif sur le fond, quand quelqu'un apportera au moins une preuve mathématique valide, en attendant que la physique détecte la véritable évolution sur le fond malgré la trop courte longueur du palier. Je le répète un fait se montre très facilement, aussi facilement que tu aurais pu le faire, si j'avais contesté le fait que la tendance hybride /30 ans, ne pouvait pas être calculée avec les données de 2013 non disponibles. Donc applique la même méthode pour appuyer ce que tu penses être des faits. Le vrai test arithmétique des prévis, c'est de vérifier la compatibilité de l'évolution de la moyenne /1984-2013 avec celle prévue /1984-2013 (Ne pas oublier les bases : le RC pour les prévis du GIEC, c'est avant tout, la prévision de l'évolution de l'état moyen) et non par rapport à celles prévues /30 ans pour 2030 ou 2035, car les valeurs actuelles peuvent largement évoluer et elles se testeront assez efficacement plus près de ces dates (donc pour 1984-2013, ce sont des valeurs virtuellement prévues, car générées par les modèles après des obs, surtout par l'AR4 et l'AR5, ce qui n'est pas un problème pour les projections classiques qui ne sont pas initialisées sur les anomalies observées) Sinon pour Zeke que je suis depuis des années, vu qu'il travaille sur un sujet qui me passionne, m'avait habitué à beaucoup mieux. Si tu ne sais pas le vérifier par toi-même, demande lui de nous montrer vers quelle année pendant notre période où ça diverge des modèles, sur la courbe centrale des modèles, la dérivée seconde indique une accélération significative ? Quand tu reviendras avec une dérivée seconde qui montre qu'on devait observer une accélération significative dans les modèles, je te dirais qu'effectivement c'est un fait. En attendant, c'est du bla-bla de blog. Il faudra être fort pour trouver une accélération significative sur la courbe centrale des modèles aussi rectiligne : Pour que la dérivée seconde indique une accélération significative, il faut un minimum de courbure générale et une pente générale assez différente après qu'avant la courbure, qui se verra quand même à l'oeil. La plupart des modèles de l'AR4 ne prévoyaient déjà pas d'accélération avant 2040-2050 (j'en ai déjà parlé à l'époque) et là avec ce qu'on a rapporté depuis plusieurs messages sur les prévis de l'AR5, c'est loin d'être le cas. Pour que ce soit un fait, que quelqu'un démontre mathématiquement où est l'accélération significative dans les prévis des modèles pour notre période. Pour le RC qui ralentirait, c'est toujours le raccourci habituel de nombreux scientifiques de qualité, quand ils parlent d'une période courte relativement plate. Je ne vais pas encore rappeler ce que sont les bases de l'évolution du climat et donc du RC, qui ne se joue pas à la petite semaine. Le fait est qu'il n'y a pas de changement significatif dans l'évolution de la moyenne/30 ans, le dernier échantillon de climat se réchauffe toujours. C'est un fait très simple à démonter mathématiquement, si je me trompe. Donc toujours pareil, apportez nous des résultats de tests valides et non des bla-bla. Là le fait est que depuis 99 les anomalies annuelles sont sous la courbe centrale des modèles du graphe, mais ce n'est pas encore significatif pour l'évolution de l'échantillon de climat, ni pour des modèles conçus surtout pour prévoir l'évolution de grandes moyennes (/30 ans au moins), malgré le fait qu'un palier de ce niveau, est rare dans les modèles, il ne l'est pas quand on analyse les obs réelles (j'ai déjà assez calculé d'IP et d'IC pour laisser à ceux qui contredisent ces faits, de présenter un minimum boulot) Quelque soit l'évolution par rapport aux prévis, les données futures sont toujours importantes, vu qu'on a pas une confiance à 100%, quelque soit le cas, tant qu'on n'a pas assez de mesures physiques de divers paramètres pour quantifier précisément les causes de chaque variation interne. -

Consommation électrique et météo

ChristianP a répondu à un sujet de lolo44 dans Météo, environnement et société

J'ai vu passer ça par hasard : http://climateandstuff.blogspot.fr/2013/11/french-nuclear-plants-have-problems.html http://www.gridwatch.templar.co.uk/ -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Pour montrer que ça ne sert à rien de suivre ces tendances décennales/30 ans sur ce genre de graphe, même en respectant le modèle, j'ai tracé les tendances décennales /30 ans et leurs IC, pour la série Hadcrut4 standard et l'hybride (il manque les derniers mois de 2013 pour la dernière sur 1984-2013) La première tendance décennale /30 ans débute donc en 75 vers le point du dernier changement significatif de tendance au pas mensuel, ceci pour que toutes les tendances appartiennent bien au même modèle linéaire (qui se terminera quand les données afficheront un nouveau changement significatif de tendance, soit pour une stabilisation, soit pour un réchauffement significativement plus important que l'actuel depuis 75, soit pour un refroidissement significatif) J'ai intégré aussi une des prévis de l'AR4 donnée ici, http://www.ipcc.ch/publications_and_data/ar4/wg1/en/ch10s10-es-1-mean-temperature.html . Je n'ai pas fourni celle de l'AR5, vu que les prévis sont revues à la baisse et ratissent plus large (avec un valeur basse de +0.3°en 30 ans sur 2016-2035 / la moyenne fin 2005, soit une tendance moyenne de 0.1°/déc/ 30 ans, ça fait un IC inférieur bleu (à la place de celui de l'AR4) qui se situerait pas loin des 0.04°/déc. Donc autant dire, qu'il faudrait une sacrée catastrophe naturelle pour que l'IC sup des obs se retrouve sous cette valeur ! Ne pas oublier que même la prévis de l'AR4 se jugera surtout vers 2030, car la courbe centrale a largement le temps d'évoluer, de monter ou de descendre, ce sont des tendances décennales moyennes/30 ans,nous ne sommes pas encore à la moitié de la période. Pour le moment, les obs décennales moyennes/30 ans sont largement dans les clous de cette prévis. J'aurais pris la cible habituelle des 0.2°/déc/30ans du scénario moyen, testé habituellement par les sceptiques aussi, les obs sont quasi parfaitement conformes avec la dernière tendance hybride de 0.196°/déc/30ans (pour le moment, rien n'est joué d'un point de vue mathématique, c'est plus probablement le cas d'un point de vue physique) Cette méthode est inutile pour détecter un changement significatif d'évolution des tendances, on le verra bien plus tôt avec celles que j'ai largement citées et expliquées x fois. Comme je l'ai aussi indiqué, pour la vérifications des prévis, il vaut mieux comparer les moyennes/30 ans indépendantes, pour minimiser l'importance de l'IC de 0.05° à 0.06° qui se situera autour des valeurs sur 30 ans et non pas sur des tendances décennales aux chiffres divisés /3 (l'IC est relativement plus important pour une tendance /10 ans en moyenne/30 ans, car pour une même moyenne donnée on peut observer différentes tendances internes du fait de la variabilité des données annuelles et de leur position par rapport au centre des tendances concernées). Donc pour invalider plus facilement la prévis, il vaut mieux comparer des moyennes plutôt que des tendances (Je parle d'un point de vue purement arithmétique et non physique, je le répète, car les prévis peuvent être mathématiquement très bonnes sans que physiquement tout soit aussi bon dans les modèles, et inversement, dans ce cas avec des obs exceptionnelles pour x autres raisons qu'un problème de physique et autres dans les modèles, qui ne sont pas conçus pour prévoir des obs exceptionnelles, mais les plus probables en moyenne) -

Alsavosges, un calibrage dans la console, ce serait beaucoup plus simple pour corriger la dérive du pluvio installé sur un toit (après un premier équilibrage préalable des augets pour qu'ils basculent avec une même quantité en moyenne), de plus ça permet de ne pas sortir les vis et donc ça évite de rendre le pluvio plus sensible à certaines sources d'erreur. Si Davis ne le fait pas, c'est que ce n'est pas assez rentable en attendant une éventuelle V3, ou bien ils n'ont pas terminé de de tester un éventuel nouveau système pluvio (ou pas assez approfondi celui de la Vue en version plus grande),ou pour une autre raison. En 92 il y avait le modèle Davis à siphon, vraiment à jeter directement à la poubs, il se bloquait très souvent (soit le siphon et/ou le flotteur aimanté. J'en ai passées des heures à bricoler pour résoudre ces problèmes, sans y parvenir. Sans le Net pour en discuter avec des utilisateurs, ça n'aidait pas !), le passage rapide au pluvio à augets a été un bonheur ! La pluie faible, régulière, continue et abondante (idéalement pour récolter au moins 30 basculements avec chaque auget) vraiment sans vent, sans rayonnement, sans évapo significative (air proche de la saturation) sont des conditions de terrain qui masqueront le moins les problèmes dus uniquement aux augets qu'on mettrait en évidence en labo avec un générateur d' intensités parfaitement calibrées et régulières. Il faut bien voir que scientifiquement notre méthode de réglage de prendre comme référence le SPIEA (ou autre pluvio de référence ) dans notre site, n'est pas correcte et n'est réalisée par aucun service météo pro au monde. Avec les vis on est sensé juste régler les augets par rapport à la quantité /à l'effet de l'eau tombant à partir du trou du cône et non pas en fonction des différences avec un pluvio qui viennent de problèmes de couleur, de forme, de matière, ou autres, de sites et d'emplacements très différents, dans x conditions différentes, qui font que le cône ne capte/ne transmet pas la quantité réellement tombée à 1 m du sol hors du pluvio ou que celle réellement récupérée par un SPIEA proche ou autre. MF ne règle les pluvio que pour l'erreur relative due aux augets et ne compense surtout pas une autre source d'erreur externe au mécanisme (même si un PM sous-estime de plus de 100% sur un toit très venté par rapport au SPIEA en bas, ils ne vont pas modifier le réglage d'un pluvio PM réglé scientifiquement, vu qu'il mesure ce qu'il est capable de récolter réellement dans ces conditions là où il se trouve, même si c'est archi faux dans l'absolu, avec cette forme, cette couleur, cette matière..., tout comme on ne règle pas notre thermo pour compenser, parce qu'il est mal installé dans un site classe 5, ou parce qu'il est dans un abri à ventilation naturelle insuffisant, tout comme on ne change pas le calibrage de l'anémo qu'on place à 2 m du sol près d'une haie pour compenser et coller à la valeur à 10 m de haut dans le même site. C'est l'homogénéisation des données qui s'occupera des problèmes de mesures absolues, des écarts qui sont dus à l'évolution des performances du matériel et des sites. Ca paraît naturel pour tout le monde de ne pas calibrer un capteur pour les x sources d'erreurs externes à l'électronique/mécanisme du capteur pour ces paramètres, mais personne ici (même pas moi ) n'appréciera cette rigueur scientifique pour la mesure de la pluie, car nous ne disposons pas de la courbe moyenne des Davis en fonction de l'intensité, ni de la courbe en fonction de la goutte au bout de l'auget et de son évolution au fil du temps. Donc de fait en cherchant à coller à un SPIEA sur site, on essaie de compenser toutes les sources d'écarts avec un SPIEA placé dans notre site, ce qui ça n'a plus rien à voir avec le réglage nécessaire pour l'erreur due à la pesée Davis qu'on déterminerait comme MF au labo avec des centaines de platines. Avec la méthode scientifique de réglage de MF, Il existe des écarts entre pluvio auto et SPIEA, plus importants que ce qu'on observe en réglant un pluvio Davis (ou autre) sur les relevés d'un SPIEA sur le même site. Par exemple, en moyenne nationale des sites classe 1, 2 et 3, MF a déterminé que le PM sous-estime de 7% par rapport au SPIEA , donc bien plus dans certains sites/régions et bien moins dans d'autres (résultats dans ces classes relativement bonnes, alors pour les RR des classes 4 et 5 non étudiées...) Tous les pluvio à augets "perdent" (ne pèsent pas) de l'eau entre chaque basculement à partir d'un certain niveau d'intensité qui laisse s'écouler de l'eau plus rapidement que le temps nécessaire au basculement. Je parle que du temps pour la période après avoir récolté la dernière goutte nécessaire au basculement et pas une de plus. Pendant ce temps, il faudrait que ce soit l'autre auget vide qui récolte déjà l'eau qui continue de tomber, ce qui est impossible à partir d'une certaine intensité. Le temps de basculement n'est pas assez court et variable d'un modèle à l'autre et même d'un pluvio à l'autre selon l'état (Chez MF les axes s'ovalisent au fil du temps, il y a aussi des micro algues invisibles à l'oeil. Ici la roue crantée qui guide le mouvement des augets du PM s'est bloquée parfois sans rien de visible avec une loupe. Je nettoie la roue à la brosse à dent et ça fonctionne à nouveau). Le temps de basculement d'après MF est d'environ 0.4 s sur un PM, je ne le connais pas pour la V2. Il me semble plus rapide sur le V2, mais surtout sur la Vue avec le contre poids qui rappelle brusquement l'auget unique, mais sans mesure objective et précise de ce temps, ce n'est qu'une impression perso. Tous les augets usagers retiennent aussi plus ou moins d'eau de pluie après la vidange, même ceux qui ne gardent pas une grosse goutte vers le bout. Ici celui de MF en inox, est couvert d'une fine couche d'eau après un basculement. Les PM avec certains augets en plastique rugueux d'origine, en gardent probablement plus. Si on n'intègre pas la courbe de correction en fonction de l'intensité, c'est logique pour éviter la sous-estimation en moyenne (aussi à cause des frottements variables), de devoir régler son pluvio pour qu'il bascule avec moins d'eau, pour une intensité moyenne plus importante qu'une intensité qui ne provoque pas de pertes, comme le faisait MF pour obtenir un bon réglage à une intensité de 60 mm/h. Dans un des cours de pluviométrie de MF (de 2002, ça a peut-être encore changé depuis), il est indiqué que le but, c'est de régler le PM pour récupérer 0% d'erreur relative à des intensités faibles de 3 mm/h, probablement parce que la courbe en fonction de l'intensité est intégrée maintenant dans les centrales d'acquisitions. Sur le Davis, c'est surtout à cause de la rétention d'eau et de la goutte au bout avec la longueur de l'auget, que le réglage nécessite proportionnellement un plus gros écart au fil du temps par rapport à la valeur théorique du poids dans l'auget /à la surface, vu que l'auget vraiment neuf est correct quand je le règle près de 4.1 g /4.2 g pour la première pluie, mais il dérive vraiment très rapidement au tout début (c'est variable, l'été, ça dégénère plus vite ici avec les saletés de la forêt sèche, l'évapo de la rosée) 3.9 g ce n'est donc qu' un exemple courant parmi d'autres possibles pour un Davis usager. Certains sont réglés à beaucoup moins vu que comme je l'ai indiqué, c'est variable, vu que nous utilisons une méthode qui ratisse toutes les sources variables d'écarts face à un SPIEA (ou autre) sur le site donné. Chez MF malgré la rigueur de l'établissement de la courbe nationale, l'auget de tous les pluvio du réseau ne sera pas réglé aussi sur le même poids, car le réglage utile est statistiquement valide sur une gamme donnée en temps et en nombre de basculements. Hors labo, sur le terrain en plus d'équilibrer, ils doivent le vérifier et le nettoyer tous les 6 mois en laissant s'écouler 1 l d'eau avec un débit donné assez continu avec un bouchon spécial calibrateur et ils doivent récupérer un certain nombre de basculements dans une gamme de temps donné pour un modèle de pluvio donné ( les valeurs pour le PM ne sont pas transposables aux autres modèles MF,ni au Davis, ils ont leurs propres gammes, que je ne connais pas pour le Davis, les données du Socrima très proches du mécanisme Davis, ne donnant pas de bons résultats) Exemple pour le PM : Le contrôle est positif si la durée d’écoulement de 1 l est comprise entre 450 et 750 s et le nombre de basculements est compris entre 46 et 49. Ici sur le PM pour correspondre le mieux aux relevés du SPIEA, je suis réglé à 19.2 g alors que ce n'est pas autorisé chez MF (la limite mini pour le poids dans un auget réglé par MF c'est 19.3 g, ça signifie que je compense un écart quelconque avec le SPIEA, autre que celui dû à la pesée) Sur l'année en cours depuis le 1er janvier au 28 novembre, j'ai récolté : 996.2 mm au PM (-3%) 1026.6 mm au SPIEA 1044.4 mm au V2 (+1.7%) Ce mois en cours : 103.0 mm au PM (-2%) 105.1 mm au SPIEA 106.4 mm au V2 (+1.2%) Pluies du mois récoltées comme souvent ici, en assez peu de temps sur un seul épisode ce mois, avec une partie sous le vent, des averses et de bonnes intensités : 80.2 mm au PM (-2.7%) 82.4 mm au SPIEA 83.6 mm au V2 (+1.5%) Petite pluie froide il y a quelques jours : 3.8 mm au PM (+5.5%) 3.6 mm au SPIEA 3.4 mm au V2 (-5.5% ou -11.0% selon le point de vue, car 0.2 mm "tombés" des heures après la fin de la pluie avec une vibration du vent fort, l'auget était plein à la limite de basculer) (La veille pluie froide, de la neige ne tenant pas au sol, 6.6 mm au V2, pour 6.4 mm au PM et 6.4 mm au SPIEA) Ca ne sert à rien de régler un pluvio sur ce genre de petits cumuls, regardez les écarts sur les cumuls mensuels de mois bien arrosés et les cumuls annuels si vous n'avez pas des épisodes de près de 100 mm et plus. Lobardot, l'ajout de matière pour équilibrer, le réglage des vis, font partie des réglages nécessaires aussi sur des pluvio pro. Donc si tu souhaites relever des valeurs proches du SPIEA chez toi, ça n'a aucun sens de ne pas régler ton pluvio qui de fait est déjà déréglé (vu qu'il est déséquilibré et qu'en prime tu constates de mauvais résultats même face au Lacrosse). Un pourcentage sous les vis est indiqué pour l'utilisateur, ce n'est pas fait pour décorer le pluvio. Un pluvio pro neuf est rarement réglé correctement après livraison, il faut vérifier le réglage et le régler si nécessaire juste après l'installation (Chez MF, malgré le fait que la platine passe au labo, ce qui n'est pas notre cas) La performance de ton Lacrosse n'est pas généralisable, car la mesure des RR est complexe et fait parfois bien les choses par hasard. On s'est aperçu qu'on ne pouvait déjà pas démontrer scientifiquement si un Pierron de 400 cm2 (pourtant manuel aussi) mesure ou non comme un SPIEA, avec les divers comparaisons des amateurs ici ou ailleurs,vu qu'on ne trouve pas les mêmes écarts, ni même de même sens. Il y a beaucoup trop d'autres causes principales d'écarts, que l'instrument lui-même. Il faudrait le tester dans un site de rêve calibré, avec peu de turbulences importantes, comme dans les essais de l'OMM face à des pluvio de référence enterrés à l'abri du vent. Vers Fréjus, il y a des années, avec un spécialiste de MF, on n'avait pas pu faire grand chose (à part conseiller de le déplacer, pour essayer d'éviter certaines turbulences, de bricoler un système de vis de réglage ou de changer de pluvio) sur un Lacrosse (le modèle rectangulaire sans vis) qui sous-estimait fortement par rapport au SPIEA. Comme ton Lacrosse est correct dans ton site aux emplacements actuels, tu peux virer le Davis (surtout si tu ne le règles pas) et brancher le Lacrosse directement sur la V2 (il suffit de vérifier le câblage sur le contacteur et la prise des deux pluvio, s'il est différent, refaire la prise avec les fils dans le bon ordre par rapport au V2) Même sur le matériel pro, les performances ne sont pas toujours transposables même sans aucune perturbation externe, vu qu'il existait pour le pauvre Degréane, un faible pourcentage de tous les exemplaires testés au labo par MF, qui donnait 0% d'erreur à 80 mm/h, mais aussi un faible pourcentage qui renvoyait plus de 10% d'erreur. Et ça c'est en labo, sur le terrain c'est pire, vu tout ce qui joue sur la mesure, même dans un site calibré, selon le climat du site, ça peut changer et en particulier dans les extrêmes ou dans des coins au climat trop différent même en France. Il ne faut pas s'occuper des écarts de rosée, vu que ce n'est pas un instrument prévu pour et de plus tu trouveras des écarts de rosée aussi même entre 2 SPIEA, car le plastique neuf (même d'un neuf à l'autre, j'ai vu des écarts de rosée ici, un des cônes, retenait plus l'eau, il "déperlait" plus) ne se comporte vraiment pas de la même façon que le plastique très usager du SPIEA plus performant pour faire s'écouler la rosée. L'été tu n'as pas fini de te morfondre avec des pertes de rosée importantes, avec l'auget qui ne bascule pas et qui perd la totalité par évaporation. Il faut voir qu'un jour de pluie est considéré à partir de 1 mm, ce qui est utile, d'autant plus que dans le réseau MF, il existe des pluvio pro avec des augets d'une résolution de 0.5 mm. L'important c'est de trouver un réglage moyen assez correct et ne pas s'occuper des énormités observées parfois avec du vent, sur les petits cumuls sans vent, avec la boue, avec la neige, la grêle ou l'été avec des averses... Quand on mesure à moins de 5% du SPIEA sur des épisodes de plus de 100 mm en peu de temps avec des intensités, sur le pas mensuel ou annuel, c'est à considérer comme parfait avec un pluvio à augets surtout sans intégrer la courbe de correction dans la console Davis. Il faut se concentrer sur l'écart moyen sur les gros épisodes, et surtout au pas mensuel annuel.

-

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Ce graphe est une technique habile de cueillette de cerises probablement involontaire si Gpiton en est l'auteur (mais pas si ça vient d'un blog quelconque), qui ne respecte pas les changements significatifs de tendance du modèle linéaire. Et oui, il est mathématiquement faux de tirer une tendance linéaire sur 30 ans pour ce cas, alors qu'à un moment dans une période de 30 ans, il y a un changement significatif de tendance! Donc pour le respecter, il faudrait virer tous les points qui n 'appartiennent pas au même modèle linéaire et ne montrer que les points où il y a accélération significative de tendance. Donc au final il ne restera que 4 points valides (par ex 1946-1974 environ, c'est un autre modèle linéaire que celui sur 1975-2013, de même celui sur 1916-1945 est significativement différent de celui qui a suivi, etc. Ex : on ne peut pas tirer une tendance sur 30 ans à cheval sur deux tendances différentes comme sur 1960 et 1989, etc...) Mais bon ça ne sert à rien de se casser la tête, j'ai déjà diffusé ces 4 points déterminés par Tamino et aussi parce que ce graphe ne montre qu'une fin d'accélération sans aucun sens (il n'y a pas d'accélération significative de tendance/30 ans au RC sur la période de la droite, l'accélération visible n'existe pas mathématiquement, donc la fin d'une accélération non significative, c'est du vent aussi. Les négativistes deviendraient complétement fous si un réchauffiste montrait une telle pente avec cette technique, pour faire croire qu'il y avait accélération de la tendance/30 ans du RC sur la période. Maintenant certains s'en servent à l'inverse, pour faire croire qu'il y a une régression/stabilisation de la tendance sur 30 ans, alors qu'elle n'a jamais accéléré sur la période, ni changé significativement depuis 75 !) C'est normal et artificiel que la pente de ce graphe change avec le chevauchement de données/30 ans avec des années où le réchauffement n'était pas présent (en ne respectant justement pas le changement significatif de tendance !) et vu que ce serait assez effroyable que la tendance/30 ans continue d'accélérer jusqu'à ce qu'elle devienne significative et donc plus chaude que prévu, ou pire qu'elle accélère sans fin ! Voilà encore un bel exemple de très mauvaise utilisation des stats en ne respectant pas les bases. Il n'y a pas de différence significative de tendance prévue/30 ans et observée, les variations affichées n'ayant aucun sens pour le fond, ça n'a donc absolument aucun sens d'attirer l'attention sur 2003, c'est de la pure cueillette de cerises, mais pire encore, vu qu'elle est basée sur le non respect du modèle utilisé, alors que d'habitude les négativistes se contentent de chercher des périodes courtes sans aucun sens, mais en respectant le modèle. Ce graphe n'a rien à voir avec un changement significatif ou non de tendance/30 ans, ou sur une régression de la tendance / 30 ans. Malgré un niveau plus élevé visuellement, Il n'y a aucune différence significative entre la tendance moderne et celle du réchauffement vers 1910- 1940, ce sont les mêmes tendances, la moderne dure simplement plus longtemps et n'a toujours pas changé significativement. -

Davis ne fait pas une erreur en choisissant de mesurer le temps pour récupérer 0.2 mm. C'est une autre façon de mesurer l'intensité instantanée qui n'est pas comparable à celle de l'OMM sur 1 mn, qui est un compromis conçu pour les performances des différents types de pluvio et de centrales d'acquisition en place dans les réseaux. C'est un peu la même histoire que la mesure des rafales, tous les services météo ne mesurent pas les rafales sur la même base de temps par rapport à la norme OMM. C'est bien pour cette raison que le Davis doit être bien équilibré, inutile de rajouter une couche d'incertitude à cause du réglage, à celle de base irréductible d'un pluvio à augets (sans intégrer dans le programme de la console la courbe spécifique des augets). Ca simplifierait bien des choses pour l'intensité, si Davis nous sortait pour la V2 ou la prochaine V3, le système à un seul auget de la Vantage Vue. Il ne resterait plus qu'à régler le pluvio pour obtenir de bons cumuls mensuels et annuels. Il est inutile de modifier le réglage du Davis au moindre gros écart journalier non systématique avec des pluvio de formes, de couleurs, de matériaux et de réactions différentes, d'autant plus avec du vent, avec des averses, du rayonnement et/ou dans des sites insuffisants, sans les brises vents du pluvio international (voir les photos des brises vent dans le réseau USCRN, le brise vent est souvent plus grand que les jardinets ou que les toitures chez les amateurs) et surtout pas avec de petits cumuls où les pourcentages de différences peuvent être importants pour x autres raisons que le réglage de base. La règle c'est de régler le pluvio neuf et souvent au début, vu que l'ajustement et la stabilité des pièces n'est pas du niveau de l'horlogerie de précision et que la rugosité des augets et les frottements évoluent rapidement avec des matières moins neuves et surtout avec les saletés spécifiques au site. Une matière neuve dans un pluvio dehors, ce n'est pas un état normal stable pour un réglage utile dans le temps. C'est l'état usager et normalement sale qui est habituel sur le terrain. Il faut donc trouver le bon réglage pour un état normalement sale sans entretien pendant des mois, hors après une pluie de boue et après un nettoyage à la fin d'une période de sécheresse qui va laisser un des augets souvent dans la même position sans assez de rosée pour le faire basculer souvent et qui sera bien plus sale que l'autre, ce qui modifie sa réaction par rapport à l'autre. L'équilibrage des augets Davis est nécessaire (ici au pistolet à colle, en ajoutant progressivement de la colle pour obtenir un équilibre parfait) afin que la pente soit la même et donc que la rétention/l'évacuation d'eau soit assez équivalente de chaque côté, surtout pour la mesure de l'intensité instantanée. Le défaut principal de ces augets Davis en plastique même sans alu, quand ils sont rodés, c'est qu' ils gardent une goutte plus ou moins grosse au bout, donc gros bras de levier sur ces augets particulièrement longs pour leur largeur, d'où des variations sensibles de la valeur cible d'un site à l'autre, mais aussi d'un pluvio à l'autre selon l'état des augets. Le Davis est bien plus sensible que les augets en inox dans ma version ( certains sont en plastiques) d'un Précis Mécanique de 1000 cm2 de MF avec un bout optimisé (vers le bout, il y a une pliure avec une pente bien plus importante que celle de l'auget penché, la goutte ne reste pas) Il faut bien voir qu'une même masse d'eau n'exerce pas la même action selon l'angle d'inclinaison de l'axe central, différent selon le réglage des vis. L'action des forces en jeu n'est pas linéaire. C'est pour cette raison qu'il suffit d'une infime goutte d'eau près des faibles inclinaisons, pour que l'auget bascule et pour que la densité de l'eau et les frottements supplémentaires avec des T froides (avec la rétractation des matériaux) jouent beaucoup plus sur un auget Davis qui est proportionnellement bien plus long et plus léger qu'un auget MF. Il faut aussi équilibrer pour éviter que les vis arrivent en butée haute ou basse, avant de pouvoir régler la même valeur dans les deux augets pour provoquer un basculement (c'est parfois hors capacité des vis à cause du défaut d'équilibrage) Voici un tableau de l'intensité instantanée théorique qui serait relevée selon l'écart de poids du réglage par rapport à la valeur cible de 3.9 g pour un Davis bien réglé pour les quantités et qui ne sous-estime pas le cumul dans les fortes intensités, ceci sans aucune vibration, ni vent, sans tenir compte de l' incertitude intrinsèque des augets et autres qui jouent. Donc en fait dans la réalité la différence est plus ou moins importante que cette valeur, mais dans les faibles intensités, selon le moment de l'intensité maxi, on peut observer une sous-estimation (et oui à 10 mm/h, en 72 s, par ex, le maxi de l'intensité peut se produire dans les 0.2 mm de l'auget le plus "lourd", ce qui arrivera très rarement sur quelques secondes dans les fortes intensités, où la surestimation est la règle dans un pluvio bien réglé en quantité, mais pas équilibré. L'intensité maxi très forte est soutenue un moment relativement long par rapport à une rafale de vent.) http://meteo.besse83.free.fr/imfix/intensit%e9%20augets%20%e9carts.png Pour un Précis Mécanique de 1000 cm2, avec une cible du réglage de 19.3 à 20 g (donnée MF), MF tolère donc moins de 4% d'écart entre les 2 augets (donc par rapport à la valeur cible centrale, c'est équivalent à moins de 2% par rapport aux 5.1% donnés dans ma première colonne) Pour un Degréane, l'ancien pluvio hors de prix (mais nouveau par rapport au PM) et mal conçu, retiré progressivement du réseau MF, pour un réglage vers 8 g, un écart entre les 2 augets de 0.2 g est considéré comme parfait. Donc pour un Davis près de 4 g, un réglage parfait c'est plutôt vers 0.1 g d'écart (écart moyen sur au moins 30 basculements pour chaque auget, effectués à la pipette/seringue, cône en place, l'ensemble mouillé tout en évitant d'injecter une ou des gouttes pendant le basculement, donc c'est long à régler.) Il y a deux possibilités pour équilibrer une fois que la platine est bien de niveau. Soit on ajoute de la colle au pistolet (ou autres tant que c'est stable) progressivement vers le dessous du bout de l'auget trop léger, jusqu'à obtenir un équilibre parfait (ce qui est très simple), soit on retire l'adaptateur métrique (qui lui même provoque un déséquilibre complètement différent ici sur tous mes pluvio. Essayez avec et sans adaptateur métrique et vous m'en direz des nouvelles. Ici je ne garde jamais cet adaptateur, mais bon sur la dernière version de V2, il n'y avait pas le choix, j'ai récupéré un aimant standard sur un ancien pluvio) et on ajoute la colle à sa place sur l'aimant, mais de façon excentrée, plus du côté de l'auget trop léger (platine parfaitement de niveau) jusqu'au bon l'équilibre (ici même avec un petit peu de vent, le cône retiré, l'auget rééquilibré oscille en restant à l'équilibre instable sans basculer, on peut donc obtenir un très bon résultat) Cet adaptateur métrique est utile pour garder les vis à leur place et assez enfoncées sans modifier le réglage par rapport au réglage US (si on le retire on doit dévisser plus les vis et donc diminuer la pente pour faire basculer pour 0.2 mm). Il est indispensable sur le Davis, de faire en sorte de garder les vis assez enfoncées, pour obtenir un réglage plus stable et moins sensibles et donc parvenir pour une même quantité cible de 3.9 g (par ex) , afin d'obtenir un angle central important, plutôt que faible. A titre d'exemple, sur un auget 2 fois plus lourd, proportionnellement environ 2 fois moins long, d'après la courbe en fonction de l'angle d'inclinaison donnée par MF, si on faisait basculer cet auget à 29° (angle de l'axe central) en passant de 30 à 29° (donc pour une variation de 1°) il faudrait ajouter 0.79 g, alors que si on provoquait le basculement avec un angle de 15° en montant les vis, il ne faut plus que 0.3 g pour passer de 16° à 15°. Bien entendu, il ne faut pas dépasser une certaine limite (angle de 45° quand tout est bien conçu et équilibré dans l'exemple de MF) pour éviter de le rendre insensible à une quantité industrielle d'eau, quand le centre de gravité se retrouve dans l'axe de rotation où une quantité infinie d'eau, sans aucune autre force, laissera les augets en équilibre (instable) sans jamais basculer. Mais bon sur le Davis, l'eau débordera avant par la paroi centrale pas assez haute, l'auget ne basculera pas dans ce cas avec des augets en alu neufs, les vis totalement enfoncées avec un cône de 400 cm2, l'eau déborde par le centre. Les anciens augets noirs rectangulaires de la Monitor2 et des premières V2 étaient bien équilibrés et ici c'est certain que ça ne vient pas d'ailleurs, car j'avais permuté des augets alu sur les installations, pour vérifier si ça venait du reste ou bien de l'auget alu. Plus l'auget est léger, proportionnellement long par rapport à sa largeur, plus la pente du réglage de base est faible (vis très sorties pour obtenir un basculement pour un même poids d'eau donné) et plus il faut que le réglage soit précis, car l'auget sera trop sensible à tout ce qui génère des erreurs (vent, vibrations, frottements variables, incertitude de la pesée, variations du débit d'eau direct dans les augets qui provoquent des mouvements d'eau dans l'auget,...), d'autant plus pour le Davis qui ne pèse pas de façon assez régulière à cause de ce problème de la rétention de goutte sur le bout. Une goutte qu'on peut rendre relativement constante en ne nettoyant surtout jamais les augets à fond et/ou avec des produits. Ici je règle le pluvio Davis pour qu'il me donne les mêmes valeurs que le PM et le SPIEA pour des intensités régulières de moins de 5 mm/h sur les cumuls de pluies continues de plus 10 mm sans vent, sans averses, sans rayonnement significatif (de nuit), pour des T entre 0 et 5°, vu que le Davis est très sensible à la T comparé au PM. Je ne fignole uniquement l'équilibrage, que s'il a un défaut après un nettoyage de fin d'été après une sécheresse, vu qu'en bougeant à la main les augets, parfois on modifie certains frottements (faire en sorte de centrer les augets latéralement pour que la partie centrale ne touche pas les bornes latérales), mais sans toucher au réglage de fond hivernal qui garde le même poids au total de 2 basculements même quand ça surestime l'été. Ici aucun pluvio Davis bien réglé ne sous-estime les quantités dans les fortes intensités (hors pluie de boue qui dégrade en temps réel très rapidement la mesure), au contraire il a tendance à surestimer pour un bon réglage comme le PM dans les faibles intensités l'hiver. Ce n'est pas normal que l'intensité ne soit pas sous-estimée sur le Davis comme rapporté par l'OMM et je me demande d'ailleurs parfois si Davis n'intègre pas dans la console V2, la courbe des augets en fonction de l'intensité, comme le fait MF sur ses stations pour le PM. Sinon il est aussi possible qu'à l'OMM l'auget n'était pas assez vieux et que l'onde de choc directe du débit plus fort qui tombe dans l'auget Davis bien usager, compense les pertes d'eau entre chaque basculement. Plus il pleut fort et plus l'eau qui tombe provoque des mouvements qui déplacent le centre de gravité (le trou du Davis est proportionnellement plus gros que celui du PM, d'où une gamme de mesure de l'intensité forte plus importante (environ 10 fois plus), l'eau ne peut s'accumuler dans le cône du Davis qu'à des intensités bien plus fortes que sur le PM, trop limité à ce niveau. De plus le PM a un amortisseur/récupérateur de chute d'eau avec un des déflecteurs sensés diminuer les pertes par forte intensité, qui captent l'eau à ras de l'auget en position, l'eau tombe moins fort et de moins haut de ces déflecteurs ) Le pluvio Davis n'est vraiment pas cher et ajouter un peu de colle ou autres pour équilibrer, c'est rien du tout, comparé à l'arnaque qui est pour moi, que du matériel pro à augets, qui ont tous les mêmes genres de défauts connus depuis toujours, plus de 10 fois plus cher que le Davis, ne soit pas très largement supérieur au Davis dans les essais indépendants de l'OMM et ici (je rappelle que le Davis a obtenu autant d'étoiles à l'OMM (3/5) que le Précis Mécanique) ! Le pire c'est que je pensais que le métal du PM allait être robuste sous la grêle, mais non, même pas ! Ici les seuls pluvio endommagés par la grêle de 3 cm, ce sont les pluvio MF, le SPIEA (logique en plastique cassant digne de Pif gadget), mais plus surprenant, aussi le tranchant du cône en métal du Précis Mécanique de 1000 cm2, alors que les 4 cônes Davis dehors, y compris le plus ancien de plus de 20 ans, n'ont rien et ne sont même pas un peu émoussés, le tranchant est comme neuf, alors que l'ancien a déjà reçu de la grêle de 4 à 5 cm qui m'avait fracassé un SPIEA (je n'avais pas de PM à l 'époque), mais pas l'anémo Davis à petit moulinet sur cette période (au cours d'un mois de septembre (94 il me semble de mémoire), la grêle avait fait de gros dégâts par endroits dans le Var, en tuant des poules à Solliés-Pont, elle avait cassé pas mal de serres et aussi des vitrines vers Ollioules...). Ce plastique noir utilisé sur les pluvio Davis est assez incroyable) Si vous voulez un pluvio auto plus précis et sans réglages, ne prenez surtout pas un pluvio à deux augets, quelque soit l'énormité de son prix. Mais bon mettre vraiment le prix pour utiliser un pluvio plus précis, avant d'installer les brises vent visibles dans l'USCRN, ça ne sert à rien. C'est le vent (suivi de l'implantation dans un site insuffisant), la principale cause de l'incertitude de la mesure des RR et non le pluvio à augets qu'il soit Davis ou non (il vaut même mieux récupérer le Degréane à la casse (retiré du réseau) et l'installer avec le brise vent, que d'installer un SPIEA ou autres sans ce brise vent ). Tout ça c'est du pinaillage de première de passionnés, sans le bon brise vent et sans un bon site de mesure. Donc prenez le pluvio auto le moins cher possible avec une possibilité de réglage (et oui certains n'ont pas de vis !) et le moins d'augets, c'est l'essentiel sans un bon site et sans le brise vent.

-

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Williams, la correction de la T globale avec l'estimation sur l'Arctique est infime, vu qu'on reste dans l'incertitude de la série standard, mais comme d'habitude tu ne perçois pas la différence quand les scientifiques règlent des détails infimes qui ne changent absolument rien à la validité de fond des données. Il n'y a absolument aucun changement significatif dans ces données de T globales pour pouvoir dire que les données sont bidons, qu'on ne peut pas s'y fier. Ton problème c'est que tu ne comprends toujours pas que la moindre variation de T fait bouger des tendances courtes qui n'ont aucun sens, vu les incertitudes, non pas celles des mesures, mais de l'estimation d'une moyenne ou d'une tendance avec trop peu d'années (tant que tu comprendras pas l'importance de la variabilité dans l'estimation du paramètre concerné, tu planeras) Regarde la courbe communiquée par Gpiton dans le message plus haut, la version hybride de l'étude est présente. On ne peut pas dire que la différence change le fait que la courbe est en bas de la gamme. Tu peux étudier différentes tendances des ces deux séries, il n'y a aucune différence significative de tendance entre deux tendances courtes sur 10, 15-16 ans ( ex Hadley standard depuis 98 : 0.040 ±0.142 °C/déc et Hadley hybride depuis 98 : 0.115 ±0.144 °C/déc ) ou autres, ou de bien plus longues. Ce sont les mêmes tendances vu que les IC se croisent. C'est du réglage fin des séries et il faut s'attendre comme je le martèle depuis longtemps ici, à des corrections fines qui accentueront le RC de façon non significative, sans rien changer au fond, vu que même si on avait disposé que de 60 stations avec des thermo en plein soleil sans abri, bien réparties dans le monde, on aurait récupéré le signal de fond de l'évolution de la T. Jeje38, le problème principal pour la T globale, n'est pas l'ICU vu qu'on homogénéise les données et que même les vrais sceptiques qui ont publié sur ce sujet, n'ont pu que constater en établissant leur propre série globale conçue pour traiter le problème de l'ICU, des tendances au RC plus fortes que d'autres séries. Maintenant au niveau de la T globale, ce ne sera plus que de l'affinage, il ne faut pas s'attendre à des changements significatifs. On va continuer au fil des progrès et du temps à refroidir les T mesurées avec les techniques modernes, jusqu'à ce qu'on parvienne à mesurer la T vraie de l'air sans aucun biais radiatif en plein jour. Donc il faudra encore corriger à la baisse les séries anciennes (celles qu'on relève actuellement sont trop chaudes par rapport à celles qu'on relèvera dans le futur) Gpiton, la différence n'est vraiment pas nette contrairement à ce que tu indiques, vu qu'il n'y a pas une différence significative entre 0.25° ou 0.26° +-0.0x°/déc/30 ans et 0.17° +-0.06°/ déc/ 30 ans. La version hybride du graphe ne change rien, elle n'est pas significativement différente de la version standard. Elle donne une pente qu'en apparence plus forte de +0.196° /déc +-0.055° / 30 ans (pratiquement, tendance calculée depuis janvier 1984, modèle de bruit auto-corrélé calculé sur 75-2012 inclus), ce qui ne change rien au fond. Contrairement ce que tu indiques dans un message précédent au sujet d'un possible raté des prévis de T pour 2035, ce ne serait toujours pas une démonstration d'un problème pour la sensibilité, vu que ça dépendrait de la cause de l'écart avec la prévis. Il faudrait être capable de boucler un bilan énergétique avec des mesures physiques plus précises et plus nombreuses des paramètres nécessaires pour vraiment quantifier la sensibilité correctement. Si la chaleur s'accumule dans l'océan et qu'elle est relâchée plus ou moins en fonction d'une éventuelle oscillation de 60/65 ans, elle pourrait ressortir vigoureusement qu'après 2035 et rattraper le retard significatif plus tard, pour afficher plus que la hausse attendue qu'après (au moment du pic de l'oscillation). Ce serait un simple problème de timing à cause du bruit de l'oscillation qui serait zappé par les modèles actuels, mais qui ne changerait absolument rien à la prévis de fond et à la sensibilité à l'équilibre. Dans cet ancien message par exemple, j'indiquais l'effet possible vers 2037 de la présence de ce genre d'oscillation (Si ce n'est déjà fait, tu peux lire d'autres messages et pages à la suite, vu que certains parlent de la sensibilité, dont Sirius qui maitrise ce sujet ): /topic/40167-statistiques-et-anomalies-climatiques-globales/page-29#entry1603110'>http://forums.infoclimat.fr/topic/40167-statistiques-et-anomalies-climatiques-globales/page-29#entry1603110 Il n'y a pas de bonnes nouvelles quelque soit le cas de figure et encore moins si la prévis ne collait pas en 2035, vu qu'on continuera à trop surconsommer les ressources et à exterminer son prochain indirectement ou non, à cause du modèle exponentiel actuel qu'on s'acharne à poursuivre, comme si c'était physiquement possible qu'il soit infini. Avec des prévis de T foireuses, on ira simplement légèrement plus vite vers le mur des ressources finies. Rien de significatif ne sera fait volontairement, quoiqu'il arrive au niveau de la T d'ici 2035, pas plus qu'on ne fait grand chose pour supprimer la famine dans le monde (ou pour d'autres gros symptômes dus à ce modèle), des problèmes autrement plus anciens, plus simples à régler et encore plus certains que le RC. De plus c'est certain avec un IC de 100%, que la majorité des "démocraties" préfère dans les faits (les paroles ne sont pas des actes), toujours soutenir le modèle actuel qui permet à quelques individus, "les meilleurs" selon la loi de la jungle actuelle (loi de la compétitivité, du plus fort), de pouvoir détenir l'équivalent des PIB de plusieurs pays et de surconsommer sans absolument aucune limite, tout en laissant des millions de personnes crever. Donc tant que l'homme sera plus proche du modèle suivi par l'animal, il n' y a pas à espérer quoique ce soit de significatif avec ou sans bon diagnostic dans n'importe quel domaine, d'autant plus qu'il y en a eu au moins un diagnostic assez correct en 1972 (le rapport Meadows) et rien n'a changé fondamentalement depuis. http://www.google.fr/imgres?client=firefox-a&sa=X&rls=org.mozilla:fr:official&channel=fflb&tbm=isch&tbnid=-vM5HWoQkHM4jM:&imgrefurl=http://blogs.mediapart.fr/blog/jean-paul-baquiast/080412/1972-2012-le-club-de-rome-confirme-la-date-de-la-catastrophe&docid=i16MDTCiZ_NRAM&imgurl=http://www.admiroutes.asso.fr/larevue/2012/126/Futurism-Got-Corn-graph-631-thumb.jpg&w=631&h=517&ei=q1t3UtGPBvCY1AWxt4CoDg&zoom=1&iact=hc&dur=2654&page=1&tbnh=123&tbnw=150&start=0&ndsp=22&ved=1t:429,r:0,s:0,i:82&tx=133&ty=93&vpx=4&vpy=179&hovh=203&hovw=248&biw=999&bih=655 -

Suivi du temps dans les régions Méditerranéennes

ChristianP a répondu à un sujet de maxime-aix dans Le temps en France

Toujours pas de première gelée à Besse, Tnn de cette nouvelle saison froide, non pas en fin de nuit, mais en plein midi solaire aujourd'hui avec 0.9° sous une chute de neige ne tenant pas au sol. Que l'été prochain me semble très loin ! -

Niveau des océans : suivi et perspectives

ChristianP a répondu à un sujet de TreizeVents dans Evolution du climat

Pour une fois je vais faire très court http://www.yaleclimatemediaforum.org/2013/10/ipccs-new-estimates-for-increased-sea-level-rise/ http://tidesandcurrents.noaa.gov/sltrends/sltrends_station.shtml?stnid=8724580 http://tidesandcurrents.noaa.gov/sltrends/sltrends_station.shtml?stnid=8723170 http://tidesandcurrents.noaa.gov/sltrends/msltrendstable.htm http://tidesandcurrents.noaa.gov/sltrends/sltrends_global.shtml http://sealevel.colorado.edu/content/regional-sea-level-time-series http://www.centre-cired.fr/spip.php?article548 -

Suivi de l'englacement au pôle nord

ChristianP a répondu à un sujet de sirius dans Evolution du climat