ChristianP

Adhérent Infoclimat-

Compteur de contenus

2904 -

Inscription

-

Dernière visite

-

Jours gagnés

1

Type de contenu

Profils

Forums

Calendrier

Tout ce qui a été posté par ChristianP

-

Suivi du temps dans les régions Méditerranéennes, Janvier 2022

ChristianP a répondu à un sujet de couleur du ciel dans Le temps en France

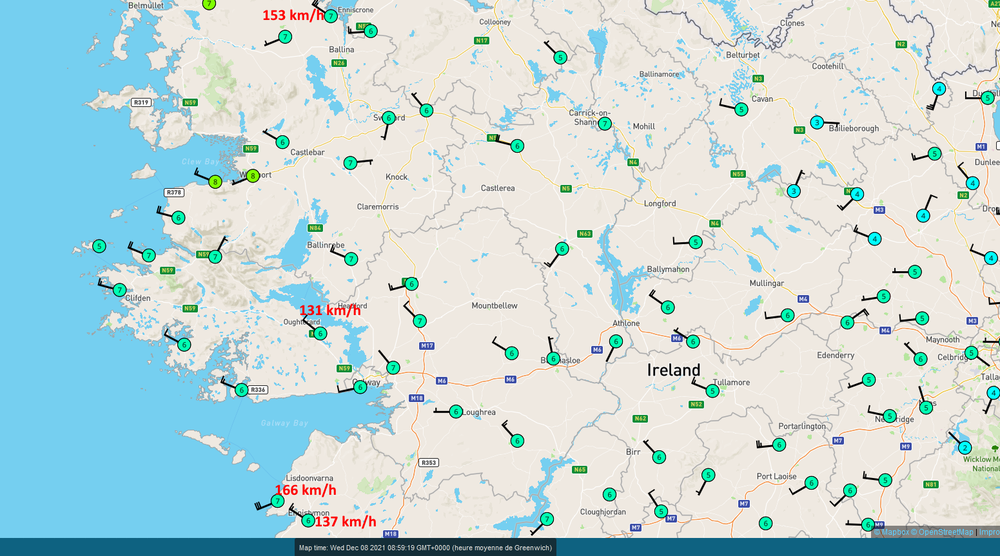

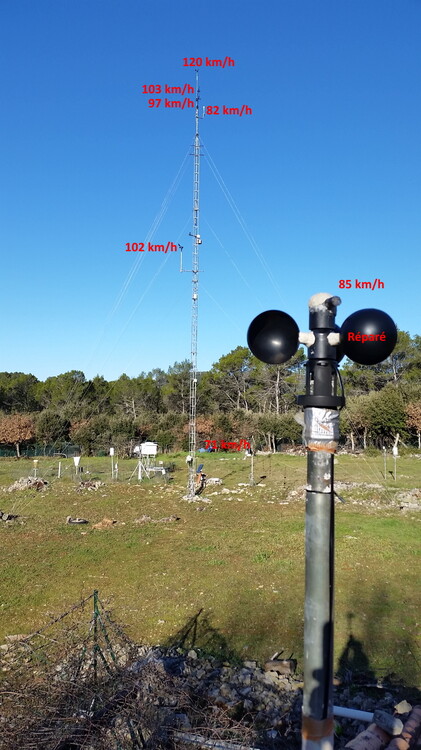

Amélioration à 130 km/h à 17.5 m, à 3 km/h du record absolu de cet anémo. 116 km/h au Davis V2, à 8 km/h du record absolu de cet anémo. Autres valeurs à différents niveaux pendant que j'étais avec les pompiers... https://www.facebook.com/meteobesse.stationmeteo/posts/2156576451173811 Modèles, disposition, et hauteurs des anémo : https://www.facebook.com/meteobesse.stationmeteo/posts/2156353047862818 -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

Salut Sastrugis, oui sur 1976-2005. -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

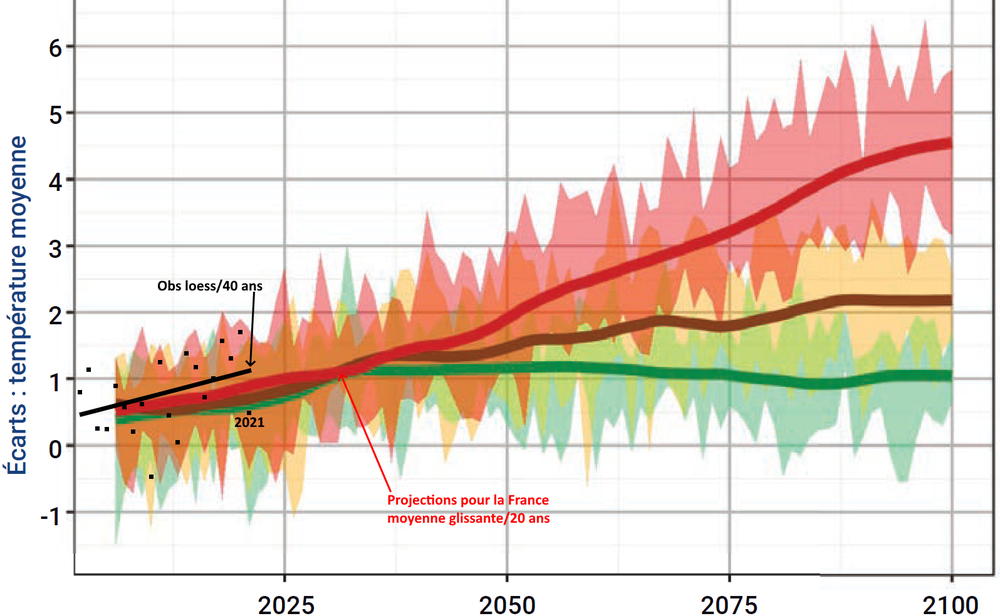

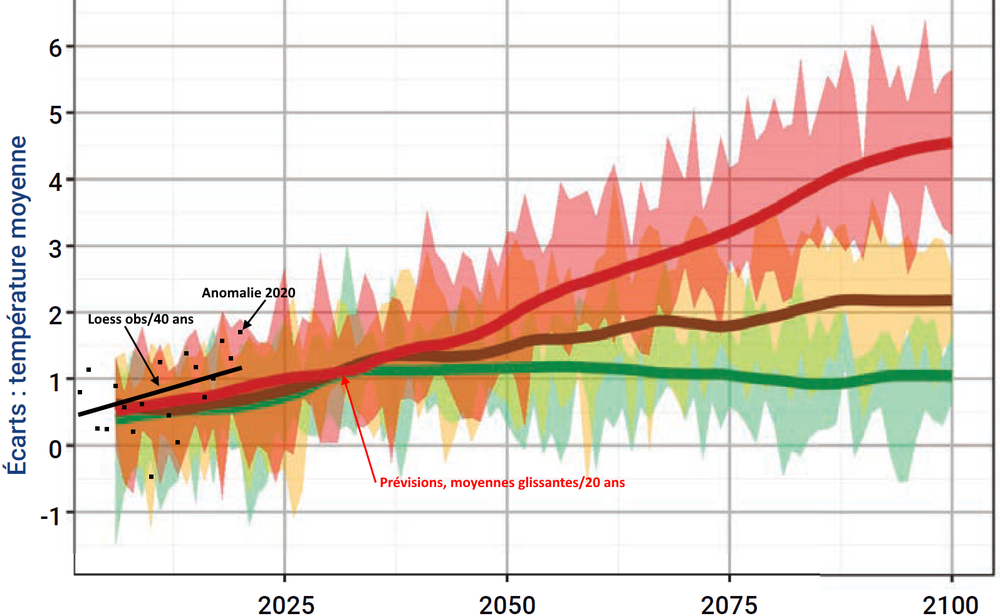

Mise à jour de la comparaison des T observées avec les projections pour la France : Graphe sans les obs dans : http://www.drias-climat.fr/document/rapport-DRIAS-2020-red3-2.pdf -

Suivi du temps dans les régions Méditerranéennes, Janvier 2022

ChristianP a répondu à un sujet de couleur du ciel dans Le temps en France

"Quelques" températures hier matin (13/01/2022) dans le Var, derrière la Ste Baume et ici : https://www.facebook.com/meteobesse.stationmeteo/posts/2143667055798084 -

Impossible d'être affirmatif sans infos sur le matériel, mais c'est cohérent avec l'exposition par rapport aux 137 km/h proches bien dans les terres et dans les graphes. A noter que les comparaisons des mesures officielles en GB avec les rafales de la France sont biaisées, car leurs rafales sont plus faibles sur 3s par rapport à MF sur 0.5s (ou 0.25 s sur les soniques ?), d'autant plus que le vent est fort (Ex en 99 à l'ex DSO de Trappes et CDM : 151 km/h sur 0.5s pour 134 km/h/3s, 133 km/h/0.5s pour 115 km/h/3s)

- 250 réponses

-

- 1

-

-

- neige

- tempète emma

-

(et 1 en plus)

Étiqueté avec :

-

Un MétéoTracker est passé à la Brévine, voir sur la photo du graphe concerné, le profil autour. https://www.facebook.com/MeteoTracker/posts/484988953230965 Je teste ce matériel; il est beaucoup plus réactif que les thermo des 3 voitures essayées. C'est très intéressant en se baladant dans la nature à vélo, en ski ou à pied pour trouver des points froids/chauds auxquels on ne pense pas, ou inversement. C'est sympa de pouvoir incruster les T automatiquement à la position exacte dans les photos Street View ou celles de l'appareil photo du smart. https://www.facebook.com/meteobesse.stationmeteo/posts/2124866547678135 https://www.facebook.com/meteobesse.stationmeteo/posts/2131953443636112 Sur leur site vous pouvez retrouver et explorer divers parcours publics dans le monde : https://app.meteotracker.com/ https://www.meteotracker.com/en/instant-and-accurate-measurements-even-under-solar-exposure-for-correct-data-acquisition-in-mobility-the-meteotracker-solution/ https://www.indiegogo.com/projects/meteotracker-weather-station-for-data-on-the-move/x/28199566#/

-

Suivi du temps dans les régions méditerranéennes-décembre 2021

ChristianP a répondu à un sujet de Toulnono83 dans Le temps en France

12 Tx sous abri normalisé sur mon terrain hier : https://www.facebook.com/meteobesse.stationmeteo/posts/2132680890230034 -

Quelques maxi d'amateurs vus sur Wunderground (Certaines stations de ces valeurs ne sont visibles qu'en zoomant)

- 250 réponses

-

- 2

-

-

- neige

- tempète emma

-

(et 1 en plus)

Étiqueté avec :

-

Suivi du temps dans les régions Méditerranéennes - août 2021

ChristianP a répondu à un sujet de Toulnono83 dans Le temps en France

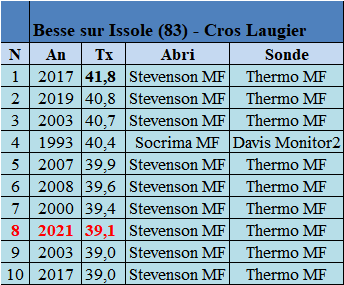

Les 10 plus hautes températures depuis 1993. Quelques images et mesures IR dans la fournaise du parc à instruments : https://www.facebook.com/meteobesse.stationmeteo/posts/2025354524296005 -

Suivi de la canicule en Amérique du Nord - Juin -Juillet 2021

ChristianP a répondu à un sujet de Hugo_HK dans Amérique du Nord

Pour Lytton, la valeur la plus haute est probablement celle du Stevenson bien placé du réseau de RCS (Reference Climate Station), donc sauf manque de sérieux dans le SMC, c'est de la haute qualité pour le suivi du climat sur le long terme, donc supérieur en maintenance de site, en suivi du matériel par rapport aux records nationaux français. Pour moi hors réseau USCRN haut de gamme, c'est le top de relever un record national dans une RCS dans un tel site, quand je vois ce qu'il se passe ici ou là dans le monde. Là c'est le modèle de Stevenson avec un tube + cheminée pour la ventilation méca d'un psychromètre, mais pas obligatoirement toujours activé chez eux d'après le SMC. Ce Stevenson plus lumineux avec cette conception et aussi d'après des comparaisons pro avec d'autres petits abris modernes (non MF), est à mon avis légèrement plus chaud qu'un Stevenson MF. L'autre station, la NAVCAN doit être probablement cet abri ventilé méca en bout de site pas loin des arbres, que j'ai extrait des photos de Thierry G. : http://meteo.besse83.free.fr/imfix/lytton2statvenm%e9capng.png où d'ailleurs sur les photos globales, on voit que le mât aéro au marquage bien spécifique et tout leur matos qui ne concernent pas une RCS, se situent au fond. On voit aussi bien plus clairement ce modèle qui semble être un Young méca utilisé chez NAVCAN ici : https://twitter.com/navcanada/status/1406212737676496896/photo/2 avec la coupelle et la chambre identiques à mon modèle ventilé méca Young (ici en version courte). Je ne sais plus si c'est toujours le cas actuellement et depuis les essais d'abris OMM en Algérie où c'est le modèle allemand ventilé méca du record national invalidé qui a été la référence relative, MF utilisait un Young méca long (mais avec un sommet plus large au dessus de la chambre pour accueillir une tête énorme de Pt 1000 spécifique Young) comme référence relative, mais bon malheureusement pas avec un lissage correct pour tenir compte du changement considérable de la constante de temps du capteur sous cette ventilation méca puissante, comme ça été étudié justement pour l'USCRN, qui s'était planté lamentablement au début de l'installation de ce réseau avec le lissage standard sur 1 mn pour déterminer les T, Tx, Tn. Ils ont vite constaté que les Tx n'étaient pas au top l'été dans les régions chaudes et sèches surtout. Ils sont passés sur des moy/ 5 mn glissantes toutes les 10s pour leur Pt 1000 avec une constante de temps de 60s sous 1 m/s dans l'air. On peut voir clairement par exemple ce problème ici et donc la difficulté avec les autres mesures et abris, pour parvenir à comparer ce qui est comparable, pendant mon record absolu en août 2017 (Les Pt 1000 ont la même constante de temps que celles de l'USCRN) : http://meteo.besse83.free.fr/imfix/recordbes05082017.jpg Malheureusement en juin 2019 pendant les 45° à 18 km d'ici à Brignoles restée sous vent de terre, ici je me suis retrouvé tôt sous la maudite brise de mer habituelle, donc que 40.7°... Donc pour le site de Lytton au niveau de la classification spécifique de cette Tx en cette saison pour le Stevenson RCS, d'après les mesures de site sur Google Earth, hors ombres portées qui ne jouent pas sur ces Tx estivales dans ce type de temps, le rayon de 30 m est assez propre, la végétation courte bien plus entretenue sur une très grande étendue ce jour là que pendant notre record national, c'est une Tx classe 2 (classe 4 pour la Tx du ventilé méca NAVCAM seulement si le vent est venu des arbres proches pour cette Tx de cet abri , car quand le vent vient des secteurs dégagés pour tous les abris ici, ça ne joue pas sur ces Tx, aucune différence significative, hors Cimel en classe 2 ou 4 qui surchauffe même avec le vent soutenu, et l'abri méca reste plus frais malgré le vent). L'écart avec un lissage correct est tout à fait habituel et normal entre un bon ventilé méca face à un Stevenson MF. Il faudrait connaître la façon de lisser la T de NAVCAM dans leur abri ventilé méca et la constante de temps de leur sonde. Si l'abri ventilé méca avait été placé dans la zone du Stevenson RCS plus dégagé, et que le vent venait des arbres très proches de l'emplacement actuel autour de la Tx absolue, il aurait relevé encore moins (un abri méca diminue l'erreur d'abri lui-même, mais il aspire de l'air réellement plus chaud dans la zone bien plus abritée du vent, plus immobile qui a le temps d'être plus surchauffé car le sol et les obstacles, matières abritées sont plus chauds, ils n'évacuent pas autant de chaleur régulièrement comme en zone assez ventée naturellement.) Donc même si tout est normal avec l'hypothèse probable de l'abri ventilé méca NAVCAM, le capteur est à vérifier absolument dans cette partie de la gamme pour un tel record national et c'est vraiment génial de récupérer une valeur RCS et une valeur ventilée méca d'un tel record national dans un tel site en bon état ce jour là ! J'attendrai probablement encore très longtemps de voir ça en France. Au début avant de trouver le ventilé méca, je pensais à un éventuel petit abri (partie d'une mini station tout en un, avec anémo sonique au-dessus d'un mini abri) placé plus haut que la norme, au bout du mât de 2.5m-3 m environ où se situe le pluvio lui aussi très haut (or et blanc), mais même de près malgré la moindre qualité de l'image, je ne pense pas qu'il y ait des coupelles : http://meteo.besse83.free.fr/imfix/lytton2statnov.png . Mais si c'était le cas, là aussi l'écart est tout à fait classique dans ces conditions estivales avec un abri un peu meilleur et une hauteur d'installation à 2.5 m/3m. Comme à Furnace Creek en gardant le Stevenson avec une mesure auto dans l'abri Stevenson en plus des thermo manuels, il existe aussi un petit abri sous le pluvio placé très haut (pas le Davis !) qui renvoie des valeurs régulièrement plus faibles (à l'époque où j'avais analysé le record mondial, j'avais identifié le modèle de l'abri miniature dont j'ai oublié le nom et j'avais regardé ses performances dans les essais pro) : https://mesonet.agron.iastate.edu/sites/pics.php?station=DEVC1&network=CA_DCP La caméra aéro en direct du site Lytton avec d'autres vues (du moins avant la coupure suite aux incendies), le lien précis à trouver sur la carte : https://avcams.faa.gov/ Le problème de tous ces records, c'est que les pays ne mesurent pas encore assez de la même façon, avec strictement le même matériel au moins pour le haut de gamme, incapables de s'entendre pour pondre jusqu'à il y a très peu, enfin pour se décider, de concevoir u réseau mondial à la qualité de l'USCRN ( le GSRN à venir : http://variable-variability.blogspot.com/2019/06/WMO-greatest-global-climate-change-network.html ). Même pas pour déterminer une Tx dans un abri à ventilation naturelle. Par exemple au KNMI, en Hollande, une Tx pour un tel record climatologique est extraite d'après les moyennes/10 mn au lieu de 1 mn chez MF, afin de ne pas trop subir les effets de micro échelle dans les abris, d'harmoniser et de pouvoir corriger les anciens records journaliers, même si c'est toujours encore trop approximativement. Certaines valeurs aux US sont sur 2 s, d'autres sur 1 mn. En Allemagne par rapport à MF, les records de bien des stations auto sont automatiquement plus bas par l'utilisation d'un meilleur abri, le ventilé méca+naturel à chambre ouverte qui a été le meilleur abri des essais OMM (du moins dans ces essais avec malheureusement des moyennes que sur 1 mn, ce qui n'a aucun sens pour les abris à ventilation méca à chambre fermée, bien plus puissante pour la sonde utilisée. Il faut lisser ou installer une sonde plus lente). Mesurer la meilleure Tx dans l'absolu (le plus près de la vraie T de l'air libre sans biais radiatifs et sans effet de micro site) avec le meilleur matériel, c'est bien mieux, mais si on ne peut pas la comparer au passé et à d'autres stations, faute de méthodes communes, on reste sur sa faim de savoir s'il a fait réellement plus chaud ou pas dans des conditions assez comparables. En dessous de 1° d'écart de Tx estivale, on ne peut pas dire qu'il a fait réellement plus chaud dans un site classe 1 et donc il faut bien plus d'écart dans un site classe 3 et encore plus en classe 4 et 5 (je parle que pour les paramètres jouant sur les Tx estivales dans les conditions sèches et chaudes, vu que la classification est faite surtout pour les T en général et que MF ne distingue jamais une classe 4 pour cloisonnement d'une classe 4 pour ombres portées (Un fetch de dégagement sur une distance suffisante avec une végétation courte d'au plus 25cm, est plus important que l'angle de hauteur pour une Tx estivale. On a l'exemple de Montclus où avec les jumelles laser l'angle est relativement faible, mais les Tx estivales sont massacrées par la végétation "courte" trop haute sur une grande surface dans le rayon de 10 et 30 m.)- 184 réponses

-

- 12

-

-

-

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

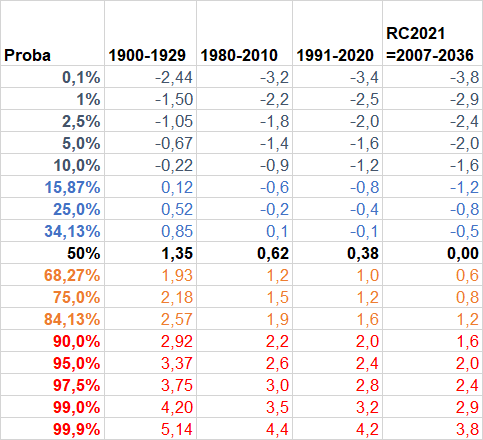

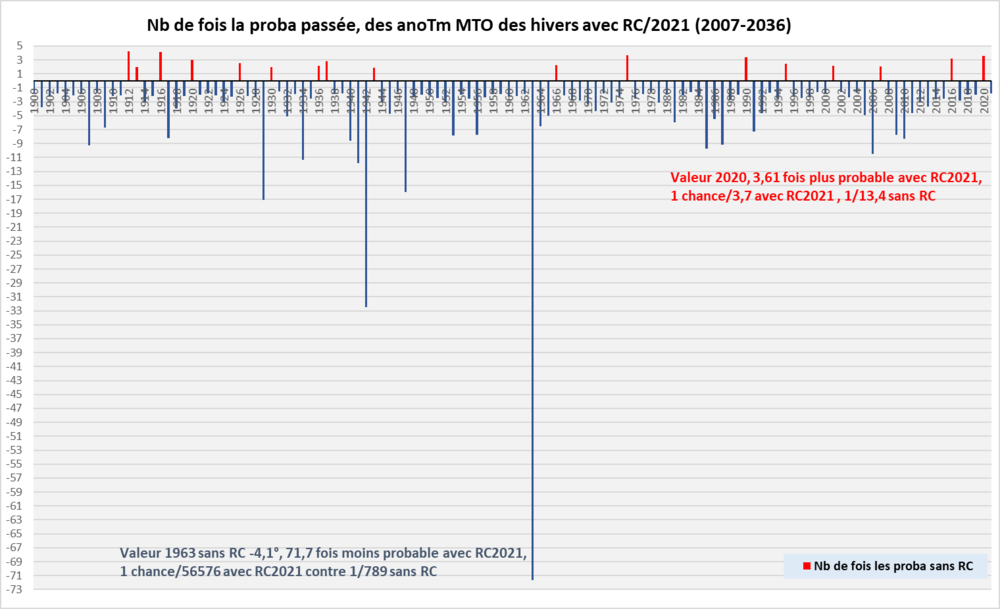

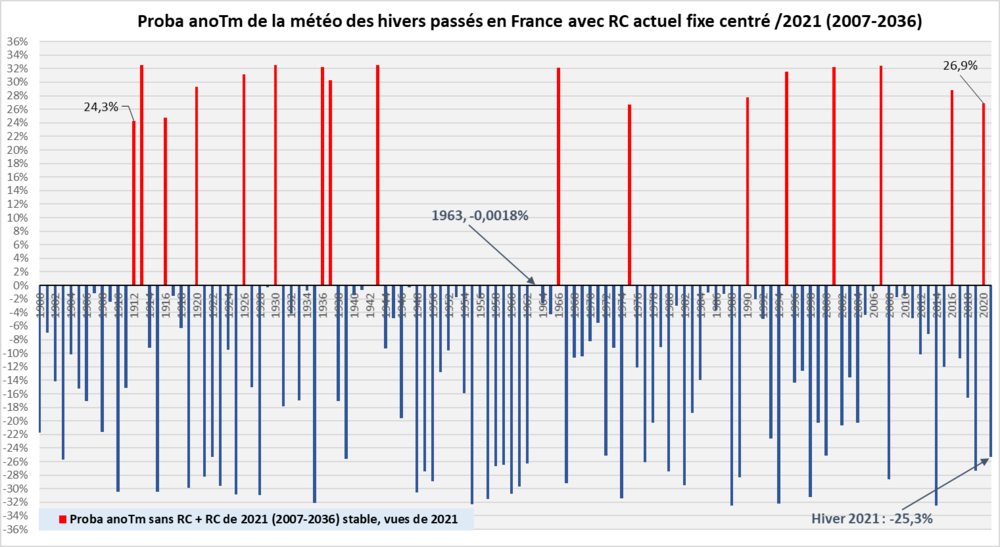

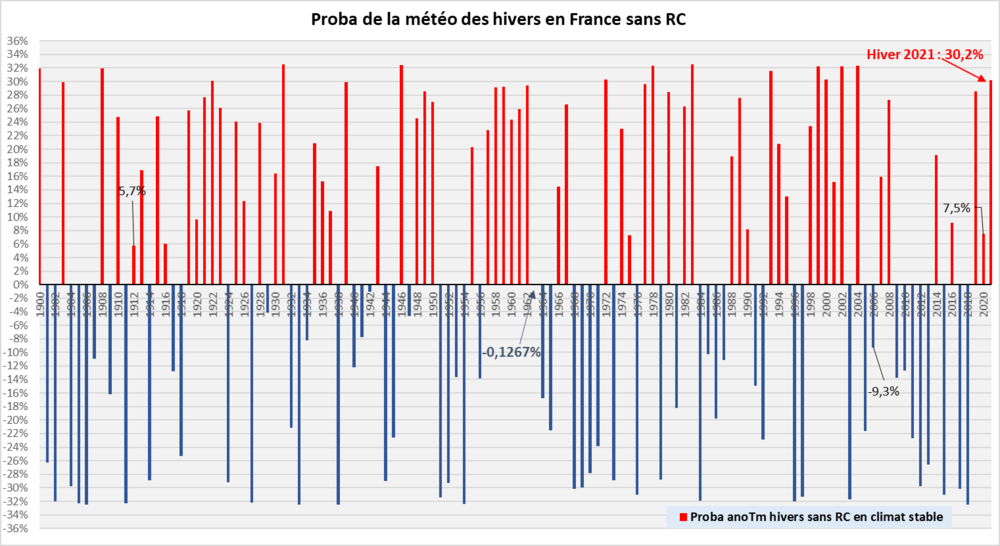

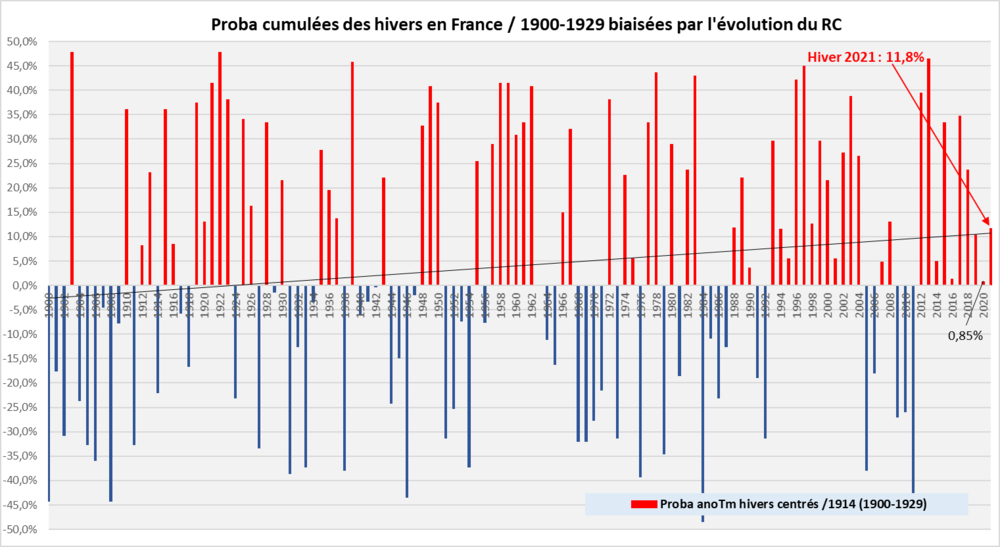

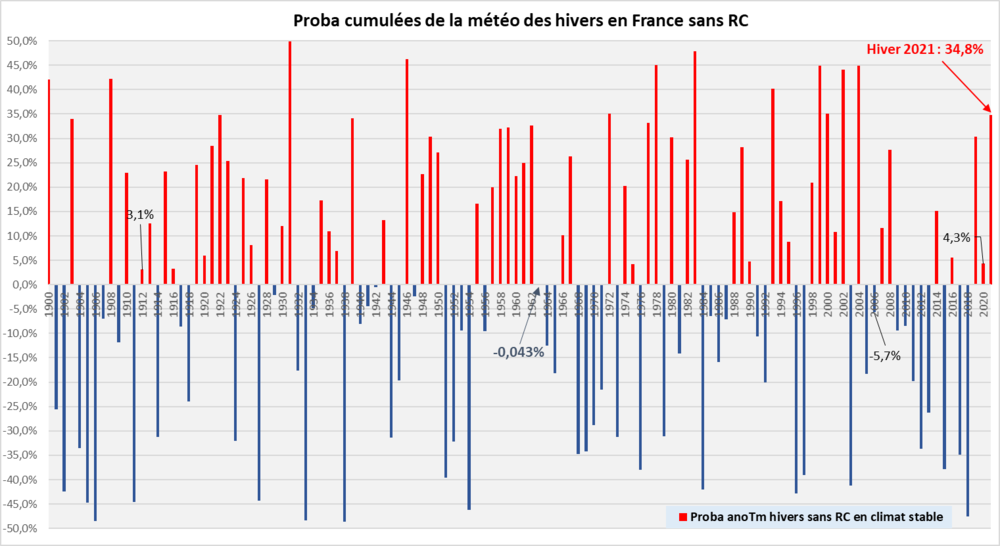

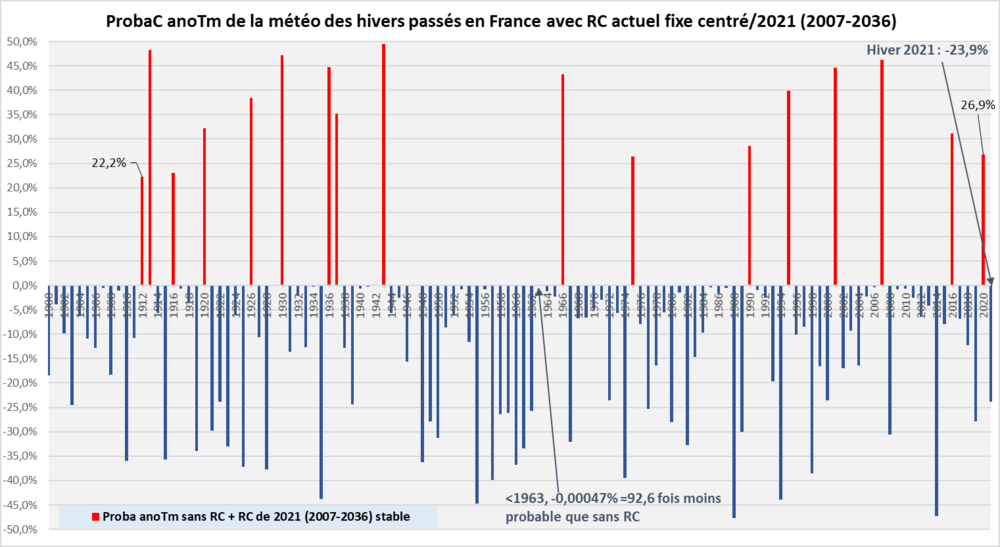

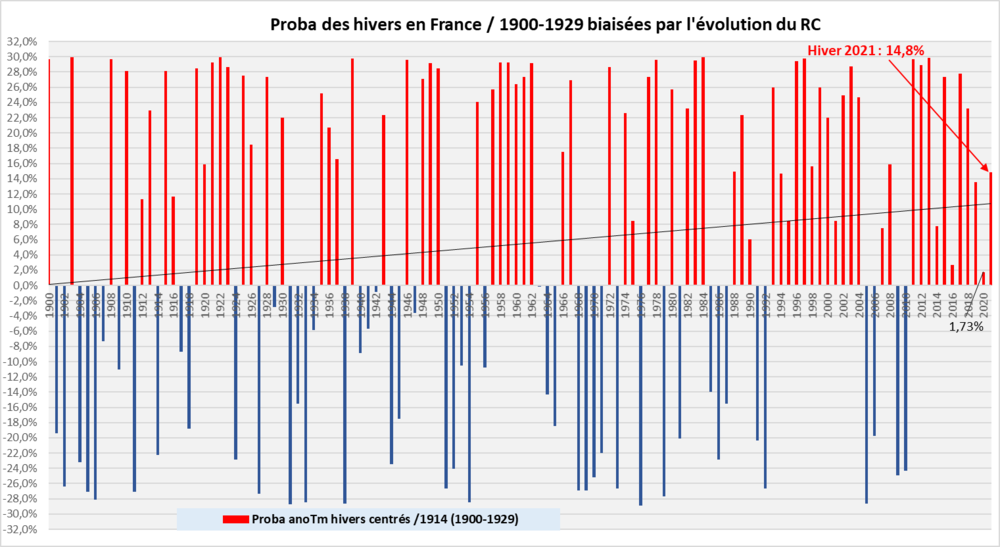

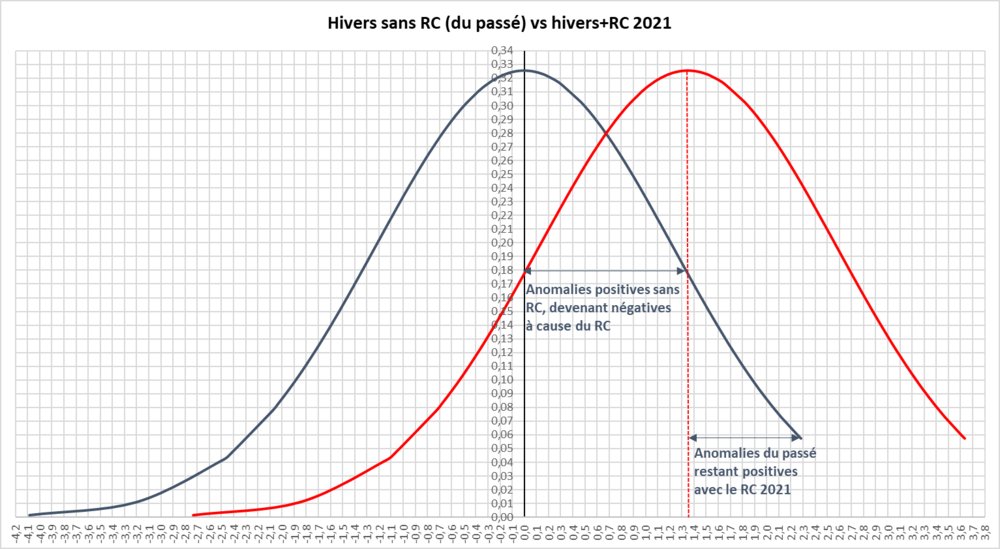

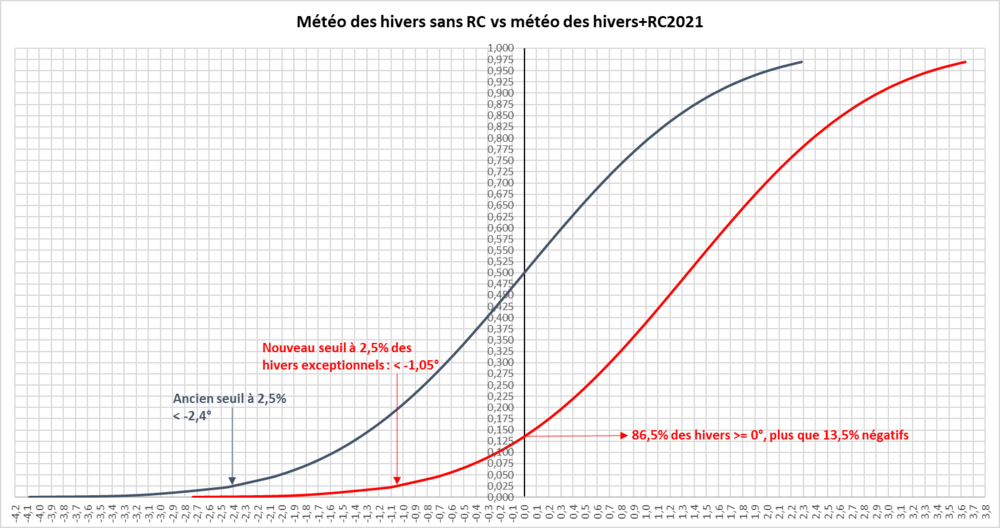

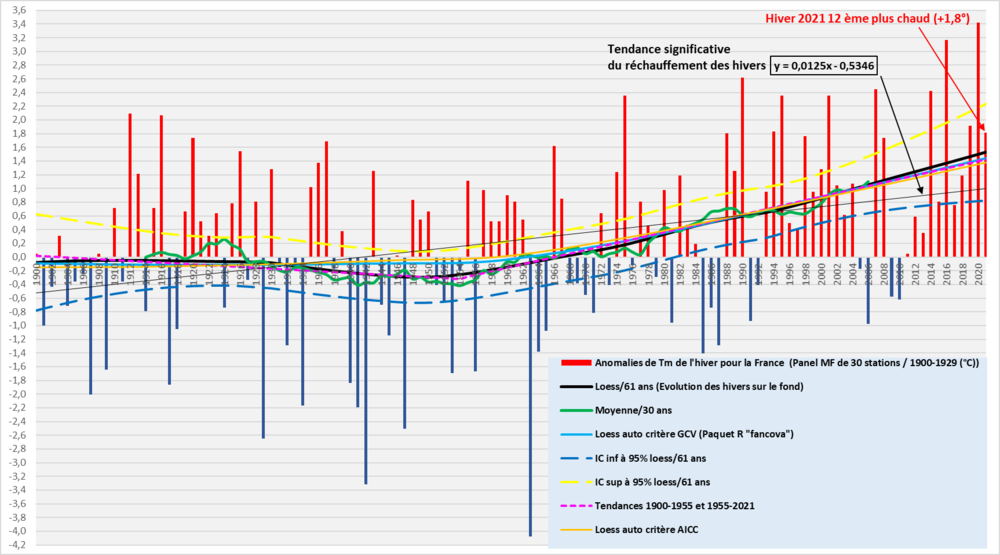

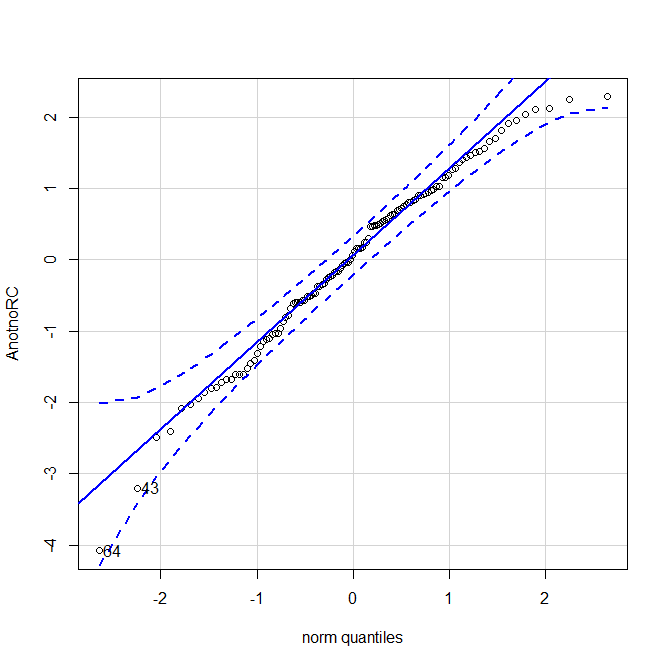

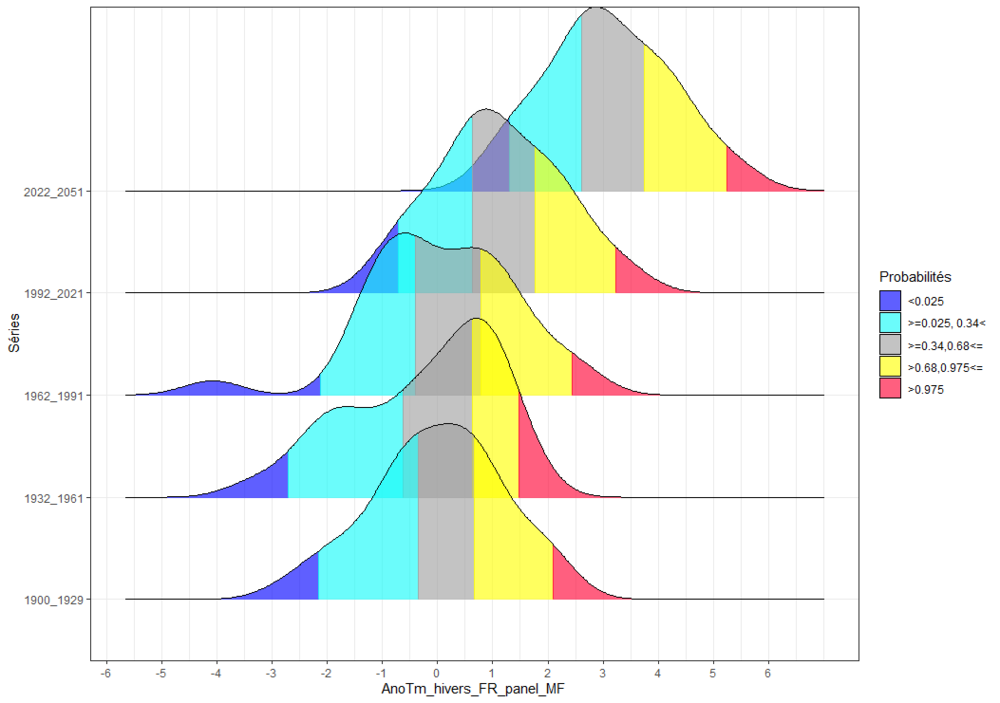

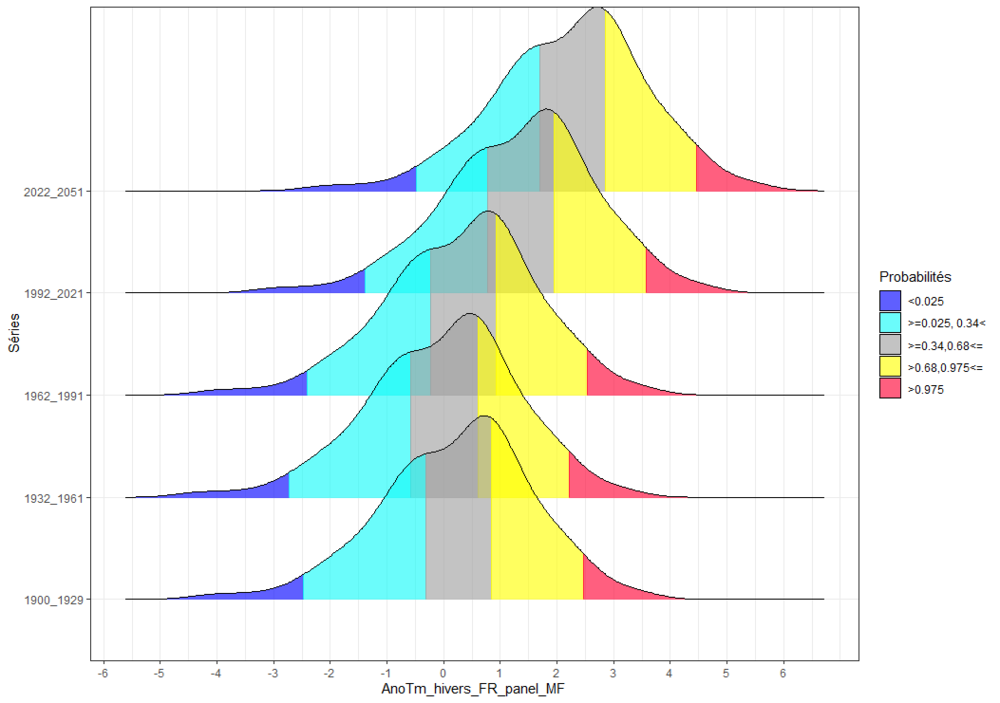

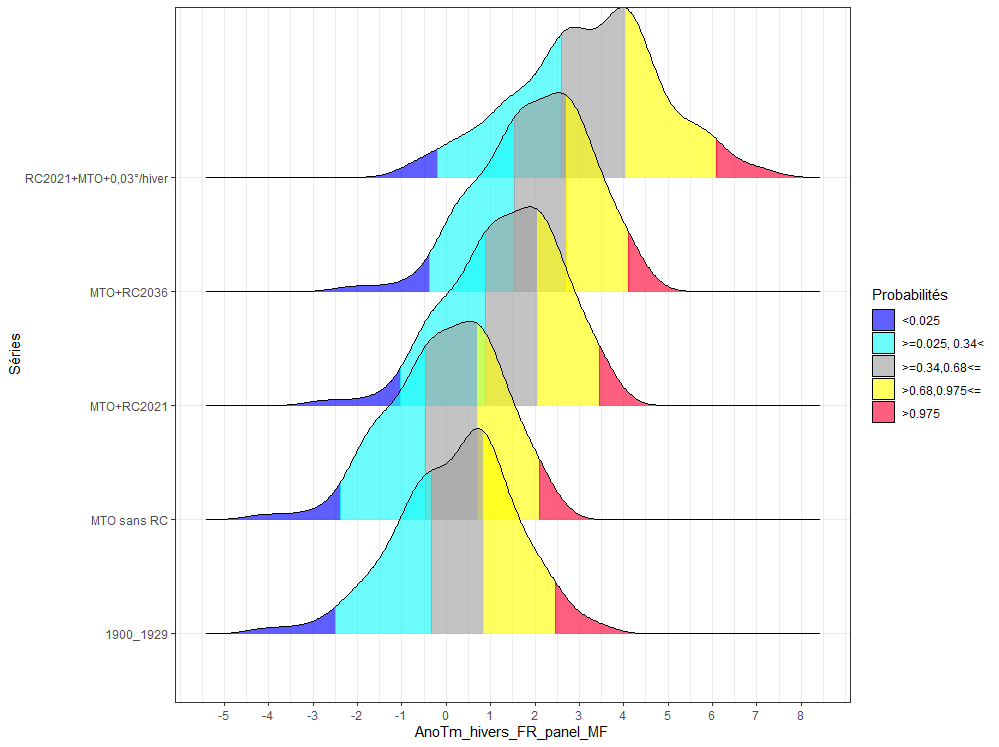

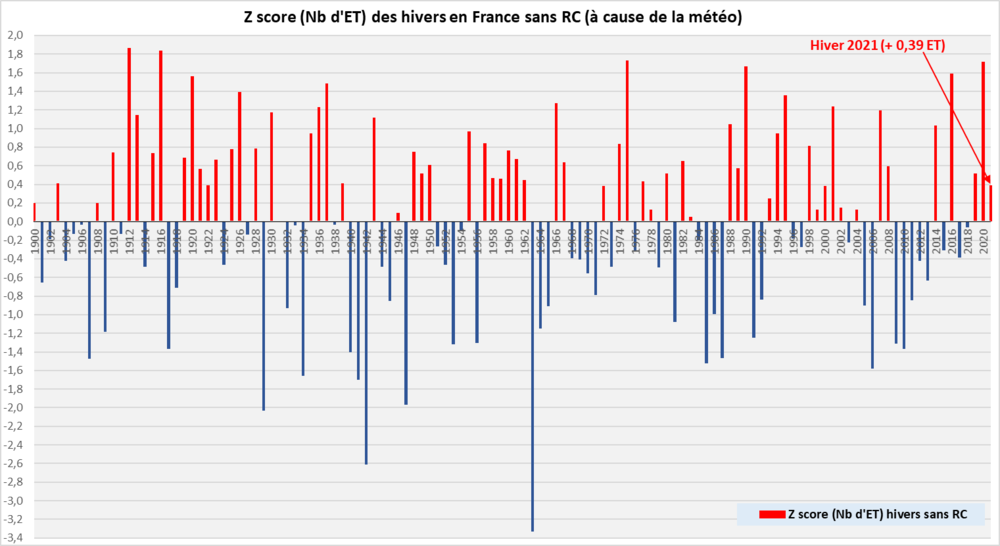

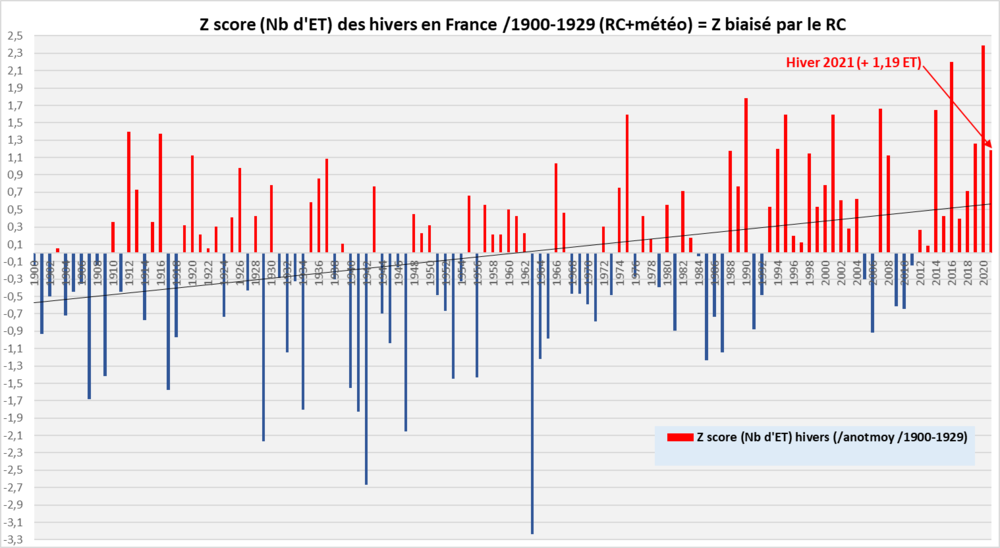

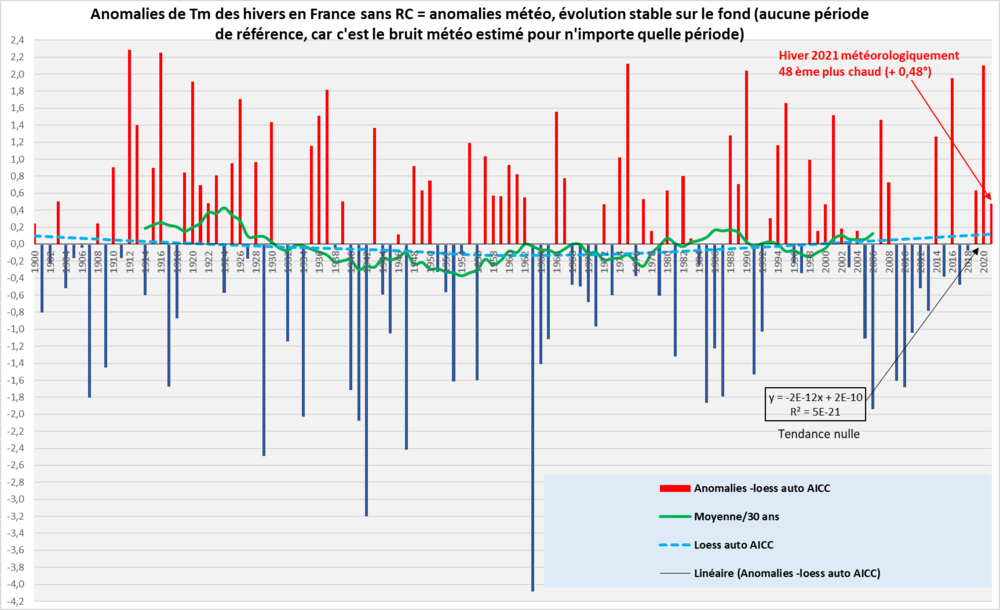

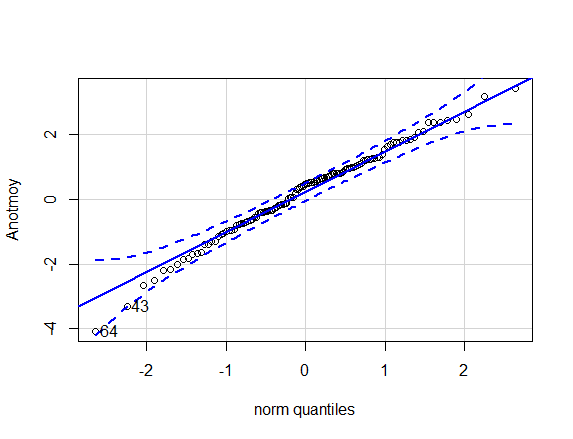

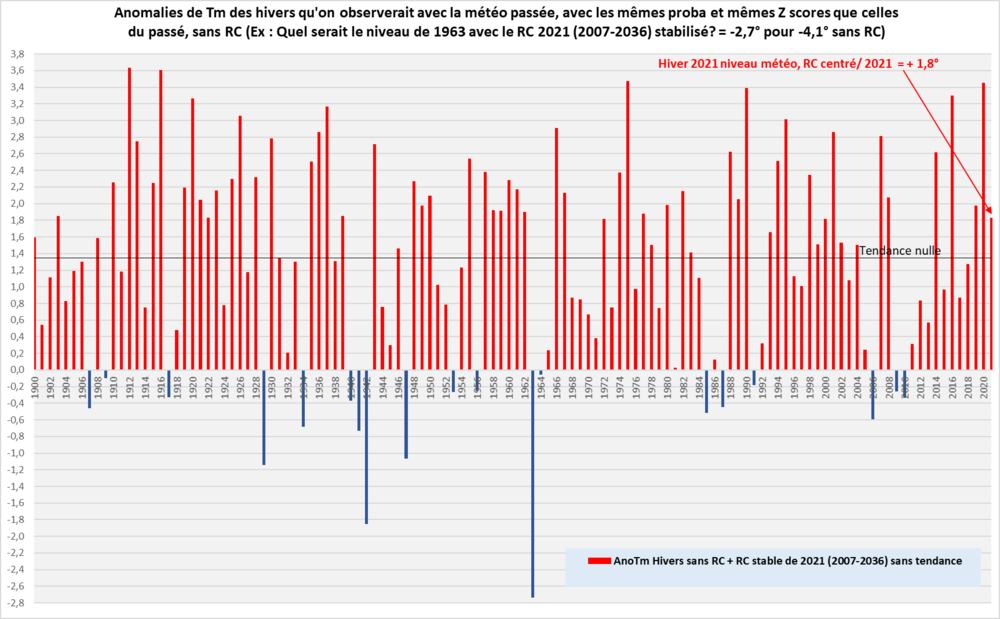

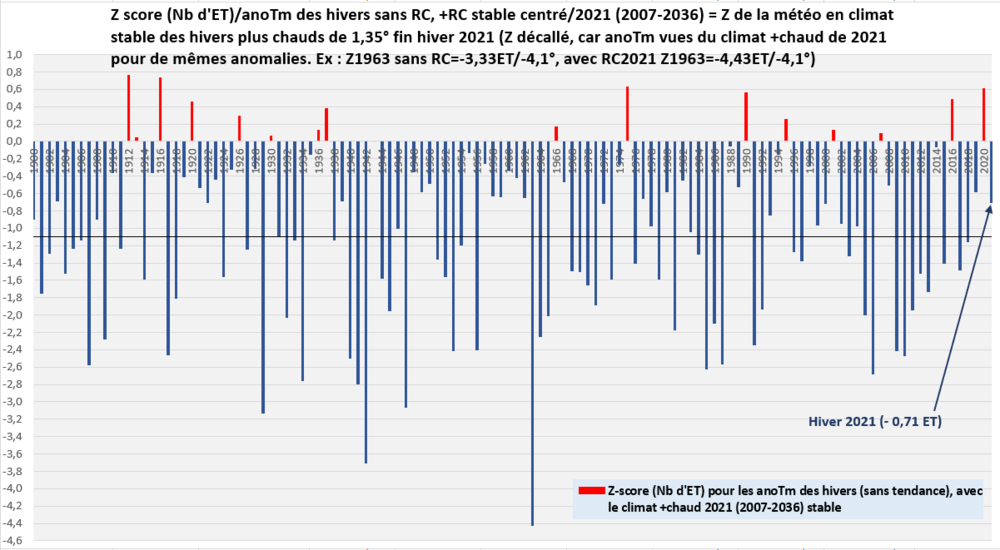

Voici quelques données et infos qui vont probablement traumatiser les amateurs de longs hivers froids en France. Elles montrent à quel point il est devenu de plus en plus improbable/impossible d'observer les anomalies négatives les plus puissantes d'avant 1970 à l'échelle de ces 3 mois d'hiver (C'est différent de celles sur un jour/une semaine ou pour une courte et forte vague de froid, car les possibilités sont plus grandes à cause de la plus forte variabilité sur de plus courtes échelles, plus inconnues (et pas obligatoirement toutes générées par la météo du passé) à cause du manque d'échantillons sur le passé, alors qu'on a une assez bonne idée du niveau de 1963 par rapport aux hivers lointains les plus froids sur des centaines d'années, avec par exemple les livres d'E. Leroy Ladurie) La variabilité des hivers sur la France est bien plus grande que celle au niveau annuel. Il est donc bien plus compliqué qu'au niveau annuel, d'estimer le RC de fond afin de le retirer pour extraire le bruit météo, celui qui fait nos hivers autour du fond qui se réchauffe. On le remarque avec pas mal de signaux de fond possibles dans ce graphe (On pourrait en rajouter bien d'autres, mais bon on va garder à l'esprit la réalité et les possibilités physiques et tenir compte des signaux significatifs visibles et modélisés à d'autres échelles spatiales et/ou temporelles moins bruitées) : http://meteo.besse83.free.fr/imfix/anotmhivers2021frloess61ictrd.png Comme on peut le percevoir graphiquement sans les calculs de significativité que j'ai réalisés, il n'y a aucune différence significative entre tous les signaux de fond estimés. On le voit avec les loess auto qui sont plus lisses que le loess/61 ans, durée maxi utilisable pour obtenir de la qualité, car on ne dispose que de 122 ans. C'est insuffisant de fait, car il est anormal que ce loess maxi, soit plus bruité que les loess auto, sensés trouver une variabilité interne qui ait du sens dans le RC de fond (Ca signifie clairement qu'il faudrait plus de données pour appliquer le bon lissage plus puissant). J'ai regardé en repassant une 2 ème fois un loess/61 ans sur les résidus, mais il enlève trop de météo et avec le RC de fond, ils sont vraiment trop indéterminés par endroits. On cherche à estimer le bruit météo seul et donc quel est le niveau de RC sur le fond pour obtenir une estimation de la distribution de la météo pour un climat stabilisé au niveau de RC de l'instant t de la saison concernée, donc centré sur 2021 ( climat/30 ans de 2007-2036) pour l'hiver passé pour l'hiver terminé, car celui de la future nouvelle référence 1991-2020 (ou au mieux /1992-2021 pour l'hiver), est déjà la référence du climat passé, car ce sont ceux de 2005 (2006). Les données brutes des normales, contaminées par la tendance au RC, ne permettent pas de déterminer assez bien le niveau probable des anomalies sans le RC donné qui a progressé depuis et qui aussi est sous-jacent après 2021 dans la moyenne/30 ans correspondante. L'année prochaine, en fait la nouvelle normale MF/OMM centrée/2005 (1991-2020), sera déjà dépassée de 17 ans (avec la tendance de l'ordre de 0.03°/hiver, le RC supplémentaire est invisible dans les relevés mais pourtant déjà présent, oublié de fait quand on analyse le niveau brut des anomalies face à divers paramètres saisonniers) A noter qu'à cause de la variabilité des hivers sur la France, Il n'y a même pas encore de significativité mathématique du changement visuel de tendance entre le plat jusqu'autour de 1960 et la plus forte pente depuis, mais comme on sait que physiquement c'est bien le cas, on va s'en affranchir même si mathématiquement, on ne pourra même pas choisir 1963 comme point de rupture, où la significativité est la plus proche, car il n'est pas physique. Il y a un saut de tendance qui n'existera jamais dans la vraie T. Aucune continuité dans le signal, à l'inverse du monde physique, comme par exemple entre les pentes 1900-1955 et 1955-2021 reliées naturellement sans marche brutale (il n'y pas non plus de différence significative de tendance). Pour choisir l'estimation probablement la plus proche de la valeur du climat centré/2021, j'ai regardé de près les pentes les plus significatives du RC et celles depuis le début plus fort autour des années 60. La tendance au RC est de l'ordre de 0.3°/déc depuis vers le milieu des années 50 et surtout dans les années 60 (ça varie de 0.36°/déc +- 0.185° sur 1963-2021, à 0.252°/déc +-0.184° sur 1966-2021). La pente du loess/61 ans est de 0.278°/déc, il est sensé estimer la moyenne/30 ans centrée/2021, inconnue sans relevés de 2022 à 2036. Comme on l'a vu, c'est trop bruité, son bout qui est sensé estimé le centre de la moyenne/30 ans est donc peu fiable. Comme il me faut une référence de climat stabilisé pour déterminer le bruit météo qui existera toujours autour d'un fond, je dois retirer le signal du RC des anomalies jusqu'en 2021, mais aussi déduire ce que serait la moyenne des anomalies inconnues de 2022-2035 avec et sans RC. On doit aussi laver du RC, les anomalies futures présentes dans la valeur centrée/2021, pour obtenir une estimation plus cohérente du niveau zéro pour estimer le bruit météo. J'ai estimé que c'est le loess auto critère AICC qui est probablement le plus proche des possibilités potentielles avec la tendance de fond de nos jours et l'évolution de la moyenne/30 ans et surtout avec les tendances effectives (donc hors celles du modèle linéaire et son incertitude supplémentaire) qui est de 0.13°/déc +-0.06°. Le bout indique 1.35°, alors que la dernière moyenne/30 ans de centre 2006 est à 1.10°. De plus avec le loess on estime une référence/30 ans plus propre et plus représentative d'un climat sur le fond, car la vraie moy/30 ans des hivers, est trop bruitée sur la France. On le remarque facilement, avec bien trop d'agitations de la courbe/30 ans en peu de temps. C'est obligatoirement de la météo, pas le climat qui lui ne prend pas 0.3° en 5 ans pour en perdre à la suite près de 0.4° en 4 ans (autour de 1924 sans un forçage supérieur pour le fond, pas aussi puissant que de nos jours). Elle est de moins en moins agitée avec le RC (et probablement avec la meilleure précision des mesures/estimation de la T sur la France) qui noie de plus en plus la fraction de météo encore visible/30 ans malgré le signal de fond plus puissant au fil des ans. La météo (le bruit/la variabilité météo) estimée sans le RC estimé sur le fond par retrait du loess AIC et recalage au centre de la tendance résiduelle, nulle (enfin bon elle modifie les anomalies que de 0.043°) : http://meteo.besse83.free.fr/imfix/anonorchivers2021frretraitsloessaicc.png En réalité les IC à 95% des valeurs varient d'environ +-0.5° au centre à +-0.8° aux bouts, donc ce sera sous-entendu par la suite que je raisonne en valeur centrale (en 2036 on pourra vérifier la réalité, où se situe le point 2021 de la pente du loess et la moyenne plus bruitée/30 ans centrée/2021, connue qu'en 2036.) A noter que j'avais fait une erreur au plan annuel dans ce même type de graphe, en laissant indiqué dans le titre, la période de référence (1900-1929), alors qu'il n'y en a plus, c'est le bruit qui est "isolé" du fond retiré (jamais totalement, c'est impossible à quantifier exactement), car c'est le type d'écart qu'on est sensé observer n'importe quand autour d'un signal de fond. Il suffit ensuite de réintégrer le RC en bloc et non en tendance pour obtenir l'estimation de la météo à un niveau de RC supérieur. Donc sans tendance sur le fond, il n'y a aucune différence de normale, c'est toujours la même, ces anomalies représentent seulement le niveau de bruit météo (on a strictement les mêmes résultats en calculant ces anomalies "sans RC", les loess et autres à partir des anomalies 1981-2010 ou autres, dans la période de 122 ans). On doit en passer par là pour raisonner comme si on disposait d'un climat stabilisé au niveau de l'instant t, sinon les estimations statistiques classiques sont biaisées par les tendances, et donc les proba aussi et les valeurs auxquelles on peut rêver, ou redouter, sont illusoires. C'est normal qu'il reste du bruit dans le loess résiduel. C'est probablement surtout de la météo avec du signal résiduel climatique impossible à déterminer (il est probable que le RC retiré soit sous-estimé avant 1965 car la pente du loess auto légèrement positive, semble trop faiblement positive, par rapport aux modèles physiques), faute de recul suffisant pour mieux cerner la variabilité et le fond. Le qqplot des anomalies traditionnelles où on voit les anomalies détectées hors normes de 1942 et 63, et les anomalies chaudes qui paraissent plus alignées avec la le biais à cause du RC: http://meteo.besse83.free.fr/imfix/qqploticanothivers2021fr.png Celui avec celles sans RC, de la météo: http://meteo.besse83.free.fr/imfix/qqplotmtonorchivfr2021.png La dernière série sans RC est bien plus considérée comme normale/gaussienne car il n'y a plus de tendance significative. J'ai aussi regardé les résidus, il n'y a pas d'autocorrélation significative, donc on peut appliquer les estimations stats classiques sans biais mathématiques. Maintenant qu'on dispose de notre bruit météo sans RC de fond, on peut comparer les distributions en injectant certains niveaux de RC fixe/stable, donc sans tendance afin de raisonner sur les anomalies valides pour un instant t ( comme si le climat se maintenait des centaines d'années au niveau donné). Donc la dernière courbe la plus chaude avec tendance, concerne la période 2022_2141. Je reprends le bruit météo passé des 122 ans de données dans chaque cas, donc pas de simulation aléatoire. http://meteo.besse83.free.fr/imfix/denshiversFR2021retraitloessaicc.png A partir du bas, 1900_1929 : Anomalies traditionnelles du panel MF/1900-1929 MTO sans RC : C'est la distribution estimée de la météo sans RC, correspondant au graphe plus haut de la météo sans RC, avec le loess AICC retiré. C'est avec elles que les prévis saisonniers sont sensés rechercher les corrélations avec leurs paramètres préférés pour éviter les biais à cause de la tendance au RC. MTO+RC2021 : C'est celle qui nous concerne à l'instant t pour l'hiver. C'est la courbe précédente à laquelle on rajoute en bloc le réchauffement centré/2021 (sans injecter de tendance, l'hiver s'est réchauffé de 1.35° valeur centrée/2021). Ce bruit n'est pas différent, c'est le niveau de bruit installé à un niveau supérieur par le climat de fond réchauffé. C'est elle la "vraie/la moins pire" normale météo (estimée) de référence pour les hivers. On remarquera que de nombreuses valeurs froides avec RC2021 se retrouvent maintenant dans le chaud de la courbe sans RC. Il faut bien voir qu'à l'instant t, avec le RC2021, si on se base sur la courbe de densité de proba cumulées des anomalies observées, http://meteo.besse83.free.fr/imfix/densit%e9cumhivfr2021.png avec le RC on est sensé récolter 86.5% des hivers avec une anomalie météo >= 0 (le 0 de la courbe précédente du passé sans RC ajouté en bloc); on ne peut espérer revoir que 13.5% des hivers négatifs du passé, et donc pas les plus froids, quasi impossibles sans volcans ou autre catastrophe. Un hiver < -1.05° d'anomalie du passé, sera considéré maintenant comme exceptionnel (on est sensé observer moins de 2.5% d'hivers sous ce seuil sans tendance, mais ça se dégradera au fil des hivers dans la réalité, car la tendance continue à agir) contre -2.4° sans RC pour ce même seuil. MTO+RC2036, la même chose avec un RC à un niveau stabilisé (moy/30 ans plus chaude de +0.65°, de plus que le climat stable centré/ 2021) centré/2036 (2022-2051), déduit de la tendance de fond actuelle. RC+MTO+0.03°/hiver, c'est cette forme, qu'on est sensé observer plus ou moins au final dans la réalité, comme avec pour la première courbe 1900-1929 des anomalies réelles avec une tendance. Le mélange d'une tendance de fond au RC avec la MTO de la 2ème courbe (MTO sans RC), on ajoute son réchauffement en bloc déjà acquis en 2021 avant de continuer à injecter la tendance 0.03°/ hiver/122 ans. Logique que la distribution soit plus étalée encore que la première, car il n'y a pas de plateau comme de 1900 à 1963 environ. A cause de la tendance, il faut s'attendre à observer les plus froides/très bleues ces prochaines années (alors qu'elles ne vous paraitrons pourtant pas très froides par rapport au passé plus lointain), plutôt que plus tard. Chaque hiver qui passe nous éloigne de 0.03° des possibilités d'observer le plus bleu de la courbe de cette distribution la plus chaude. Dans environ 100 ans sans aucune accélération du RC, une anomalie de 0 du passé, sera considérée comme l'hiver exceptionnel de 1963, un exploit équivalent, mais bon vu qu'une accélération est bien possible... Je reviens sur le bruit trop important dans une période de 30 ans, on peut le voir dans ces courbes de données brutes de distributions de 30 ans de données indépendantes et qu'il est de plus en plus masqué/écrasé au fil du RC relativement récent en hiver, mais la météo existe pourtant, sauf qu'on ne peut pas assez bien la visualiser depuis que la tendance est montée en puissance. http://meteo.besse83.free.fr/imfix/densit%e9hiverfrnormales30ans.png La période 2022-2051 est la distribution des 30 ans au début de la série de 122 ans virtuels (contenant strictement la même météo que celle du passé) de la courbe (RC+MTO+0.03°/hiver) la plus chaude du graphe précédent des distributions/122 ans. En utilisant les références à différents niveaux indépendants pour les 122 ans passés, elles ont logiquement la même forme, car elles contiennent toutes strictement le même bruit météo et le même signal de fond. La différence, c'est le niveau de réchauffement selon l'évolution des normales : http://meteo.besse83.free.fr/imfix/densit%e9hiversnormales.png On peut voir les seuils de proba cumulées par hiver : Celles biaisées par le RC: http://meteo.besse83.free.fr/imfix/probachiv2021frbiais.png (Attention en cumulé, ça ne se lit pas comme la proba de l'anomalie d'un hiver donné, ça indique quelle proba a un hiver de se retrouver au dessus (chaud) ou en dessous (froid) de la valeur du seuil de fait indiqué par l'hiver concerné. Exemple hiver 2021 : 11.8%, c'est la proba (biaisée dans ce cas) qu'a un hiver de se retrouver plus chaud que l'hiver 2021. Dans le froid c'est l'inverse, ce sera la proba qu'a un hiver de se retrouver plus froid que le niveau donné par l'hiver concerné.) Celles des anomalies sans RC: http://meteo.besse83.free.fr/imfix/probachiv2021frnorc.png Logique que le seuil pour 2020 soit plus restreint (seulement moins de 4.3% des hivers sont sensés être météorologiquement plus chauds sans RC, le seuil indiqué par l'hiver 2021 est très banal météorologiquement) Maintenant ça va faire très mal avec le RC, en se plaçant au niveau du RC2021, quand on regarde la météo du passé : http://meteo.besse83.free.fr/imfix/probacanohivpass%e9s2021rc2021.png 2020 ne donne plus un seuil d'hivers plus chauds peu fréquents (avec le RC, seuil des 26.9% des hivers plus chauds que 2020 contre 4.3% sans RC), et 2021 se retrouve dans le froid, assez courant, on peut observer un seuil de 23.9% d'hivers plus froids. Ca correspond logiquement au regard qu'on porte en se situant à partir du niveau de la courbe de densité de proba cette fois non cumulées, rouge, avec le RC2021 (c'est le niveau actuel de la météo des hivers, plus élevé avec le RC centré/2021) : http://meteo.besse83.free.fr/imfix/probanchinorcVShivrc2021.png La courbe rouge correspond à ces anomalies météo réchauffées du graphe suivant, vues du passé/sans RC (celles de la courbe bleue, on retrouve les 86.5% d'anomalies positives et le peu d'anomalies négatives) http://meteo.besse83.free.fr/imfix/anotmhivfrnorcrc2021.png Voici cette fois les proba non cumulées, donc on a la proba pour l'anomalie donnée (et non plus les proba d'observer des hivers inférieurs ou supérieurs à un seuil). Celles brutes biaisées par la tendance du RC dans ces données originales: http://meteo.besse83.free.fr/imfix/Probanchivfrbiais2021.png (Au final, on va constater le biais considérable sur la pseudo rareté potentielle de la météo de 2020 et la pseudo douceur de la météo de l'hiver 2021) Proba des anomalies météo sans RC : http://meteo.besse83.free.fr/imfix/ProbanchivfrnoRC2021.png 2020 est déjà moins rare (4.4 fois plus probable) et 2021 se retrouve proche de basculer côté froid, ceci dans RC, ça promet. La météo avec le RC2021 : http://meteo.besse83.free.fr/imfix/Probancanohivfrrc2021.png Ca change tout par rapport aux données brutes, avec le niveau de RC2021 injecté. 2020 devient relativement banal, très loin des 1.7%, et l'hiver 2021 a basculé dans le froid, mais banal, on le vérifiera plus loin avec les Z scores (le nombre d'écart-type). Donc ne vous étonnez plus de voir vos anomalies brutes trop décalées de l'AO donné et autres paramètres, car les anomalies brutes correspondent trop peu au climat de l'instant t et ces anomalies contaminées biaisent les corrélations. On peut en déduire combien de fois les valeurs les plus froides sont devenues moins fréquentes/plus improbables (pour des valeurs comme 1963, 42 et autres extrêmes, une analyse sera tentée plus tard sur les queues de ces distributions qui répondent à des lois différentes, mais bon là avec une moyenne sur 3 mois, ce n'est peut-être pas aussi décalé de la loi normale, que pour une valeur journalière, donc ça donne quand même un certain ordre de grandeur.) http://meteo.besse83.free.fr/imfix/Nbfoisprobancmtohivfrpass%e9rc2021.png Les Z scores (les nombres d'écart-type). Biaisés en données brutes : http://meteo.besse83.free.fr/imfix/zscorehivers2021fr1900_1929.png Ceux de la météo sans RC : http://meteo.besse83.free.fr/imfix/zscorehivers2021frsansrc.png Avec le RC, le passé prend un coup de froid dont certains sont très improbables de nos jours http://meteo.besse83.free.fr/imfix/zscorehiversrc2021franosansrc.png Notre hiver 2021 se retrouve à -0.71ET alors qu'en données brutes, il atteignait 1.19ET ( il était déjà tombé à 0.39ET météorologiquement sans RC). Pour résumer et rendre utilisables les données pour la réalité avec tendance selon la référence en cours, en tenant compte de tout ce qui est exposé plus haut, voici un tableau pour classer les hivers : http://meteo.besse83.free.fr/imfix/tabprobaanoavecrc2021.png A noter pour les anomalies de l'hiver 2022, certaines valeurs auront déjà un peu changé avec les arrondis à cause de la tendance de 0.03° qui se poursuit chaque hiver et donc la référence/les anomalies auxquelles s'attendre tendront au fil des ans, à atteindre la distribution du RC centré/2021 de la dernière colonne si la tendance ne change pas. Ce type d'analyse ne peut-être réalisée au pas mensuel sur la France, car là sur 3 mois, c'est déjà mathématiquement trop limite à cause de la trop forte variabilité à cette échelle pour le nombre d'échantillons donné. -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

Oui mais je n'ai jamais vu ce panel à la vente en ligne. Sinon en attendant, selon le temps dispo, je vais sortir les données des hivers du panel à partir du graphe sur cette page, complété par les données des derniers bulletins MF: https://meteofrance.com/comprendre-la-meteo/saisons/hiver -

Vantage Pro2 + anémomètre sonique et WeatherLink Live

ChristianP a répondu à un sujet de Vals dans Instrumentation

Je le teste depuis fin juin 2020. Il est bon quand il est propre, donc utilisable à 2 m si les capteurs sont visités et nettoyés très souvent. Il est inexploitable à 16 m ici en forêt avec des saletés et surtout des araignées/toiles/cocons/oeufs, qui biaisent les mesures (sous-estimation au fil du temps sans nettoyage). Un seul bug au début sous de la pluie très forte avec du vent, pas revu depuis. -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

Salut, Je n'ai pas les données homogénéisées du panel MF depuis 1900. C'est utile pas uniquement pour 2021, mais surtout pour la prévis saisonnière, afin d'étudier les paramètres les plus pertinents pour la météo saisonnière, sans déductions et calculs de fait biaisés par le fond qui masque trop le signal de la météo saisonnière (un prévis saisonnier "à la maison" est sensé d'abord déterminer et quantifier l'influence des paramètres sur le bruit/la météo d'abord seule, avant de réintégrer le fond et de sortir son anomalie finale, météo+fond.). Il me faudrait donc les données du panel MF homogénéisé au pas mensuel depuis 1900. -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

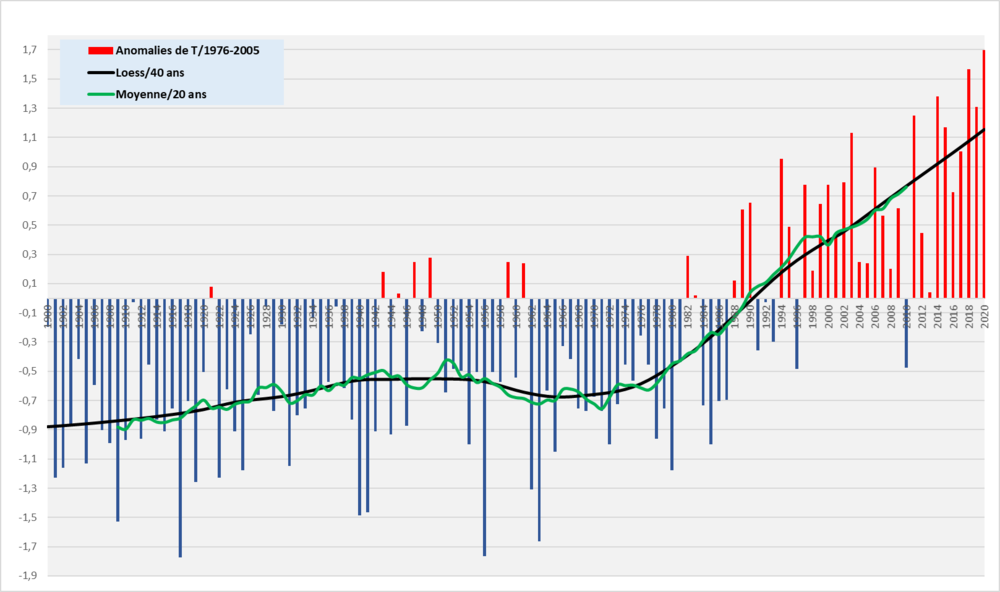

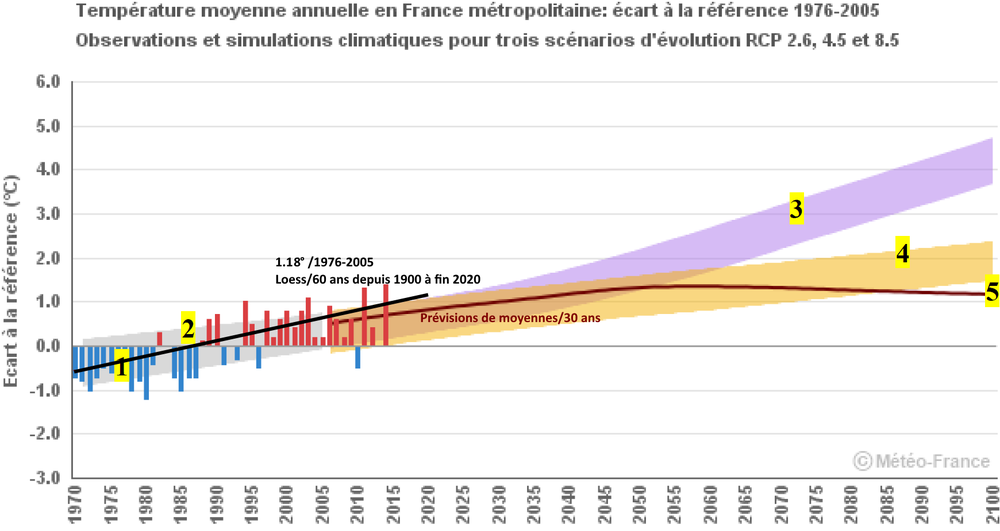

Comparaison des observations sur un graphe des dernières prévisions/projections pour la France http://meteo.besse83.free.fr/imfix/drias3anoanloes402020.png du rapport 2020 : http://www.drias-climat.fr/document/rapport-DRIAS-2020-red3-2.pdf Le loess/40 ans pour la moyenne/20 ans des obs ... (Plus bruitée que celles des modèles. Ce n'est quand même pas très clair que malgré qu'ils sortent les prévis sur des moyennes/30 ans pour éviter les problèmes d'incertitude avec la variabilité interne ( avec les boxplot des valeurs prévues pour des périodes/30 ans dont celle 2071-2100 fournie pourtant au bout de ce même graphe, voir page 29 dans le pdf), sans produire les courbes/30 ans associées, qui sont pourtant celles à comparer, et non celles/20 ans vu que les obs/20 ans sont logiquement trop bruitées à l'échelle de la France. C'est d'ailleurs la raison pour laquelle ils sortent des moy/30 ans, hors des courbes/20 ans de ces graphes qui ne correspondent à aucune valeur chiffrée et des boxplot données dans leur rapport. En 2015 ils avaient pourtant réalisés les graphes avec les moyennes/30 ans. J'en ai vu un récent diffusé pour le public avec 2 courbes et 2 valeurs/30 ans, mais inexploitable car pas cohérent au niveau des pixels pour les valeurs/30 ans données) ...est celui de ce graphe : http://meteo.besse83.free.fr/imfix/obsfrance2020moy20loess40.png -

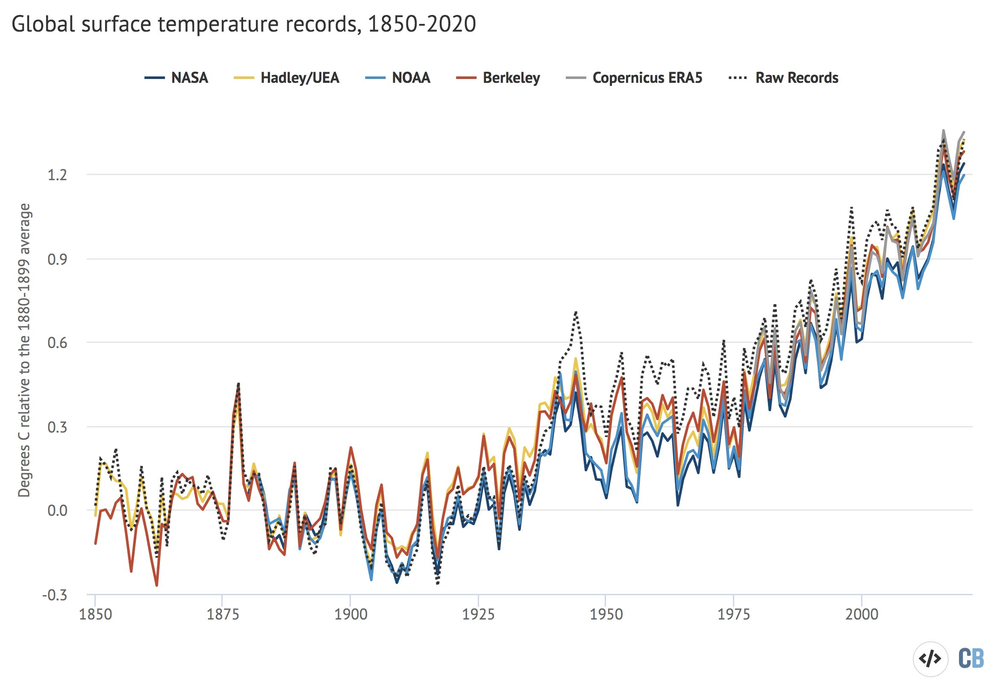

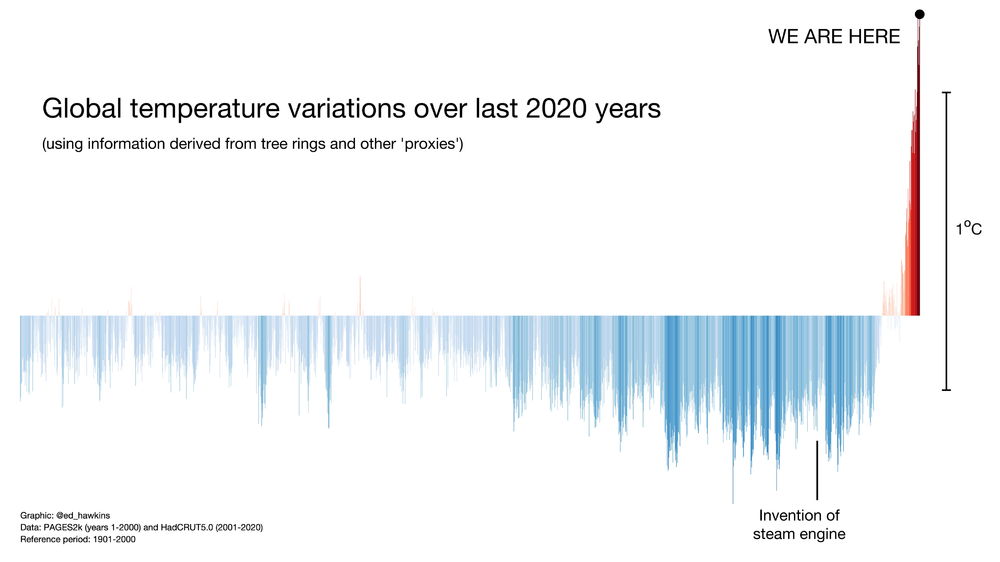

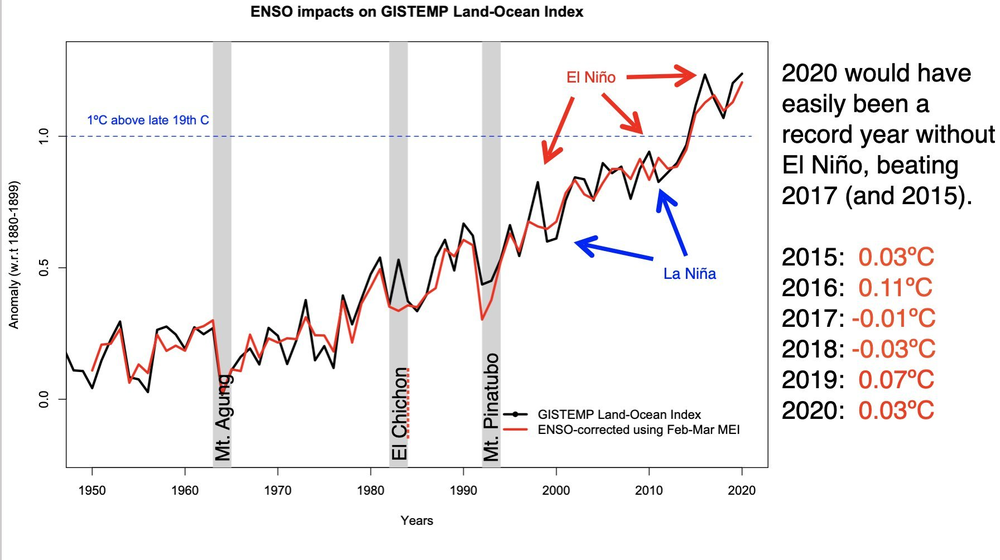

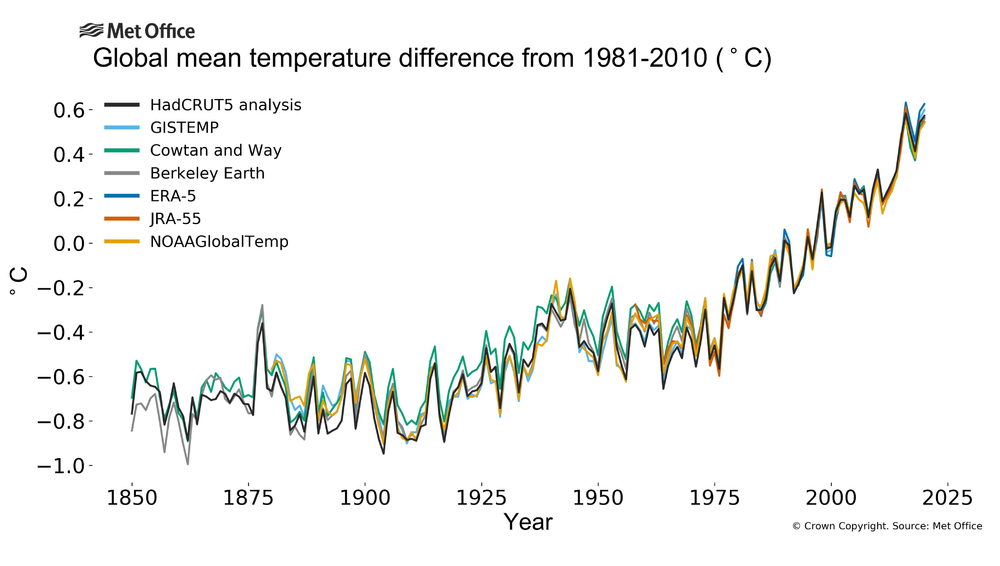

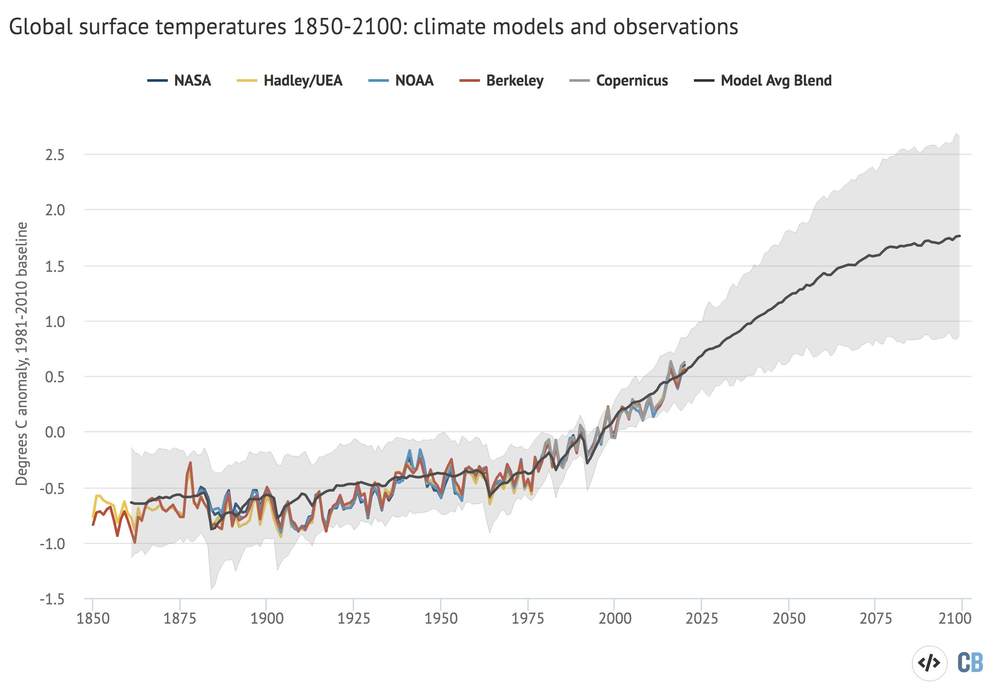

Statistiques et anomalies climatiques globales

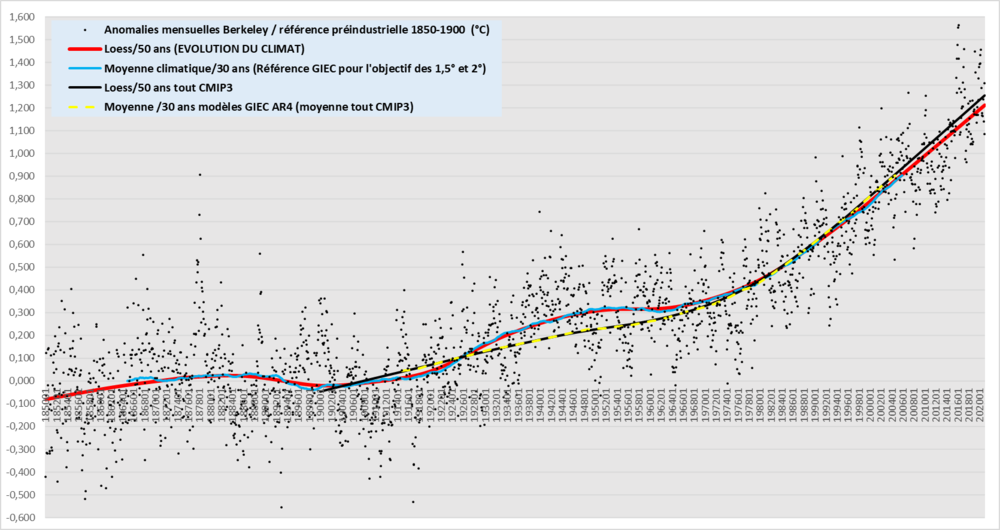

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

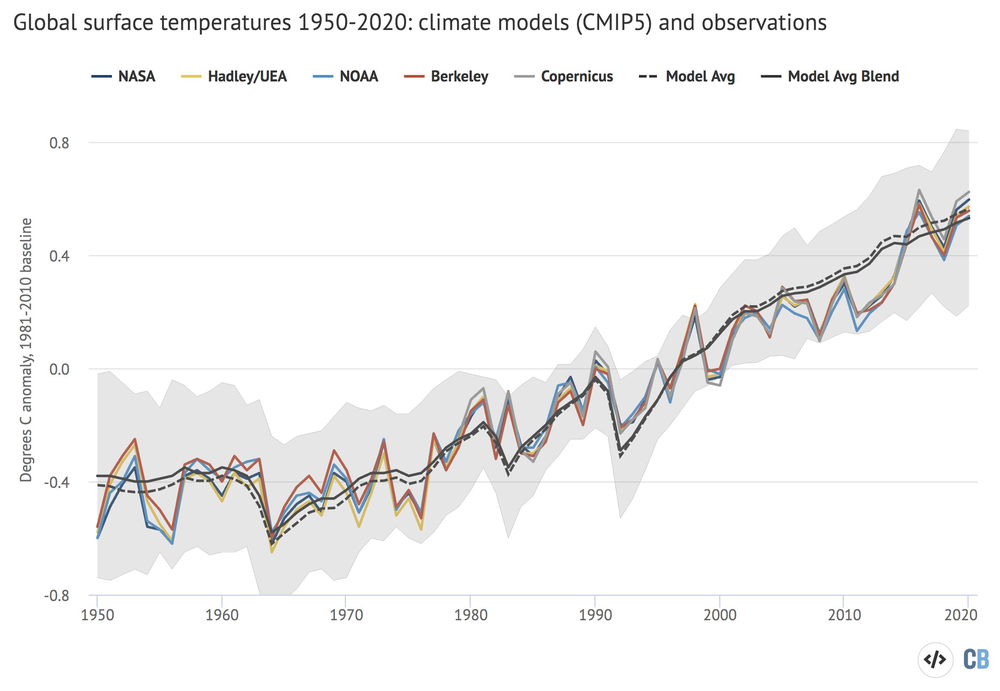

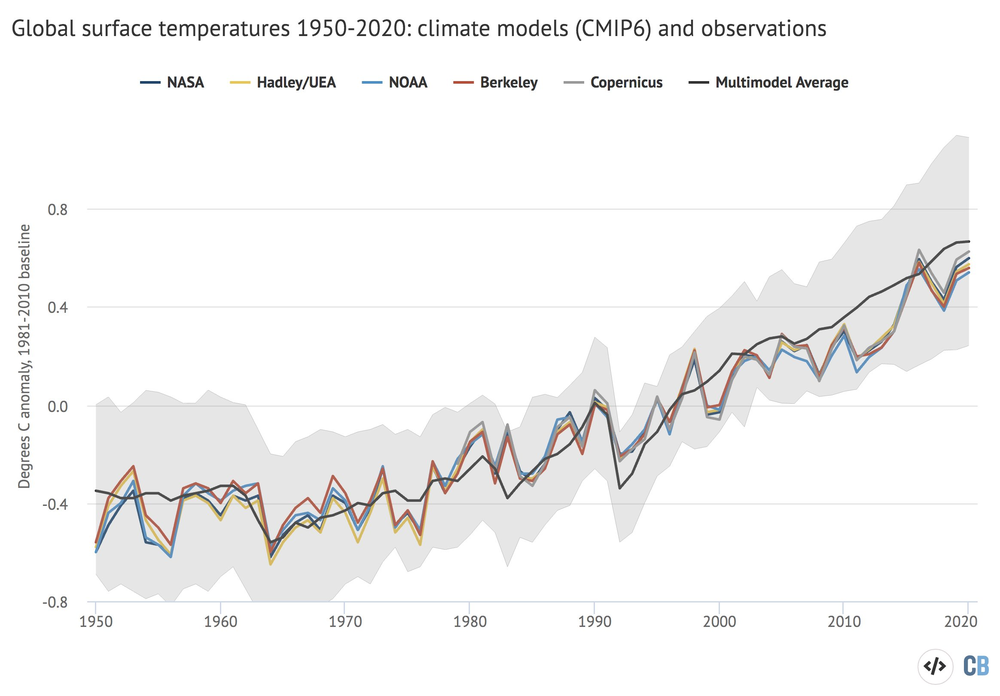

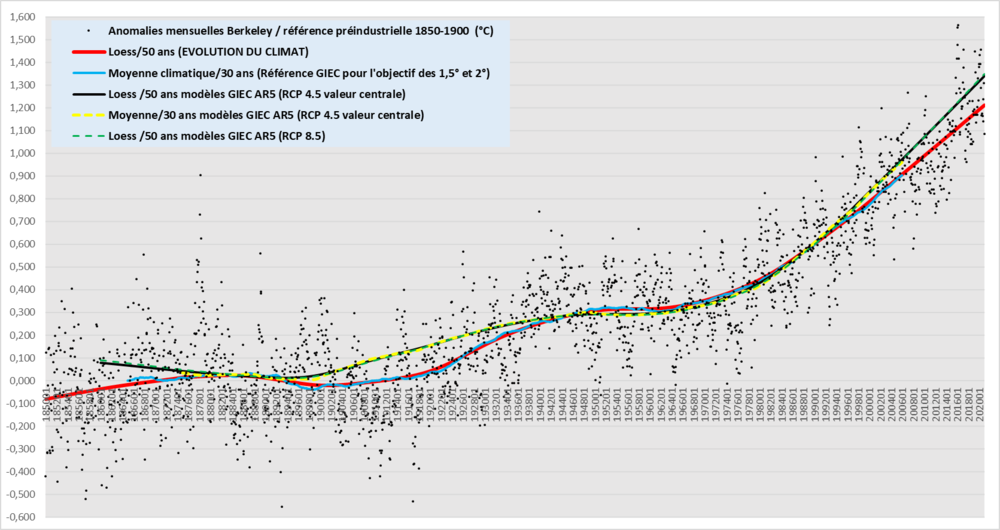

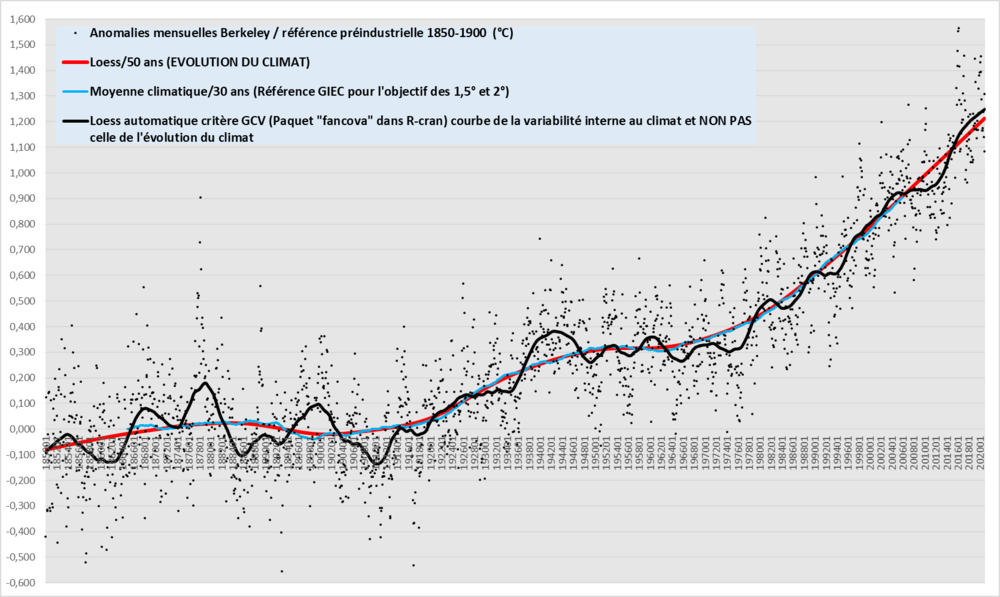

Evolution du climat avec la série la plus précise : http://meteo.besse83.free.fr/imfix/climatberkvarinterne2020.png Comparaison avec les modèles de l'AR4: http://meteo.besse83.free.fr/imfix/climatberkar42020.png Comparaison avec les modèles de l'AR5: http://meteo.besse83.free.fr/imfix/climatberkar52020.png Je ne suis pas chaud pour comparer les anomalies annuelles bruitées avec du fond vu que les modèles ne savent pas situer et quantifier le bruit avec le bon timing, mais voici d'autres bilans et comparaisons récupérées ailleurs. Avec CMIP5 : http://meteo.besse83.free.fr/imfix/obscmip52020.png Avec CMIP5 dernière génération : http://meteo.besse83.free.fr/imfix/obscmip52020derg%e9n%e9ration.png Avec CMIP6 : http://meteo.besse83.free.fr/imfix/obscmip62020.png Comparaison des données homogénéisées avec données brutes (GHCNV4 + Hadsstv3) : http://meteo.besse83.free.fr/imfix/obs2020brut.png Bilan des séries avec la nouvelle version 5 de Hadley (elle rentre dans le rang, avec un meilleure estimation des SST et de l'interpolation) http://meteo.besse83.free.fr/imfix/hadleyv52020.png L'influence de l'ENSO : http://meteo.besse83.free.fr/imfix/influenceenso2020.png Et pour fixer les idées, les 2020 dernières années malheureusement sans les IC bien larges : http://meteo.besse83.free.fr/imfix/Var2020ans.png -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

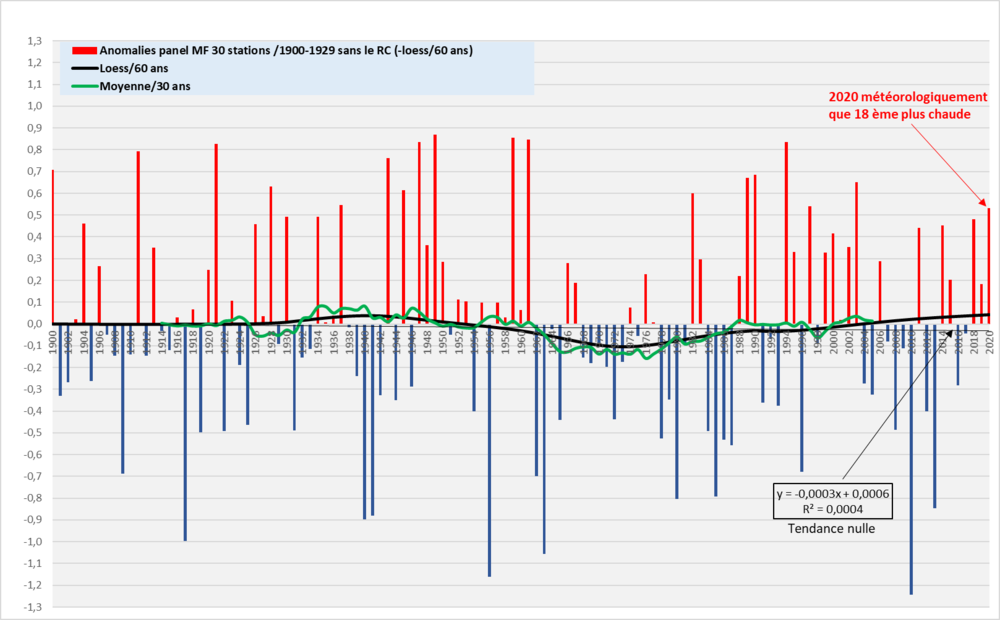

Pour répondre à Boubou07, c'est un problème mathématique à résoudre. Pour ne pas être biaisée, (c'est une règle mathématique sous-jacente à respecter/à vérifier aussi pour la validité d'autres estimations statistiques classiques), une moyenne représentative ne doit pas contenir de tendance significative (au RC ou au refroidissement) et même s'il n'y avait pas de tendance, les valeurs doivent être distribuées assez aléatoirement. C'est ce qu'on obtient avec la météo, sans RCA, malgré que le climat évolue avec une tendance de fond lente (Sans le forçage anthropique on verrait une tendance négative sur des centaines d'années) qui ne biaise pas les moyennes/30 ans, bien qu'elle biaise des moyennes de plus grande échelle (car significative pour elles et pas sur 30 ans. C'est une question d'échelle). Même si on ne tenait pas compte de la distribution biaisée, ce qui est une erreur mathématique pour analyser la normalité météo d'une valeur observée par rapport à une référence, elle est biaisée du fait que la dernière moyenne/30 ans calculée fin 2020 est centrée/valable pour le présent déjà bien lointain de 2005. Et oui avec la tendance de fond significative, elle change trop vite et elle représente la référence du climat du passé en 2005 (et non pas en 2020), alors qu'aujourd'hui à cause du RC, on a besoin de comparer les anomalies du présent à la moyenne/30 ans qui sera connue qu'en 2035 (centre en 2020), celle qui représente le climat du présent (sous réserve que la tendance au RC ne soit pas significativement différente). Il restera le biais de distribution avec des valeurs non aléatoirement distribuées de part et d'autre du centre de la moyenne/30 ans centrée sur 2020, qui ne permet pas de quantifier/visualiser assez précisément le bruit météo/le niveau d'anormalité/normalité ou pas autour du fond, et surtout en comparant les anomalies avec le passé, on ne voit que 2020 la plus chaude alors que "météorologiquement" depuis 1900 sans le RC de fond elle n'est que 18 ème (voir le graphe plus bas). Sur mon graphe précédent avec la référence faite pour voir le RC depuis 1900-1929 (biaisée comme absolument toutes les autres références/30 ans hors plateau significatif, si on cherche à quantifier/situer le niveau de bruit météo ), on voit que les anomalies sont de plus en plus souvent chaudes, mais ça ne montre pas que l'influence de la météo seule qui a donné une anomalie anormalement chaude ou froide sur toute la période. C'est brouillé par le signal de fond au RC. A l'inverse du suivi du climat, on doit faire ressortir le bruit sans contamination par le signal de fond du RC. C'est là qu'il faut justement chercher à se noyer dans le bruit et non plus afficher le fond qui le modifie en apparence. Il faut donc une référence fixe (biaisée de fait) pour suivre le RCA, donc la référence préindustrielle sur 1900-1929 (faute de données depuis 1850 ou 1880 pour la France) comme sur mon graphe du message précédent, et une autre référence où le RC de fond est retiré afin de voir vraiment la normalité de la météo du présent par rapport à une référence pour le présent, donc stable au fil du temps. Pour estimer le fond, sans physique, c'est déjà pas mal et beaucoup mieux que n'importe quelle moyenne, d'utiliser un loess adapté en respectant les changements significatifs de tendances. Il faut lisser assez pour ne pas afficher des variations non significatives, tout en ne lissant pas trop, pour bien situer et ne pas masquer des changements significatifs de tendance. J'avais effectué ce boulot au niveau global sur la série Berkeley, c'est un loess 50 ans l'idéal à cette échelle. Je n'ai pas les données mensuelles du panel MF depuis 1900 pour sortir un loess plus précis pour suivre l'évolution des anomalies annuelles (Un loess /x ans calculé à partir du pas annuel, n'aura pas strictement la même forme qu'un loess/x ans avec les anomalies mensuelles ( pour une même durée), car on ne dispose pas des 12 fois plus de points pour le calcul). Voici avec ce graphe un exemple de référence très peu biaisée par le RC de fond, qu'on devrait actualiser chaque année : http://meteo.besse83.free.fr/imfix/anomaliespanel2020sansRC.png où j'ai simplement retiré le RC de fond (*). La tendance est nulle, on voit qu'il ne reste plus grand chose comme signal avec un loess/60ans et les moyennes/30 ans qui ne sont pas significativement différentes (c'est normal qu'il reste du bruit météo et climatique impossible à départager à ce niveau de finesse et de non significativité, surtout sur la France). L'ensemble de la distribution est la signature de la normalité de la météo autour d'un climat normalisé présent de référence rendu stable par le retrait du signal de fond (on ne retire jamais que et toute le fond et il y a probablement aussi un peu de bruit météo perdu). Il est possible qu'il y ait encore un mini biais dans la distribution ( Ce n'est pas significatif que les anomalies froides extrêmes soient un peu plus basses/ aux anomalies chaudes) qui disparaitrait peut-être si je disposais des températures moyennes mensuelles du panel MF depuis 1900 pour étudier plus précisément le lissage loess plus précis. Par contre pour un mois donné, ça ne changera rien, vu que je ne récupérerai pas plus d'échantillons, car ça dépend que du nombre d'années. On remarquera que les anomalies chaudes récentes, ne sont pas très anormalement chaudes par rapport à celles observées vers les années 40 ou ailleurs (avec 2020 que 18 ème plus chaude), et donc nous n'avons pas profité encore d'une météo la plus favorable à un record annuel monstre. La probabilité qu'il fasse bien plus chaud au minimum en apparence en France à cause de la météo (sans aucune accélération du RC sur le fond), est plus grande que de voir ralentir le réchauffement apparent (RC de fond sans changement + météo). (*Le loess/60 ans du graphe de mon message plus haut, lissage à affiner pour coller aux changements significatifs de tendances, car là 60 ans, ça correspond au lissage automatique d'un paquet R qui analyse les changements de la variance et qui est sensé mettre en évidence du bruit interne qui ait un sens, ce qu'il parvient à détecter au niveau global mais pas pour la France trop réduite et donc trop bruitée. Ce lissage de 60 ans correspond à ce que j'avais au préalable choisi pour faire ressortir l'évolution de fond pour coller aux moyennes/30 ans et utiliser les tendances/60 ans correspondantes (j'ai regardé sur 40, 45, 50 et 55 ans, ça ne colle pas, on voit au minimum une mini variation non significative parasite). On obtient bien une tendance nulle avec des moyennes/30 ans pas significativement différentes les unes des autres, des anomalies assez bien distribuées aléatoirement. C'est une référence très peu biaisée) Pas la peine de chercher avec des moyennes sur 10 ans, c'est bien pire pour l'échelle de la France, vu que la moyenne/30 ans est déjà un peu trop bruitée avec le panel (et bien trop sur certaines stations. 30 ans, c'est insuffisant pour certaines stations d'autant plus que l'écart-type est plus important dans une station donnée.) car on injecte de fait du bruit météo qui brouille la connaissance d'un climat de référence qui change encore plus rapidement et elle a aussi sa validité que dans le passé (on ne connait pas la moyenne/10 ans relevée en 2025 qui sera de toutes façons trop biaisée par la météo, en plus du biais de la tendance de fond). Avec 10 ans on aurait fait du négativisme en disant que le RC n'existait plus de 97 à 2012, vu que la moyenne glissante / 10 ans évoluait très peu alors que la moyenne/30 ans continuait sa progression et que la tendance au RC n'avait/n'a pas changé significativement depuis environ 1970. On ne peut pas non plus pour la France, comme le fait le GIEC pour estimer le RC au niveau global (en complément des méthodes antérieures), utiliser la moyenne/10 ans centrée sur la dernière décennie pour estimer la moyenne/30 ans qu'on relèvera/vérifiera que fin 2030. Ex, fin 2020, pour le GIEC, au niveau global, la moyenne/10 ans, 2011-2020 sera le centre de la dernière moyenne/30 ans sur 2001-2030 (celle que l'on estime fin 2020 et connue qu'en 2030), sous conditions que la tendance reste assez identique, sans volcans, et autres accidents... La France est trop petite, avec la variabilité habituelle à cause de la météo, 10 ans c'est trop bruité pour en déduire une référence non baisée pour une estimation de la moy/30 ans fin 2030, centrée sur 2011-2020. La distribution et le niveau des valeurs observées passées et présentes ne dépend vraiment plus assez de la météo mais beaucoup trop du signal de fond au RC pas assez lent (car significatif pour des périodes de 30 ans) pour ne pas contaminer la normalité statistique/ représentativité météo et d'une moyenne / 30 ans pour le présent. Pour rappel, la méthode supplémentaire d'estimation du RC (et non d'une référence pour extraire la normalité de la météo) donnée dans le SR15 : "Réchauffement planétaire : Estimation de la hausse de la température moyenne à la surface du globe au cours d’une période de 30 ans ou de la période de 30 ans centrée sur une année ou une décennie donnée, exprimée par rapport aux niveaux préindustriels, sauf indication contraire. Pour les périodes de trente ans couvrant des années passées et futures, il est assumé que la tendance multidécennale au réchauffement observée actuellement se maintiendra." "In the latter case, when using a single decade to represent a 30-year average centred on that decade, it is important to consider the potential impact of internal climate variability." "On the definition of warming used here, warming to the decade 2006–2015 comprises an estimate of the 30-year average centred on this decade, or 1996–2025, assuming the current trend continues and that any volcanic eruptions that might occur over the final seven years are corrected for. Given this element of extrapolation, we use the AR5 near-term projection to provide a conservative uncertainty range." -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

La pente du loess s'écarte progressivement (cette fois comme la pente linéaire depuis 1970), mais pour le moment les observations sont encore considérées conformes aux prévisions, car l'écart n'est pas statistiquement significatif (Car l'IC du bout du loess est de +-0.28°, donc il recouvre une partie de l'IC des prévisions. Par contre l'IC du loess n’englobe plus la valeur centrale des prévis optimistes à suivre, mais on ne peut toujours pas du tout dire que le signal de fond observé est probablement différent de la prévis. Ce serait catastrophique et imprévu que les obs deviennent si tôt significativement différentes du pire scénario du graphe avec de tels IC larges et la pente du pire scénario.) (Salut Dann !) Un loess effectue une synthèse entre l'évolution des moyennes et des tendances linéaires (du moins quand on le règle sur le degrés 1). Il permet d'estimer les valeurs manquantes à cause du centrage nécessaire des moyennes. Il évite aussi des biais, comme par exemple, une moyenne aveugle sur la tendance, qui peut être plus chaude que la précédente, de la même valeur pour une tendance linéaire interne qui sera pourtant négative pour cette même variation positive de la moyenne, simplement à cause d'une distribution inverse/différente des valeurs autour du centre de gravité de la tendance interne dans cette moyenne plus chaude, alors que cette anomalie moyenne ne montrera rien de l'évolution négative/différente en cours. Pour ce cas, c'est comme si on comparait des moyennes /30 ans tout en tenant compte des tendances linéaires/60 ans ( qui est en fait la comparaison de la distribution par rapport au centre de gravité de la tendance, de 2 sous-suites de 30 ans). On voit aussi l'avantage du lissage sur le premier graphe par rapport à une moy/30 ans, qui est de fait une durée insuffisante pour l'échelle de la France (pour le pas climatique), car encore trop bruitée (elle affiche des variations non significatives de l'évolution du climat) et ça permet d'estimer les valeurs absentes à la fin à cause du centrage de la moyenne. Dans le cas présent, c'est à cause de valeurs fortes sur la fin (la moyenne est aveugle et se fout de la position des valeurs), que la pente du loess colle plus vite à la tendance linéaire depuis 70 (ça compense le fait que le début du loess/60 ans intègre encore des valeurs faibles du signal linéaire significativement différent, du plateau significatif (tendance nulle) qui finit au moment du changement significatif de tendance linéaire vers 1970. Sans changement linéaire significatif sur le fond depuis 1970, ce n'est qu'en 2030 que le loess/60 ans (en n'intégrant plus aucune des valeurs faibles de la tendance différente d'avant 70), devait finir par se retrouver mécaniquement aligné sur la pente linéaire depuis 1970, si du moins l'évolution des moyennes/30 ans poursuit sa hausse et qu'il n'y a pas de changement significatif de tendance linéaire. -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

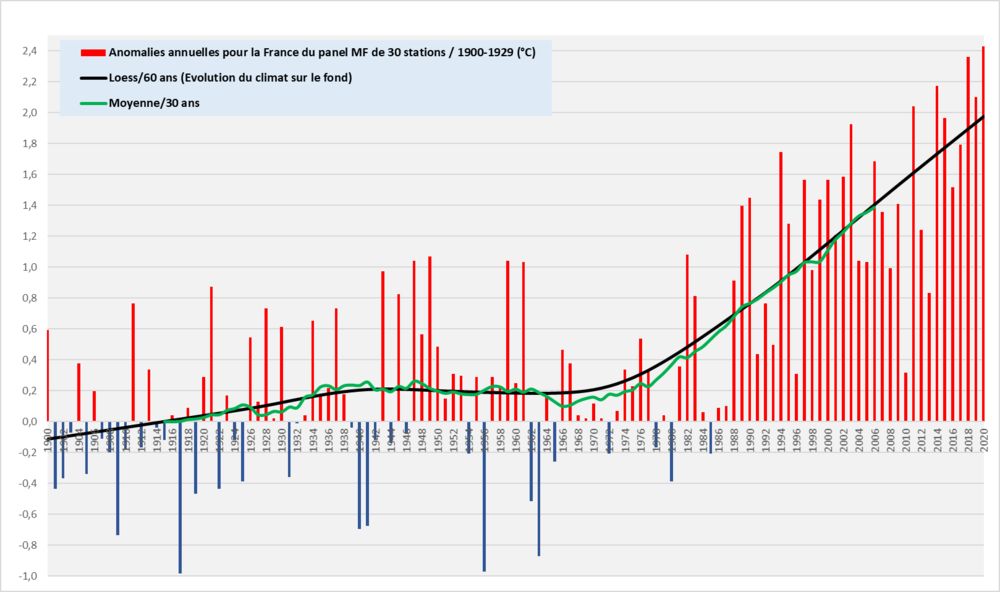

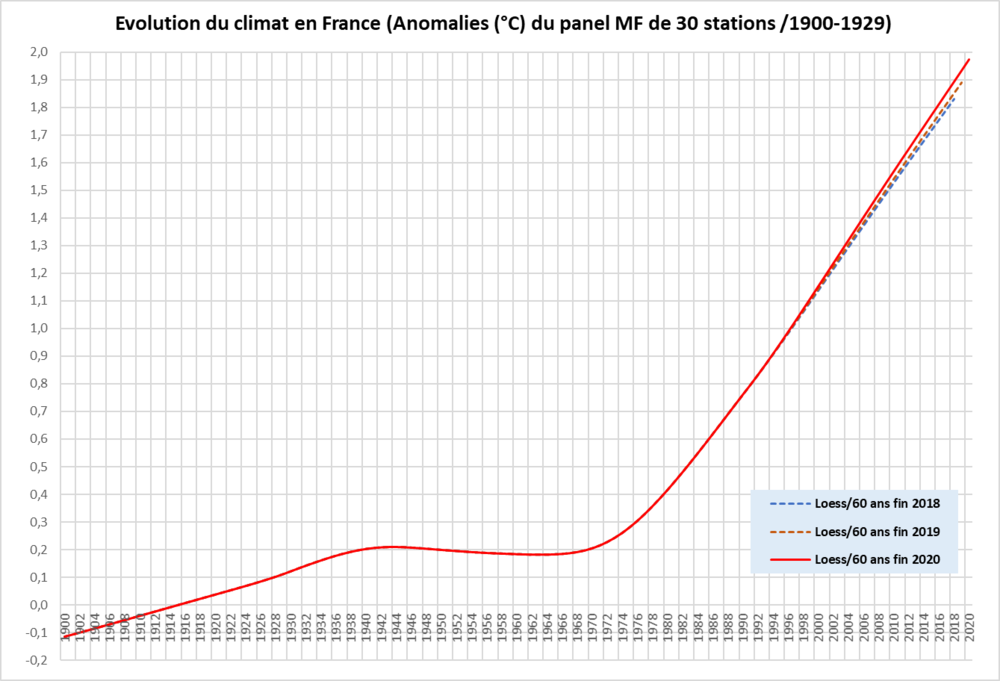

http://meteo.besse83.free.fr/imfix/anoloessmoy30france2020.png Evolution de la pente du Loess : http://meteo.besse83.free.fr/imfix/climatloessfranceobsfin2020_19_18.png A cause des deux derniers records annuels proches, la courbe rouge a déjà atteint le même niveau de pente que la tendance linéaire sur 1970-2020. Cette pente pour le loess/60 ans, était sensée être atteinte qu'en 2030 pour une même tendance de fond (sans accélération). Vu la dernière anomalie moyenne/10 ans (1.85°/1900-1929) et sans valeur à plus de 2° d'anomalie pour 2021, malgré la tendance de fond de 0.4°/déc sur 1970-2020, il est donc plus probable que la pente du loess fin 2021 se situe entre celle de 2019 et de 2020. Comparaison avec les projections pour la France : http://meteo.besse83.free.fr/imfix/projectionsfranceobsfin2020.png -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

J'ai mis à jour mon graphe de l'année dernière avec l'anomalie provisoire (ça ne va pas se refroidir de nombreux centièmes en une semaine !) de MF de 2019 pour la France. Ici fin 2018, j'avais comparé la partie concernée du loess/60 ans (recalé sur 1976-2005 des projections) avec les projections pour la France du graphe extrait de " Evolution des températures annuelles/saisonnières Climat passé et futur – France métropolitaine " (MF) Je n'ai pas de temps à consacrer pour rentrer dans les pixels et coller le dernier loess/60 ans à jour fin 2019 sur les projections, pour si peu d'évolution à la hausse entre fin 2018 et fin 2019 comme ce sera le cas chaque année tant que le Loess/60 ans n'a pas rattrapé la pente de la linéaire calculée depuis 1970, plus pentue, du moins s'il n'y a pas de changement significatif d'ici 2030 (Les projections n'en prévoient pas !). Je montre plus rapidement la différence avec la logique petite augmentation de la pente du Loess ici : Il faut bien voir que sans un changement statistiquement significatif (ce qui n'est pas du tout prévu d'après les projections du graphe MF, sinon on verrait un palier dans ces projections, comme par exemple celui d'avant 70, aussi au niveau global que les modèles des projections simulent assez bien), la pente du loess/60 ans ne peut que s'accentuer progressivement sans aucune accélération, ni stagnation significatives sur le fond, simplement au fil du temps jusqu'à environ 2030 pour "une même" tendance linéaire ( qui peut-être différente mais que visuellement, non significativement différente) des anomalies annuelles (ou mensuelles) depuis 1970, car le loess/60 ans intègre encore des valeurs annuelles/mensuelles faiblardes, du plateau/hiatus, lui significatif, d'avant 1970. Ceux qui s'évertuent à vous montrer des lissages pour la France et des moyennes/10 ans en vous faisant croire que c'est pour suivre l'évolution du climat, que ce soit MF, le pape des physiciens (surtout les allergiques aux stats élémentaires), ou autres, vous induisent en erreur. Les moyennes sur 10 ans à cette échelle, servent simplement à montrer un certain niveau de variabilité interne qui parfois colle à l'évolution de fond du climat, mais malheureusement pas toujours en réagissant encore trop avec l'impact du bruit interne, non significatif de l'évolution sur le fond à l'échelle climatique nécessaire (On peut voir d'ailleurs que la courbe de la moyenne /30 ans (verte) est encore trop bruitée à l'échelle de la France, mais bon on arrive à discerner facilement l'évolution de fond -modéré- ) -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Ton oeil ou le mien, ou autres, ne sont pas scientifiques pour ce niveau de finesse de courbure, tu opposes du pifo à des calculs, je ne vois pas la même chose. Je t'ai expliqué pourquoi dans ma réponse (car la différence significative entre la linéaire et la quadratique, ainsi que la physique (une accélération est prévue avec une courbure), indiquent qu'on doit explorer ce fit, donc de fait c'est comme vérifier si la dérivée seconde avec ses IC, est significativement positive/différente de 0.) Je vois bien que tu suis le bruit avec ton oeil, alors que le mien suit le fond qui met la courbure moyenne plus loin. Différence de vue cohérente avec ton problème qui ressort dans de nombreux messages ! Là on n'en est qu'à chercher les prémisses d'une accélération, une légère courbure significative et non la robustesse qui ne peut venir que bien après. On constate qu'on n'a jamais été aussi près d'une accélération et plus loin de la tendance centrale linéaire positive sur le fond depuis 1970. Ensuite il faudra attendre que les tendances linéaires soient significativement différentes sans saut de tendance non physique (ce que des pointures en physique ont ignoré à l'époque du hiatus, du moins certains qui n'apprécient pas les stats, ont utilisé pourtant les stats pour une hypothése de départ, comme des bras cassés. J'ai vu les débats sur le blog de Hawkins et j'ai constaté à quel point il est anti-stat quand ça l'arrange, mais pas pour pondre des trucs faux pareils en utilisant les stats comme hypothèse de départ, avec ses collègues ...) et que les méthodes les plus pointues de détermination des points de changements significatifs, affichent aussi la significativité, ce que tu verras dans des papiers comme à l'époque du non hiatus pour ces méthodes qui le martelaient. La robustesse est encore loin. Déjà que l'IC de la courbure vers 1970 est de 16 ans, tu ne risques pas de me sortir une date de changement de tendance plus précise qu'autour de 1970 comme tu le fais à l'oeil là avec 1980 sans aucun calcul. Comme à ton habitude que du baratin, jamais de démonstrations rigoureuses falsifiables. Démonte Tamino mathématiquement et non avec les mains ou l'oeil et tu deviendras crédible et tu nous apprendras enfin quelque chose (c'est ce que j'attends d'un prof, d'un scientifique, qu'il corrige les erreurs que l'on ne voit pas, mais rigoureusement ! ) Tamino ne risque pas de publier un papier basé que sur des quadratiques même de toutes les séries qui seraient très significatives, ça ne suffit pas et ce serait un gros gag comme papier, mdr ! Je ne doute pas que Tamino and co, ne manqueront pas de publier s'ils détectent un changement robuste de tendance avec son traitement du bruit surtout si des physiciens ne parviennent toujours pas à prévoir le bruit interne assez correctement (donc au minimum à bien prévoir l'ENSO avec la bonne intensité et le bon timing à toutes les échelles internes à 30 ans, de quelques mois , et de 1 à x ans), s'entêtent comme à l'époque du hiatus à ne pas tenir compte de l'absence nette de significativité du plateau/hiatus et à la présence nette de la significativité de la poursuite du RC de fond et continuent à se/nous noyer dans le bruit du hiatus insignifiant comme à cette époque et donc à faire de même quand une accélération sera présente clairement avec toutes les méthodes statistiques. Il le verra plus rapidement qu'avec les données classiques avec ses données débruitées (Malgré son papier sur l'absence de hiatus qui a été repris par le GIEC, il a fallu des années encore pour que le hiatus soit reconnu comme insignifiant pour le fond, un non hiatus, mais bon c'était évident depuis longtemps avec les analyses statistiques des obs.) C'est quand même incroyable que quand il n'y a pas de hiatus significatif (en prime très loin de pouvoir l'être), des physiciens le mettent au premier plan et ne voient plus que lui pourtant insignifiant pour le fond et là on approche d'un début d'accélération significative alors que le hiatus n'était pas du tout proche de l'être, et hop tu lui sautes dessus sans aucune démonstration rigoureuse qui montre qu'il s'est planté ! Même Zeke Hausfather a montré le parallèle sur twitter, en titrant pour blaguer "accélération !" en affichant la tendance linéaire plus forte (qu'en apparence) comparée à celle du hiatus. Il a aussi montré le peu de papiers traitant de l'accélération (visuelle) comparés au palier ( tout aussi visuel mais lui à l'inverse très loin de la significativité) ! Je ne doute donc pas que certains cadres qui sont incapables de tracer des courbes sur des durées dignes l'échelle climatique pour nous montrer l'évolution du climat quand ils en parlent (et non celle à la petite semaine sur 5, 10 ou 15 ans), et qui se sont acharnés à voir de l'importance et de l'anormalité imaginaire pour le hiatus pourtant très loin de l'être, ne risquent pas de voir une accélération même si elle devenait hyper significative statistiquement (car tant qu'ils ne le perçoivent pas physiquement avec leurs équations dans les modèles, malgré leurs grandes compétences pour parvenir à prévoir l'évolution de fond sur des périodes de 30 ans, certains finissent à l'évidence par nier la réalité des obs, et surtout à mettre les méthodes statistiques à la poubs quand ça les arrange et à les utiliser quand sa soutient leur idée même quand c'est faux aussi bien mathématiquement que physiquement, ce qui est plus grave ! Elles sont pourtant nécessaires tant qu'on ne sait pas prévoir le signal de fond interne comme en météo, à une échelle où les stats ne servent pas à grand chose (personne ne sort des méthodes stats pour prévoir une tempête à 24h, on regarde les modèles. Donc tant qu'on n'en n'arrive pas à ce niveau pour prévoir la variabilité interne 10, 20 et 30 ans, il faudra faire avec les stats). Le problème de certains physiciens est donc déjà nettement ressorti avec cette histoire du hiatus, car ils sont restés à fond la tête dans le guidon, avec leur zoom fixé sur le signal interne trop court et imparfait (parfait de fait dans leur tête pour ne pas voir le problème) des modèles physiques sans tenir assez compte des échelles temporelles, et donc de raisonner sur une échelle temporelle trop courte sans assez d'échantillonnage des modèles qui ne montraient logiquement pas une telle fréquence de ce type de palier (2% de proba d'après les modèles de voir un tel hiatus non significatif, contre 50% de rencontrer un palier d'au moins cette durée selon les obs et l'analyse statistique à l'époque...). Je me rappelle du papier ( et que j'avais cité dans IC à l'époque) qui est passé après que les pointures valident l'existence du hiatus, qui montrait le problème de ces meilleurs physiciens (ils partaient d'une hypothèse statistique dans leur papier alors qu'ils n'aiment pas les stats, en prime totalement fausse, car ils utilisaient 2 tendances linéaires avec un saut de tendance pas du tout physique (c'est la différence biaisée entre les 2 tendances avec ce saut non physique, qui est à l'origine de leur papier en plus de l'écart de cette tendance trop courte, avec celles des modèles) et non validée par les stats (ils ont fait une comparaison de tendance de débutant !), un saut qui n'existera jamais dans la nature pour la T globale ( Le hiatus à étudier était celui du problème de la prévision de ces tendances à courte échelle temporelle, la différence entre la réalité des obs qui donne très probable de tels hiatus et les modèles qui les voient si peu, logiquement car pas faits pour prévoir à cette courte échelle, mais des physiciens l'oublient clairement souvent, vu leur raisonnement affiché dans les faits, en zappant les IC monstrueux des prévisions décennales et le fait qu'ils rament pour prévoir à l'avance simplement l'ENSO). Donc ton histoire de, " j'ai l'habitude des signaux", oui je crois sincèrement que tu es très bon pour analyser le moindre bruit fin, interne, qui est un signal de fond pour toi, bien plus que n'importe quelle méthode stat, mais tu ne montres clairement pas du tout que tu l'es pour savoir si le signal fond d'une échelle temporelle plus grande évolue ou stagne, accélère, car tu montres au contraire que ton oeil ne voit que le bruit et pas le signal moyen. Ca saute encore plus aux yeux quand tu parles de la France avec ton suivi de courbes sur 10 ans (courbe d'un certain niveau de bruit et non d'évolution du climat !), comparé à un Loess/60 ans et alors que tu soutiens que ça doit ralentir alors que les projections ne montrent aucun ralentissement significatif sur le fond capable d’empêcher l'accentuation de la pente d'un loess/60 ans sans absolument aucun changement significatif (des baisses visuelles, des plateaux visuels, non significatifs, ne changeront rien à ce fait mathématique élémentaire qui te dépasse car tu es noyé dans le bruit. Je vais mettre à jour le graphe à 2019 avec l'anomalie provisoire de MF dans le sujet national, tu verras, ce qu'il se passera obligatoirement pour le Loess sans un changement significatif au fil des ans jusqu'en 2030.) Donc quand je vois ton raisonnement avec ton oeil et tes courbes sur 10 ans, et que les plus hautes pointures mondiales font ce genre d' erreur élémentaire de rater un saut de tendance non physique, et que le papier fait pour montrer leur erreur était digne d'une révision cours de stats à la fac et non un papier qui fait avancer la science, on peut dire que la capacité de certains physiciens à lire des obs est inversement proportionnelle à la qualité de leurs capacités à pondre de très bons modèles physiques pour prévoir la météo ou le fond sur une échelle climatique efficace (évolution de moyennes / 30 ans, peut-être 20 ans, pour le moment). Pour moi il est clair que dans certaines équipes de physiciens, avant de publier, il manque clairement de bons relecteurs en stats de type, Tamino, Mestre, Venema et autres. -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Je ne vois aucune extrapolation, je ne vois pas où il prolonge les données dans le futur, ce sont des obs, de plus il n'y a qu'une série est qui est significativement en accélération depuis 1980, en prime celle non recommandée pour la climato, ERA5 (Si tu appelles extrapolation le fait d'explorer la courbe quadratique plutôt que la linéaire, ce sont les tests statistiques qui commandent de la regarder dans le cas présent plutôt que la linéaire, car c'est significativement meilleur que la linéaire. De plus physiquement on est sensé observer une accélération un jour ou l'autre, donc une courbure en moyenne, et même si c'est plus tôt qu'attendu (autour de 2050), il faut regarder ça de près quand on commence à l'entrevoir dans les obs). Ensuite il traite le bruit habituellement selon son papier admis par les pairs (traitement admis par le GIEC aussi). Donc avec du bruit en moins dans les données, les IC sont plus petits, on pourra détecter une accélération sur le fond plus tôt qu'avec les données habituelles, mais malgré ça, il n'y a qu'une deuxième série qui montre une accélération significative (NOAA), mais que de peu. De plus si on change l'année ou des mois de départ ou de fin, ça ne l'est plus, donc tout ça fait que ce n'est pas une accélération à laquelle on peut se fier, on ne la considère pas (que ce soit Tamino et autres), mais c'est à surveiller, donc qu'est ce que tu veux de plus clair : que bien que nous soyons proche d'une accélération significative avec parfois de la significativité à la marge, elle n'existe pas encore dans les obs ? La concavité est moins dérangeante que la linéaire en moyenne quand c'est significativement meilleur mais surtout lorsque l’accélération sera devenue robuste (là c'est juste pour la détection de l'accélération, donc on n'a pas à prendre en compte cette concavité visible dans les obs, vu que ce n'est pas robuste. De plus même quand c'est robuste, les IC autour d'une année de changement significatif de tendance, sont parfois très larges, donc ça te fera bizarre. La prochaine accélération significative sera probablement peu courbée et ne sera jamais aussi nette que celle autour de 1970, sinon se serait vraiment très grave et les pires surchauffes prévues dans des modèles CMIP6, seraient dépassées !). Tout ça pour dire qu'on risque encore moins d'observer une accélération significative sur 10 ans comme le rapporte par erreur le journaliste plus sérieux habituellement. -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Oui, l'auteur utilise la même méthode qu'il reprochait aux négativistes avec le plateau, cette fois c'est côté chaud. Il a pourtant été informé de son erreur par des spécialistes du domaine comme par exemple ici, mais je vois à l'instant qu'il persiste dans les commentaires à la suite, où il montre qu'il ne ne sait pas que les barres d'erreurs d'une tendance/10 ans sont bien plus importantes que sur une valeur annuelle ! Pour le moment l'accélération significative est sur une bien plus longue durée (ce serait fort qu'elle le devienne que sur 10 ans !), mais elle n'est pas encore assez robuste pour la considérer, aussi d'après Tamino qui n'est pourtant pas le dernier à montrer la persistance et la force du RC pendant que la majorité plongeait dans le faux hiatus : https://tamino.wordpress.com/2019/11/08/global-temperature-update-6/ -

Changement climatique en France

ChristianP a répondu à un sujet de mickael23 dans Evolution du climat

Cotissois, tu contredis tes propres références où les scientifiques évitent justement de plonger dans la variabilité décennale d'autant plus que l'échelle spatiale est fine. Les courbes sur 11 ans des graphes HD que tu utilises, n'ont pas de sens pour le signal de fond climatique (le signal non interne au climat) à l'échelle d'une station bien trop bruitée (C'est déjà parfois trop bruité sur 30 ans à cette échelle), car c'est compliqué au niveau global où les prévis décennales sont encore très loin d'être efficaces. Les graphes de Dann17 sont bien plus parlants pour le fond que les graphes avec une courbe de la variabilité interne sur 11 ans. Montre nous à l'aide de références, si tu n'as pas de temps pour le démontrer toi-même, que les prévisions décennales à l'échelle d'une station ou de la France sont meilleures que celles au niveau globale sur 10/11 ans (Ce serait bien que tu produises quelque chose, car à part des incantations de plus en plus incroyables pour un scientifique, je ne vois rien et ta pédagogie n'est pas efficace. Comment veux tu que les gens aient confiance en la science si même toi tu sors des énormités qui plongent les gens dans le bruit interne et les énormes incertitudes de la prévis décennale même au niveau global "moins compliqué" !) A l'échelle de la France on a déjà assez de boulot avec l'incertitude de la modélisation pourtant loin de de l'échelle décennale, sans rajouter ta grosse couche de pifomètre quand tu insistes pour nous faire croire que l'échelle décennale est pertinente et efficace (elle ne l'est déjà pas avec les obs pour une station donnée ou la France (en terme d'évolution du climat sur le fond ) à tel point que certains négativistes ou scientifiques étourdis, se servent de cette courbe sur 11 ans sur la France pour faire croire au public que le climat ne se réchauffe plus en France, alors en prévis c'est pire que tout ...!) : Attribution pour les vagues de chaleur de juin et juillet : https://www.worldweatherattribution.org/wp-content/uploads/WWA-Science_France_heat_June_2019.pdf https://www.worldweatherattribution.org/wp-content/uploads/July2019_VF.pdf -

Canicule : d'ici 2050, des températures records de l'ordre de 55 degrés en France ?

ChristianP a répondu à un sujet de Ventdautan dans Evolution du climat

Cet histoire de sondage ne colle pas dans des secteurs comme la plaine du Luc, la topo et le foehn sont particuliers. Dans les records par vent de terre là-bas, la T est aussi la résultante de multiples compressions/foehn en amont en passant les collines et les mini plaines pour finir par un énième effet hot avec la plus forte compression, plus puissante encore, en tombant des massifs dans la plus grande et basse plaine au Luc/Le Cannet avant le massif des Maures. Plus on va vers l'W et NW du Var (selon la direction du vent de terre) et moins l'air est chaud malgré le vent de terre et malgré les cas avec une même T à 850 hPa, car il n'a pas subi autant de compressions successives. Donc analyse trop globale à partir d'un RS, il faut voir ça avec modèle de topoclimatologue. Avec la théorie globale des RS (et non à l'échelle fine), on n'aurait pas pu relever 42.2° au Luc avec seulement 21° à 850 hPa, http://www.meteociel.fr/modeles/archives/archives.php?day=5&month=8&year=2017&hour=12&type=ncep&map=0&type=ncep®ion=&mode=0 et alors même que ce record a été très tronqué à cause du vent de terre pas franc, qui a perdu rapidement contre la brise très tôt et dont je voyais le mur s'approcher et finir par stopper un peu plus tard mon record plus à l'W. Le 44° était largement jouable au Luc le 5 août 2017 avec un vent de terre qui serait resté jusqu'à 18h et non remplacé par la brise dans le début d'AM, ceci malgré les 21° à 850 hPa. Avec 28° à 850 hPa, à la place de 21° dans la même config pour tout le reste, ça nous fait déjà du 49° au minimum, avec le même vent de terre remplacé par la brise avec le même timing, donc plus avec du vent de terre jusqu'à 18h minimum ! C'est clair que ça peut arriver cet été comme dans 100 ans (au pire dans moins de 300 ans si on continue comme actuellement à se goinfrer d'énergie, c'est garanti avec une croissance de 2.3% de consommation d'énergie par an, même si on retirait tout le surplus de CO2 anthropique https://dothemath.ucsd.edu/2011/07/galactic-scale-energy/ ...) ou plus que toutes les conditions soient réunies au Luc. Les séries de données sont bien trop courtes pour estimer sérieusement les possibilités de la météo en Tx absolue un jour/mois donné, d'autant plus que le climat n'est pas stable et donc à l'instant t, comme la moyenne sur 30 ans se réchauffe en permanence, par définition on a qu'un record maxi journalier/mensuel/absolu du nouveau climat tant qu'il n'est pas stabilisé. Il suffit de voir l'écart de ces valeurs du 28/06 avec les courbes des records journaliers/mensuels/absolus diffusés ici ou là. Ca signifie de fait que sur des milliers d'années de ce climat stable au niveau du RC actuel, les valeurs records des 364 autres jours finiront à ce niveau de décalage respectif relativement au jour spécifique donné dans l'année, un niveau impensable avant cette journée. Amusez-vous à estimer les records potentiels ( au bout de milliers d'années sans plus de RC), pour d'autres jours de l'année, en décalant la courbe annuelle initiale des records journaliers avant ce record, jusqu'au niveau du record du 28/06 sans modifier la courbure... Tous les records journaliers qui ne sont pas battus très largement, deviennent insignifiants maintenant à cause de ce 28/06 car on sait que la météo a pu faire ce jour-là. Il n'y a aucune loi physique, ni statistique qui empêchera d'observer un écart énorme spécifique à la saison, au mois, au jour, un autre jour, respectant la courbure générale annuelle, c'est juste une question d'échantillonnage. On verra peut-être dans les analyses des pro, combien est attribué au RC et combien à la situ météo exceptionnelle, mais dans tous les cas, le fait est que ce niveau d'écart avec les autres records est possible même si on ne pouvait pas départager exactement les causes. J'ai très bien en mémoire l'air autrement plus limpide et sec dans l'absolu pendant le record de 42.7° du 7 juillet 1982 au Luc et les 40.4° à Toulon à 10 m de la mer (Il était difficile de se baigner sur les plages du Mourillon de Toulon, avec le vent fort très sec et l'eau froide. L'évaporation avec ce vent était terrible quand on sortait mouillé, on se gelait pendant un court moment malgré le soleil surpuissant avec ce ciel sans trouble et la T élevée) à l'inverse du ciel dans le Gard du 28/06 qui est très typique de ma brise de mer classique ici. Donc c'est clair qu'on peut faire plus avec des Td moins élevés et une situation favorable pour le vent de terre à ciel limpide. Quand on voit la valeur de Vinon sur Verdon dans le haut Var à 44.3° en site classe 1, alors que la masse d'air a été assez humide et instable pour générer des orages pas très loin, ça ne fait aucun doute que le Luc montera un jour bien plus que les 46.5° estimés par les stats. La situation favorable ne sera pas simple à atteindre au Luc, car depuis des années je remarque que le vent de terre résiduel ou non dans ces cas, ne parvient plus à atteindre autant la plaine du Luc et ici plus à l'W, malgré parfois des prévisions météo de son extension. Brignoles semble devenir une limite du vent de terre plus fréquente l'été. D'après moi le problème est qu'avec le RC supplémentaire, la dépression thermique de la plaine du Luc se renforce et protège le Luc plus souvent de l'extension du vent de terre qui se termine habituellement dans les Maures ou contre la brise avant le Dramont, une situation qui permettaient les plus gros records. L'idéal pour scorer au Luc ou ici, c'est d'être à la limite de portée du vent de terre. La brise dans l'autre sens est un véritable mur sur lequel l'air déjà comprimé x fois, vient encore plus se comprimer, et c'est de cette façon que Fréjus St Raphaël au bord de mer avait chiffré plus que Le luc en 83, une station classe 1 dans cette direction de vent alors que le Dramont tout proche était en brise, qui détenait auparavant le record de France au bord de mer avec 42° en 1983. Donc mon pronostic (d'illuminé averti 😂 ) spécifique au Luc maintenant qu'il est possible de relever du 28 à 30° à 850 hPa à grande échelle sur le SE, en oubliant les stats, c'est du 49-50° de nos jours dans le cas d'un vent de terre d'W assez bien établi dans ce coin de la plaine du Luc avec un air aussi chaud. (Mon estimation de 46.5° était basée que sur les stats sans l'effet spécifique et les possibilités observées de la météo et en particulier le 28/06. ) La théorie est trop globale avec un RS en prime pas réalisé au dessus de la plaine du luc et sans aucun détail de ce qui se passe partout dans les très basses couches au-dessus des massifs et des plaines en amont et de celle du Luc. Il faudrait disposer des infos et se concentrer sur les détails à une échelle très fines dans les très basses couches entre l'W Var en aval des massifs et la plaine du Luc. La topoclimatologie en amont et vers le Luc, jouent à fond pour produire du 42.2° avec 21° à 850 hPa. A l'inverse du climat, il faut raisonner à très petite échelle. Le RS donne une info globale très utile mais insuffisante pour un coin comme Le Luc avec tous les phénomènes de petites échelles de très basses couches partout en amont et surtout entre 2 stations de RS. Edit : J'ai d'ailleurs retrouvé une explication de Pierre Carrega qui m'a beaucoup appris en topoclimatologie, qui montre comme le foehn dit "sec au vent", par dynamisme peut réchauffer un max l'air, dans un extrait d'un vieux bulletin de MSE : "On a ce mardi 1er août un cas typique de Foehn « sec », c’est à dire sans pluie au vent du relief. Contrairement aux sempiternelles interprétations présentes dans les manuels, la plupart des cas de Foehn donnant une forte chaleur sèche sous le vent d’un relief (ici la Côte d’Azur) ne sont pas accompagnés de pluie au vent (versant W du massif Central et des Alpes), et ne sont pas des foehns « humides au vent ». On sait que dans ce cas la chaleur gagnée sous le vent, par rapport au vent, s’explique par une épaisseur de compression adiabatique « sèche » (sans condensation) plus importante sous le vent que ne l’est l’épaisseur de détente « sèche » au vent, car la masse d’air a perdu de l’eau par précipitation sur les reliefs au vent (pluies orographiques). Cette perte d’eau provoque à la descente de l’air, une fois passé le sommet, une rapide désaturation et un réchauffement adiabatique « sec » beaucoup plus important que n’a été le refroidissement en mode saturé à la montée. Dans le cas de ce 1er août, la plongée de l’air sous le vent n’est pas précédée d’une ascendance au vent. Le phénomène est purement dynamique et relève de la mécanique des fluides : la vitesse suffisante du flux de secteur W vers 3000-4000m d’altitude conjuguée à son orientation par rapport au relief préalpin le fait plonger, et gagner environ 1°C par 100m, soit 30° pour 3000m de descente… (fig 7). Les quelques nuages lenticulaires constatés se moulent dans la partie supérieure des ondes engendrées en aval du relief (lignes rouges)." http://www.meteosudest.org/Pierre/BulletinPC01082006.php- 308 réponses

-

- 11

-

-