ChristianP

Adhérent Infoclimat-

Compteur de contenus

2904 -

Inscription

-

Dernière visite

-

Jours gagnés

1

Type de contenu

Profils

Forums

Calendrier

Tout ce qui a été posté par ChristianP

-

Le 28/06, la station de Besse sur Issole (83) a enregistré le nouveau record de Tx du mois de juin à Besse, 40.8° au thermo MF, 2 ème valeur de la station avant les 40.7° d'août 2003 et après le record absolu 41.8° en août 2017 et surtout c'est la première fois que le seuil des 40° est franchi avec une situation à brise de mer habituelle. Ancien record avec la brise 39.9° en 2003. 39.8° dans l'abri Young ventilé méca à la norme USCRN (Record absolu 40.7° en août 2017). 43.4° dans l'abri Socrima en site classe 4, même valeur qu'en août 2017. Preuve une fois de plus, qu'un site pas assez dégagé et/ou avec trop de surface et/ou de largeur de végétation courte trop haute dans les rayons de 5, 10 et/ou 30 m (du moins dans l'axe du vent concerné le jour de la Tx estivale donnée), ne permet pas de réaliser des comparaisons entre stations et pire de déterminer quel jour l'air est le plus chaud réellement, car les biais radiatifs sont trop présents et ils génèrent une dispersion des valeurs plus importante. Mais attention il faut vraiment analyser la direction et la vitesse du vent car les jours de vent venant de l'autre côté, des directions autour du secteur Est (secteur plus dégagé pour la classe 4 que pour la classe 2 !) il n'y a pas plus de +-0.2° d'écart hors cas rares pour 2 Socrima ( Là c'était à l'époque de la comparaison entre le Socrima en cls4 et le Stevenson cls 2 tout un été avec une bonne partie de mai , ), entre la classe 2 et 4 et le plus souvent moins. Le record le plus surprenant ici, c'est le record absolu de Tn avec 26.4° le 28 ( Ancien record 24.0° en août 2016, ancien record de juin, 22.5° en 2014, en 2003 il avait fait encore moins chaud la nuit, ici.) Avec l'ami Cévenol13, en ce jour historique incroyable pour la météo, pour la climatologie française et pour notre association/ notre le site et donc pour les plus de 1000 adhérents, les milliers de passionnés qui alimentent notre site et les forums, nous ne pouvions pas ne pas être en live sur le terrain de départements en vigilance rouge canicule, (surtout moi addict à la chaleur, allergique au froid, il me faut un bandeau sur les oreilles en vélo à partir de 15°, sinon douloureuses, elles casseraient seules, car glacées !), candidats au record de France de température maximale, avec le matériel nécessaire dans un site parfait classe 1 afin d'être certain de recueillir une mesure scientifique et représentative d'une très grande étendue de l'air entre 1.5 m et 2 m du sol, sans biais radiatifs majeurs autres que les défauts et limites bien connus des abris à ventilation naturelle, surtout ce jour avec un vent de terre soutenu de N à NE sur ce secteur de Teyran (Au NNE de Montpellier). ll aurait fallu choisir le site dans la région les jours avant ou au minimum la veille, mais bon impossible avec nos obligations. Le jour même nous étions pris par le temps, avec une mauvaise circulation et sur les cartes on ne trouve pas d'infos sur la hauteur de la végétation, pour trouver un champ récolté/tondu il y a peu, avec une végétation courte de moins de 10 cm sur une étendue de plus de 100 m dans l'axe du vent du jour. Nous voulions nous installer pour midi au plus tard, afin que les abris climatisés par la voiture aient le temps de s'approcher de l'équilibre avec la T de l'air (La constante de temps d'un abri Socrima étant bien plus longue que celle de la Pt 1000 qui est de 60 s sous 1 m/s de ventilation d'air, même constante que celle utilisée dans le réseau au top de l'USCRN aux US) Voici des photos qui complètent celles du lien plus bas : http://meteo.besse83.free.fr/imfix/canicule062019net/Ouest.jpg Cévenol13 avait fait un premier point en direct le 28 dans le forum et publié des infos et photos : Au final entre 15h et 16h UTC, nous avons relevé 44.5° de Tx dans l'abri Socrima MF et 44.6° un peu plus tôt dans l'abri Davis Vantage Vue modifié (placé 35 m plus Sud que l'abri Socrima). Il faut rajouter 0.1° aux valeurs lues pour les différences inter-sondes des Pt 1000 à Besse (Exactement +0.12° pour celle du Socrima, +0.086° pour celle du Davis Vue) : Petit détour instrumentation : Dans les études US plus récentes dont j'avais donné les liens à l'époque, rien n'a pourtant changé, pas plus que les hollandais avec des bibles sur les comparaisons d'abris. Au moment de l'installation avant midi à Teyran, les capteurs affichent plus de 40° plus rapidement que je ne l'imaginais en sortant de la voiture polaire (clim réglée du coté de Cévenol13 à 20°). Après l'installation sous le soleil de plomb, la prise des mesures aux jumelles laser, les notes, les photos, en dehors de faire 300 m toutes les 30 mn sous le soleil pour regarder sur les afficheurs les Tx des dataloggers, nous sommes restés à l'ombre partielle (donc autour de 50° à l'ombre hors abri normalisé) dans la pinède vers le NNW, à analyser la situation avec les autres stations et les infos des passionnés d'Infoclimat. Je craignais que le smart ne fonctionne plus à un moment. La batterie externe supplémentaire apportée se mettait en sécurité et n'a plus rien voulu savoir avant des heures de clim pendant le retour infernal parsemé d'incendies et de routes dont 3 autoroutes, coupées : J'avais oublié le sac dans la voiture surchauffée avec des batteries de secours du smart ( qui date de l'époque où on pouvait les ouvrir à gogo sans problèmes pour changer une batterie très facilement), trop bouillantes, j'ai dû les mettre dans la glacière; elles n'ont pas apprécié la journée. Malgré cette faible activité physique de 11h45 à 18 h, entre 11h45 et 16h, j'ai bu 3.5 litres d'eau des 4 litres emportés (0.5 l le matin dans la voiture sur le trajet et je ne compte pas 1 l en plus des 4 l de liquides, absorbé chez moi avant le départ) + une canette de 33 cl de Perrier jusqu'à 16h. Il a fallu se réapprovisionner à 16h et boire 2 litres pour s'hydrater 2h de plus sur le terrain et les heures du trajet du retour (lui climatisé). Avec l'âge je dois avoir des fuites d'eau dans ma tuyauterie, mdr, vu que je n'avais pas besoin d'autant d'eau à Djibouti ou dans les terres du Soudan et autres fournaises avec plus chaud en étant plus actif et en passant plus au soleil. Ce fut une journée qui restera dans les annales de la météo, de la climatologie et dans la mémoire de tous les passionnés par cette science. A noter les 45.1° à Brignoles dans le Stevenson + thermo MF du site classe 3 de l'ex StatIC de Brignoles. Une des plus grosses différences observées en Tx par ciel clair, entre ma station et celle-ci à 18 km en ligne droite (le vent de terre n'est pas arrivé ici plus à l'Est).

- 87 réponses

-

- 18

-

-

-

Suivi du temps dans les régions méditerranéennes - Juin 2019

ChristianP a répondu à un sujet de Serge L dans Le temps en France

Au final à Teyran en site classé 1, pour les stations mobiles, Socrima et Pt 1000, 44.5°, abri Vue modifié et Pt 1000, 44.6°. Nombreux incendies dans le secteur sur le retour, 30 départs, 3 visibles des environs de St Gilles. 3 autoroutes fermées. Routes infernales un vendredi soir. 5 -

Suivi de l'englacement au pôle nord

ChristianP a répondu à un sujet de sirius dans Evolution du climat

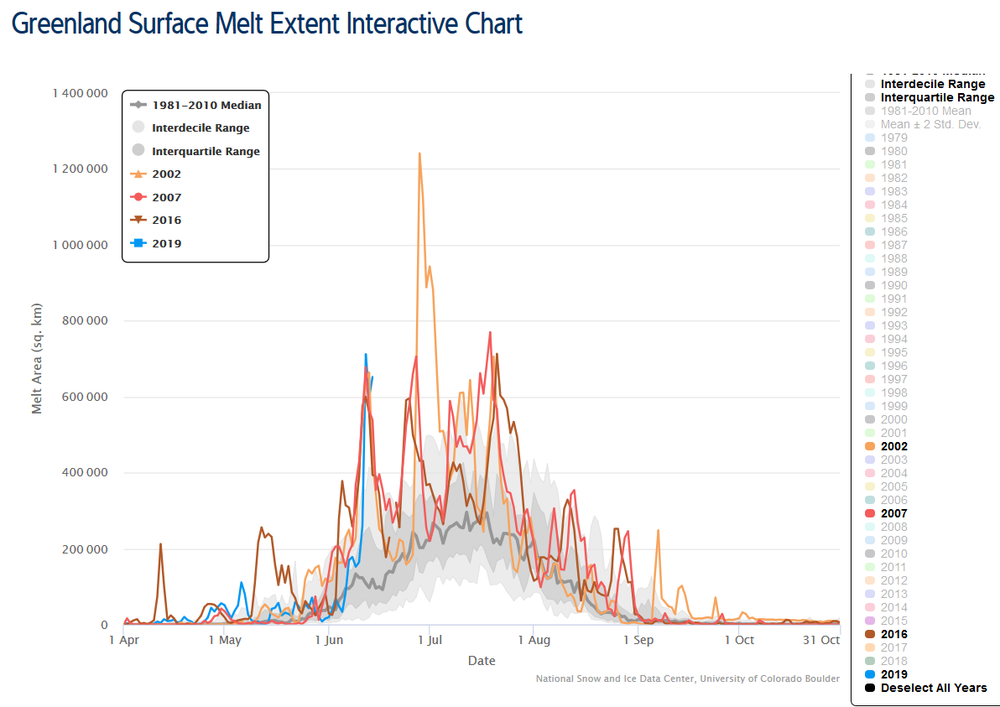

Bof, pas impressionnant ce nouveau record pour la période car en 2019 avec le RC supplémentaire depuis 2002, avec la tendance de fond, on devrait perdre bien plus d'un coup qu'il y a 17 ans et en particulier plus que pour le plus gros pic de fin juin 2002. https://nsidc.org/greenland-today/greenland-surface-melt-extent-interactive-chart/ -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Et oui quand les IC se croisent, on ne peut départager les valeurs, elles ne peuvent pas être considérées comme significativement différentes. C'est pour cette raison qu'il vaut mieux suivre les écarts d'au moins 0.1°. -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Pour ceux qui s'intéressent à la précision de l'anomalie de température globale annuelle : https://agupubs.onlinelibrary.wiley.com/doi/pdf/10.1029/2018JD029522 http://sci-hub.ren/10.1029/2018JD029522 (papier "libre"/hacké, lien probablement rapidement invalide) -

Suivi de la tempête MIGUEL - juin(!) 2019

ChristianP a répondu à un sujet de Sebaas dans Le temps en France

En juin 1987, 122 km/h. Je m'en rappelle bien, car j'étais sur la route dans le secteur. http://tempetes.meteo.fr/spip.php?article98 -

Projet station autonome - CHAUDEYROLLES (Les Narces)

ChristianP a répondu à un sujet de Ced30 dans Instrumentation

J'ai téléphoné à un responsable vendredi 31 mai. Comme je lui ai précisé, le principal problème de cette station pour la climato (d'IC, d'un passionné de vent maxi, de pluie en 1 mn, de captures de toutes les variations de T et autres comme avec des stations MF et Davis) c'est qu'elle ne mesure pas les paramètres pendant 80% du temps pour des raisons d'autonomie électrique ( 1 mois). La station travaille que pendant les 2 dernières minutes avant l'envoi des données toutes les 10 minutes, donc pendant 8 minutes, elle ne voit rien. Hors test capacité du matériel, même s'il était bon, c'est pour le moment une station utile pour assez bien approcher le vent moyen sur 10 mn, la T moy, des Tn lentes, pour des cumuls de pluies et faites pour certaines Tn des TAF, des événements ponctuels, des éoliennes, pour quelques valeurs qui ne correspondent pas aux normes climato. Elle n'est pas faite pour le vent maxi du jour, la T maxi, certaines Tn brèves, l'intensité des pluies, surtout ici ce serait plus qu' hasardeux, car la proba de capturer le vrai vent maxi du jour par exemple, est moins bonne que le hasard. Pour parvenir au niveau du hasard il faudrait déjà qu'elle capte les rafales sur le pas nécessaire minimal pendant 50% du temps et dans notre cas pour la climato c'est 100% du temps au pas de 0.5s et/ou 3 s. L'anémo intéressant, est piézoélectrique. Il mesure des pressions sur le cône en 0.1 s (donc sans problème d'énergie pour échantillonner en permanence et avec une reprogrammation, il pourrait sortir les valeurs aux normes). Une rafale sort quand il y a une certaine stabilité du vent sur plusieurs échantillons d'après un algorithme. Il n'a pas pu me dire sur combien d'échantillons la stabilité doit être vue. Le pas de mesure est donc variable en attente d'une certaine stabilité (donc d'après moi, le pas est d'autant plus long que le site est turbulent avec des variations de la vitesse du vent en peu de temps vu que c'est la condition). La rafale maxi prend en compte les 20 plus fortes rafales dans les 2 dernières minutes (donc pas celles pendant les 8 minutes où elle dort). 450 km/h atteint en soufflerie, à 135 km/h seulement 1 km/h d'écart avec la soufflerie (donc même vitesse que soufflerie avec son incertitude aussi). Quand il y a une fiente ou autres, le capteur le remarque et tient compte de la nouvelle pression pour le zéro (A voir avec la pression de la pluie forte). Il y a un bruit de fond qui ne permet pas d'être certain de la vitesse à moins de 3-4 km/h. Le pluvio n'a pas de pièces mobiles, c'est un système de syphon. Il faut que ce n'est pas comme le premier pluvio Davis à syphon lamentable du début des années 90, qui me faisait rêver d'un futur pluvio à augets. Pour la température c'est un SHT21 ( moins précis que le SHT31 chez Davis, lui même moins précis que le SHT35 et que le tout nouveau SHT85 (+- 0.1° sur une bonne partie de la gamme) remplaçant le SHT75) et chaque exemplaire est corrigé spécifiquement. La station envoie la moyenne des 10 valeurs dans les 2 dernières minutes, donc les tests d'abris sans sondes identique avec un échantillonnage équivalent à la Davis seront biaisés (les Tx seront lissées en plus d'être ratées de façon indépendante du lissage de la constante de temps, donc si la station sort souvent des valeurs identiques à la Davis, ce sera plutôt signe que l'abri lui-même surchauffe. Si cet abri est bon comme les autres abris normalisés, comme il l'indique, il devra sortir des Tx souvent plus froides que la Davis vu le sommeil de la station 8 mn et le lissage sur 2 minutes contre 10 s en permanence pour la Davis) Le plastique est biodégradable donc au bout de quelques années, des pièces sont à changer, mais elles ne sont pas chères, quelques dizaines d'euros. Une station est en test sur un mât géant de l'EDF avec un anémo tous les 10 m. L'EDF est satisfait d'après lui. Il verra avec le concepteur pour l'échantillonnage en fonction de l'autonomie et la possibilité de déporter l'anémo (il est détachable, mais il y a de l'électronique pour d'autres capteurs dans le cône avec la protection électrostatique/magnétique de l'électronique ailleurs) Je lui ai proposé de tester bénévolement la station. Je l'ai motivé en lui montrant le potentiel mondial s'il modifiait sa station pour la climato afin de devenir meilleur que Davis avec un anémo sans entretien et un pluvio sans pièces mobiles en plus de la capacité à transmettre dans les coins perdus pour un prix compétitif. Pour le réseau GSM je lui ai indiqué qu' il fallait une mémoire interne car ici je ne compte plus les coupures de réseau de tous les fournisseurs en même temps sur le seul mât capté, dans les situations extrêmes où il ne faut surtout pas rater un record, pendant les orages ou par temps calme pendant des pannes en amont, ou avec les bévues de techniciens sur le câblage du pylône... Vu les délais de réparation, une semaine de mémoire est un minimum, l'idéal serait au moins un mois pour les coins inaccessibles l'hiver. En fait avant les essais, sur le papier malgré que cette station soit très intéressante, pour IC, il manque une mémoire, une alim suffisante avec un échantillonnage permanent (100% du temps) et assez aux normes comme les stations MF et Davis. -

Très intéressant ! Cependant ça peut-être largement le hasard de la météo /climato de ces périodes, car vu le peu d'échantillons, il n'y a absolument rien de statistiquement significatif (sans avoir besoin de le calculer tellement c'est trop faible . Ca ne veut pas dire qu'il n'y a rien, mais là faute d'échantillons, trancher dans ce sens serait justement se remettre totalement au hasard capable de produire bien pires coïncidences dans l'IC à 95% . ) et surtout pour une bonne raison, par le fait qu'il n'y a pas la comparaison du pyrano avec l'héliographe sur le même site avec les mêmes masques au même moment, mais avec des stations à distance. Et oui c'est un sacré problème vu que MF profite le plus souvent des modifications de capteurs, de normes, de classifications, pour améliorer les sites et l'emplacement pour le paramètre concerné, donc dans le cas présent probablement en évitant plus de masques qu'à l'époque de l'installation des héliographes Cimel. C'était pareil pour la T ces dernières années. Dans le Var en remplaçant les abris Cimel par des abris Socrima, MF a effectué de petits déplacements ou des élagages, déboisements, ou autres, pour de bien meilleurs dégagements. Donc celui qui pratiquerait ton analyse à distance sans avoir tous les éléments de modification du site et de l'emplacement de l'abri, de la station, trouvera aussi un changement dans la température en plus de celle due au meilleur abri. Donc sans informations sur l'emplacement exact des différents pyrano par rapport aux héliographes Cimel dans un même site, ni sur le déplacement ou non du capteur, les modifications dans le site et autour pour les masques (élagage d'arbres, déplacement de poteaux ou autres bricoles plus ou moins importantes), il vaut mieux se fier aux comparaisons avec les pyrano et les héliographes dans un même site. MF a réalisé des comparaisons en double sur certains sites du Nord autres qu'à Trappes, comme à Strasbourg (sous-estimation faible du pyrano, donc pourquoi l'inverse dans tes stations ?) et eux seuls pourront valider que c'est bien le pyrano qui est en cause dans tes stations, du moins fautes d'échantillons suffisants pour exclure le hasard. Il faudrait voir si MF a effectué des mesures en double à Besançon où les écarts entre l'ancien Campbell et le Cimel avaient été les plus importants et donc c'est là que potentiellement le pyrano est sensé être le plus mauvais par rapport au Cimel ou pyrhéliomètre.

-

5 à 10% mais sur quel pas de temps ? Je n'ai pas vu ça dans la doc des essais MF avec les comparaisons réalisées pour la mise au point de la méthode, ni pour son acceptation à l'OMM avant d'introduire la méthode du pyrano la plus précise, inventée par MF (Oliviéri). Il ne faut pas mélanger des écarts donnés pour une journée et les écarts au mois et encore moins à l'année, sur des normales, ça n'a pas de sens. Avec ces + 5 à +10% avancés ici, si c'était à l'année et pire aux normales, autant rester au Campbell ! Avec la méthode du pyrano, MF a relevé -0.6% sur le cumul pendant 8 ans à Carpentras par rapport à la mesure de référence la plus précise, donnée par le pyrhéliomètre. Sur un an à Strasbourg/héliographe Cimel on a -1.36%, -1.06% à Montpellier sur 4.5 ans, +0.09% à Trappes sur 9 mois sans mois d'été, +0.44% sur 4 ans à Tours, -0.11% à Ajaccio sur 6 mois, +0.06% à Faaa sur 2 ans, -0.3% à Gillot sur 2 ans. MF indique dans cette note que la méthode a tendance à sous estimer en général la DI d'un peu moins de 1% sur de longues périodes. Et depuis ces essais la méthode a été améliorée pour l'OMM car MF et autres spécialistes ont affiné le calcul des coeff spécifiques à la station. Dans les stations les plus récentes on peut programmer des formules plus complexes et celles d'analyses du signal pyranomètrique les jours d'insolation intermittente et déterminer le trouble atmosphérique avec d'autres paramètres, pour améliorer la précision journalière. Dans les publications internationales sur le sujet, ces résultats sont régulièrement rappelés : L'amélioration des coeff pour Carpentras a entrainé une erreur de +1h sur 11012h (sur 2007-2010) mesurées par la référence, 0.00% d'erreur. Il suffit de regarder les tableaux des écarts pour différentes villes, pour voir que l'erreur minime au pas annuel, sera encore plus négligeable pour déterminer des normales de DI. https://www.wmo.int/pages/prog/www/IMOP/publications/IOM-109_TECO-2012/Session1/O1_07_Vuerich_Sunshine_Duration.pdf Il faut bien comprendre que des erreurs non systématiques non négligeables au pas journalier, se compensent et sont négligeables pour des années et encore plus pour des normales. Après c'est clair que plus on sera au Nord de l'Europe et plus ce sera compliqué l'hiver avec un soleil rasant tout le temps. Dans le chapitre 8 de la bible de l'OMM, "Measurement of sunshine duration"

-

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Oui j'avais bien lu pour CMIP5 que plus on injectait de paramètres, plus mais aussi moins compris/mesurés, et plus l'IC devenait important à l'image de cet exemple, (mais à voir pour la valeur centrale meilleure sur le passé dans CMIP5) : extrait d'ici : http://www.insu.cnrs.fr/files/plaquette_missterre.pdf Mais bon vu que pour ces modèles le problème principal reste les nuages (qui représentent 70% de la dispersion entre les modèles sur la sensibilité climatique, http://documents.irevues.inist.fr/bitstream/handle/2042/56362/meteo_2015_88_56.pdf ), donc ça voudrait dire de fait que les nuages auraient été mieux estimés dans CMIP3 et que c'est CMIP5 qui le dit (pour Cotissois) tout étant moins bon sur ce point (vu que s'il était meilleur pour les nuages, il le serait aussi par rapport à CMIP3). Ca n'a pourtant pas l'air d'être le cas d'après vos discussions sur les nuages et l'embryon de CMIP6. -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Je ne comprends pas comment des modèles plus récents avec des ordi plus puissants, sont moins bons (pour prévoir le fond, l'évolution de moyennes sur 20-30 ans et non pas la variabilité interne) tout en confirmant que les anciens sont meilleurs. Car si les derniers sont moins bons, ce qu'ils confirment n'est pas sensé être meilleur vu que par définition en étant moins bons, leur capacité à capter le meilleur est douteuse et donc ils ne pourraient pas dire que CMIP3 est meilleur. Enfin c'est une histoire quelque peu circulaire vue d'ici. D'autant plus que pour le moment avec les obs on ne peut pas savoir s'ils sont meilleurs, car ça ne veut rien dire avec si peu de données depuis CMIP3 et 5, que les obs soient plus proches de CMIP3 que de CMIP5 (surtout que RCP 8.5 et 4.5 ne sont pas différents sur cette période, j'ai regardé, la valeur centrale renvoie le même écart avec les obs et que CMIP3 reproduit moins bien les obs passées). Donc vu d'ici je ne vois pas comment en voyant plus mal le passé (sur le fond) que CMIP5, en disant que CMIP 5 est moins bon, on en arrive à la conclusion que CMIP5 confirme que CMIP3 est meilleur. -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Même le graphe d'un sceptique qui publie régulièrement chez Watts, montre comme les pentes les plus récentes des anomalies et du cycle solaire, sont inversées : Avec cette cueillette de cerises, certains vont finir par nous dire que plus le soleil faiblit et plus la T globale monte : C'est mieux avec l'ensemble : Les obs sont compatibles avec ce que nous dit la physique. L'influence du cycle solaire est tellement faible pour le fond qu'elle est noyée dans le bruit (Dixit Leif Svalgaard ) : Il y a comme une différence avec ce qui est sensé avoir une influence sur le fond : Il n'y a pas de tendance de fond dans l'activité du soleil, elle est considérée comme nulle sur ces 300 dernières années comme le montre un des graphes de Leif Svalgaard : -

Médias, exagération, désinformations sur la météo

ChristianP a répondu à un sujet de Ventdautan dans Météo, environnement et société

Une "erreur" habituelle en climato de Fred Decker qui a pourtant été informé x fois de l'existence des séries homogénéisées et où elles se trouvent : Une normale n'est pas prévue pour le suivi de l'évolution du climat, c'est indiqué quelque part dans un des manuels à l'OMM, car les données ne sont pas homogénéisées. Avec des données homogénéisées : Pour la suite après 2013, je ne sais pas si cette série avec 2018 est homogénéisée : https://www.ncdc.noaa.gov/cag/city/time-series/USW00094846/tavg/12/12/1958-2018?base_prd=true&firstbaseyear=1958&lastbaseyear=2018&trend=true&trend_base=10&firsttrendyear=1958&lasttrendyear=2018&filter=true&filterType=loess -

Tamino avait traité ce papier à l'époque. Je me rappelle bien qu'il disait dans son blog que la très grande majorité de ces tendances ne sont pas significatives. Elles sont trop courtes pour la variabilité donnée. On ne peut pas tenir compte de ces tendances car le signal hivernal sur une durée suffisante est statistiquement significatif de l'inverse, d'un réchauffement (S'il avait été significatif d'un refroidissement de l'hiver avant ces tendances trop courtes, il aurait été juste de déduire que le signal n'a probablement pas changé, mais là c'est tout l'inverse). Il n'y a que dans cette science que certains perdent leur temps à publier des papiers basés sur ce qui n'est pas significatif, sur du bruit et pire, le compare à celui encore imprévisible par les modèles inaptes pour l'échelle interne même au niveau global moins compliqué (Ca n'a pas de sens avec une telle sous-estimation de la variabilité interne par les modèles faits pour la prévis climatique (de moyenne/30 ans et tendances /50-60 ans environ) et pas encore bons pour le bruit interne : https://pbs.twimg.com/media/DyitheTWkAAgZxk.jpg https://twitter.com/Knutti_ETH/status/1092315944519720960 ) Pour voir l'évolution des hivers à cause de la variabilité hivernale (qui en prime a peut-être augmenté d'après un post récent de Tamino https://tamino.wordpress.com/2019/01/31/global-warmings-wild-winter-in-the-usa/ ) , il faut tirer des tendances assez longues, sinon ce sera toujours le même problème d'interprétation non scientifique et la noyade de plus en plus habituelle de certains dans le bruit. Sous ces latitudes, le réchauffement des extrêmes de froid y est 2 à 5 fois plus fort que le RC moyen, donc pas top pour des hivers qui se refroidiraient. Non seulement il y a significativement moins de vagues de froid, mais en plus elles sont moins étendues et moins puissantes (ce qui n’empêche pas de battre des records ici ou là, vu les séries de T journalières bien trop courtes pour que ça n'arrive plus. Il faudrait des milliers d'années de climat stable pour obtenir des records de froids significatifs de ce que peut faire la météo pour l'état moyen donné malgré le RC actuel.) https://pbs.twimg.com/media/DyKuG2HXQAAmpRo.jpg https://twitter.com/gjvoldenborgh/status/1090625499892772865 https://pbs.twimg.com/media/DyaFYQ6X0AEuUjt.jpg https://twitter.com/gjvoldenborgh/status/1091706619346472960 Ce n'est clairement pas plus de froid l'hiver qui saute aux yeux, mais l'inverse : https://pbs.twimg.com/media/DyfDEzRWwAAah09.jpg https://pbs.twimg.com/media/DyfDFWGWoAEEOH0.jpg Il n'y a qu'un point de départ (1995) du calcul des tendances des vagues de froid, donc qu'une seule tendance, qui ne montre pas de diminution des VDF mais qu'en apparence uniquement, car là aussi pas significative. https://pbs.twimg.com/media/DyfDF4mWsAE66yq.jpg https://twitter.com/gjvoldenborgh/status/1092055951266496512 Aucune tendance calculée après 1985 environ n'est significative. L'agitation des tendances centrales selon les années quand elles deviennent plus courtes et surtout non significatives, est habituelle pour la plupart des paramètres. C'est le bruit qui prend la main sur le fond, ce sont des variations qui n'ont très probablement pas de sens (confiance à 95%) . On ne peut revendiquer une tendance au refroidissement de l'hiver ou une augmentation des VDF sous ces latitudes avec des tendances qui n'ont aucun sens (c'est pire que prendre son doigt mouillé car là on a clairement des tendances significatives avant qui montrent l'inverse.) : On peut voir qu'un certain niveau de froid observé il y a quelques jours aux US, avait une durée de retour d'environ 20 ans en 1900, avec le RC c'est pratiquement 150 ans : https://pbs.twimg.com/media/DyKu04hX0AMRm2K.jpg https://twitter.com/gjvoldenborgh/status/1090626290024173568 https://pbs.twimg.com/media/DyQJGzEWoAAk09V.jpg https://twitter.com/ClimateOfGavin/status/1091007104691912705 Au niveau global en dehors de vouloir cueillir des cerises pour extraire un point bleu ou pour tirer des tendances trop courtes d'évolution de VDF et faire dire aux tendances non significatives ce qu'elles ne disent pas, c'est pareil : "And a global view of the trend in daily temperature extremes around the world compared to the global warming signal shows that extreme lows are warming FASTER than the overall global warming signal. So extreme cold waves are weakening quickly" https://cliffmass.blogspot.com/2019/01/are-cold-waves-increasing-under-global_30.html https://www.worldweatherattribution.org/trends-in-weather-extremes-february-2018/ Il n'y a rien de significatif dans les données qui montre un refroidissement des hivers (ou plus de VDF, ou plus d'extrêmes de froids) sous ces latitudes, c'est tout le contraire, car tout ce qui est significatif affiche un réchauffement hivernal à tous niveaux et surtout des VDF et des extrêmes en durée, en fréquence et en étendue.

-

Transfert des données via logiciel Weatherlink v6 : limité ?

ChristianP a répondu à un sujet de Damien49 dans Instrumentation

Je ne comprends pas bien la question, car je ne connais pas de limite de 3 mois (hors celle de la mémoire interface selon le pas de temps choisi). La base de données de Weatherlink est limitée à 25 ans par station. Il faut créer une 2 ème station (pour une nouvelle base de données qui assurera la continuité) avant la fin des 25 ans pour ne pas perdre les données nouvelles arrivant juste après 25 ans. J'avais fouillé le sujet vu que ça m'est arrivé l'année dernière de ne plus pouvoir récupérer les nouvelles données (C'est indépendant des versions. Ma base de données de 25 ans a connu toutes les versions, dont celle à l'origine sous DOS jusqu'à la version 6). -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Pour le moment je n'ai pas le RCP8.5 en stock, j'ai que tout CMIP3 : Réchauffement moyenne/30 ans CMIP3 fin 2018 /1850-1900 : 0.903° (Observations de Berkeley : 0.907°) Pour le Loess/50 ans : 1.22° (Berkeley 1.20°) Graphe avec quelques séries et ERA5 : https://pbs.twimg.com/media/DybH-_cVsAY3hnz.jpg https://twitter.com/hausfath/status/1091779851512508416 -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Où en est le réchauffement climatique global avec la série de Berkeley fin 2018 ? https://pbs.twimg.com/media/DxsOMXbU8AUDzH-.jpg https://pbs.twimg.com/media/DxsGzrpWoAEw42U.jpg https://pbs.twimg.com/media/Dxr9F1xX0AAX7Nz.jpg La moyenne climatique sur 30 ans de 1989-2018 est plus chaude de 0.91° que celle de référence préindustrielle du GIEC sur 1850-1900. Les modèles du GIEC pour le scénario RCP 4.5 (représentatif de la moyenne de tous les scénarios pour encore un bon moment. L'explorateur de données ne fournit pas sans trop gros travail perso, à l'inverse pour les modèles de l'AR4, une simple série de la moyenne de tous les modèles de tous les scénarios) de l'AR5 donnent une prévision de 0.93° de la moyenne/30 ans fin 2018. Donc 0.02° de différence, c'est très correct pour le moment (Il faudrait une différence d'environ plus de 0.08° pour que ce ne le soit plus) Le loess/50 ans des obs a une tendance en retard. Il affiche 1.20° de réchauffement pour 1.31° pour le loess/50 ans des modèles, ce qui est logique avec le bruit passé (celui du faux hiatus/palier interne et non climatique, qui influence plus la tendance et donc le bout du Loess, mais bien moins la moyenne climatique. Un bruit chaud devrait finir par compenser le bruit moins chaud du hiatus interne (un surplus d'ENSO+ après le surplus d'ENSO- pendant le hiatus) Avec la dernière méthode du GIEC 2018 qui utilise la dernière moyenne/10 ans pour estimer une moyenne/30 ans à cause de la tendance de fond significative, on a 1.10° de réchauffement pour 1.18° prévu fin 2018 par les modèles. Pour la méthode habituelle du GIEC, la tendance linéaire sur 1850-2018 donne un RC de 1.09°. Celle jusqu'à fin 98 était de 0.76°. 0.34° de RC depuis fin 98 (Significatif). Si on prend une autre méthode de l'AR5, la moyenne des 20 dernières années 1999-2018 par rapport celle 1979-1998, le réchauffement est de 0.38° (Significatif). https://pbs.twimg.com/media/DyAyBVXUwAAK6DL.jpg https://pbs.twimg.com/media/DyFbjpHXcAAllzH.jpg https://pbs.twimg.com/media/DxsKdiDXcAUdVOG.jpg https://twitter.com/hausfath/status/1089926618452176897 https://twitter.com/chriscmooney/status/1088475285224329216 -

Emplacement abri stevenson et stations

ChristianP a répondu à un sujet de Jean-Mi dans Instrumentation

Si ces courbes sont relevées avec deux abris Davis (ou deux abris MF) et des sondes strictement identiques et étalonnées l'une sur l'autre et que les positions ont été inversées (le plus haut à la place du plus bas pour constater que l' influence de la hauteur plus grande (plus basse) est bien identique aux 2 emplacements), ça démontre que l'emplacement de l'abri est insuffisant (ou que la végétation courte n'est pas correcte), car on ne relève pas de tels écarts dans un assez bon site pour cette différence de hauteur (ça été démontré aussi par les essais MF). Récolter un faible écart pour cette différence de hauteur, c'est un très bon moyen objectif de vérifier la qualité de l'emplacement de son abri. Ce sont des écarts que je relevais dans ma classe 4 entre des abris Davis avec 50 cm de différence de hauteur, qui ne s'observent pas en classe 2. Le fait que l'écart de Tn ne soit pas différent rend douteux l'étalonnage et/ou une utilisation d'abris différents ou moins bons (ou un des abris), une différence de réactivité des capteurs, car la différence dans un mauvais site est plus faible en Tn qu'en Tx estivale sauf en cas de vent qui se lève vers le moment des Tn (une est plus haute sur l'abri touché par le vent et pas dans l'autre plus abrité avec l'air moins mobile en fin de nuit radiative). Sans matériel identique et bien étalonné, on ne peut pas déterminer ce genre d'écart et l'attribuer totalement à la différence de hauteur, de plus dans un site pas assez assez dégagé ou avec de la végétation courte trop haute, il faut inverser la hauteur des abris, pour vérifier l'écart dû à la différence de position des abris dans le site insuffisant. Sinon même avis qu'Adri pour la zone 4 et la hauteur d'installation dans ce site. L'abri a besoin de respirer à 2.5 m et d'éviter la surchauffe du site l'été (et éviter des Tx trop froides l'hiver) du sol abrité ( si ombragé l'hiver). -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

Pour "tes" valeurs en "2035", d'après le document, ce sont les médianes des scénarios pour des moyennes/30 ans sur 2021-2050, celles connues en 2050 et non en 2035 valeurs centrées connues qu'en 2050 (ou alors éventuellement tu peux nous dire en 2040 avec la méthode du GIEC, on estime celle sur 30 ans à partir de la moyenne /10 ans connue fin 2040) 1 : 25% ;75%. L'IC plus large que "tes" valeurs médianes est de 50%, qui reste ridicule, car 50% des modèles donnent des valeurs qui sont hors des bornes [0.3°; 2° ], donc c'est quand même très loin de l'IC à 95% et très loin d'être moins probable d'observer une moyenne/30 ans en dehors des médianes, mais aussi d'un IC à 50%. On a autant de proba de relever une valeur dans l'IC qu'en dehors, donc ton histoire de majoritaire pour des valeurs de 0.6° à 1.3°, ça ne tient pas du tout la route car ça ne l'est déjà pas de 0.3° à 2° ! Diffuser dans le document un tel IC réduit, démontre que les pro ont conscience des limites de ces modèles à l'échelle minuscule de la France et donc qu'ils ne font très probablement pas aussi bien pour situer le signal de fond qu'au niveau global avec un IC courant à 90%. En fait le signal observé (du moins celui estimé des obs par diverses méthodes, car imparfaitement connu surtout vers le bout en 2018) est au-delà de cet IC de 50%, mais il reste largement dans le domaine du probable aussi pour les modèles, car le loess/60 ans est à la limite de l'IC à 66% (17%, 83%) du graphe suivant, plus large que l'IC à 50% pour les moyennes sur 30 ans (ce qui n'est pas le cas pour les courbes du graphe). J'ai ajouté le morceau de loess/60 ans calculé depuis 1900 (d'après les anomalies MF recalées /1976-2005) pour la période sur 70-2018 dans ce graphe des projections pour la France (Anomalies annuelles MF jusqu'en 2014) : Récupéré ici : http://www.meteo.fr/meteonet/temps/clim/ClimatHD/ressources/fiches/FUTUR_REG_TEMPE_FPROD.pdf Ce loess d'échelle climatique est loin d'être du bruit et il est contaminé par une partie d'un vrai palier climatique d'avant 70, donc du "froid" relativement au fond. La tendance linéaire un peu plus forte depuis 70 est plus proche de celle climatique sur 60 ans que d'un bruit interne de court terme ( Car ça fait quand même 49 ans de fort réchauffement sans changement significatif). Il n'y a rien dans ces modèles qui indique qu'il y a plus de proba d'observer un bruit "froid" (moins chaud) qui continuerait (celui en cours depuis 97) , ou à venir, plutôt qu'un bruit chaud ou équivalent à l'actuel depuis 70. L'écart est plus profond qu'un problème de niveau de bruit et de timing interne, vu les obs qui ne montrent pas la même situation que pour l'écart constaté au niveau global qui s'analyse avec les stats comme étant très probablement dû au bruit (on devrait-être dessous les valeurs centrales et non au-dessus s'il n'y avait pas de problème de fond des modèles sur la France, comme pour le global, car on sort d'un bruit "froid" (moins chaud) et la logique veut qu'on retrouve un bruit chaud ou au minimum la tendance de fond). Il faut voir que le bruit le moins chaud sur la France depuis 70 existe déjà depuis 1997, car on y relève la plus faible tendance un peu longue qui n'est pas significativement différente de zéro, 0,22°/déc depuis 97, mais les obs montrent que ça repart à la hausse ensuite et l'augmentation de la moyenne/30 ans est de 0.53° depuis leur moyenne de référence, donc depuis début 2006 (soit déjà pratiquement tes 0.6° de la médiane basse attendue qu'en 2050 ! Et plus que les 0.3° de l'IC bas à 50%), soit une tendance effective de 0.4°/déc sans incertitude du modèle linéaire ( pour 0.68°/déc en modèle linéaire depuis 2006, pas différente avec son incertitude large, de celle "nulle" à 0.22°/déc depuis 97) parfaitement conforme à celle longue sur le fond observée depuis 70 de 0.4°/déc. Donc je ne vois pas ni dans les obs, ni dans les modèles une proba supérieure de bruit "froid" qui devrait se poursuivre ou à venir, au contraire avec les obs, il y a un rattrapage en cours que ce soit pour le Loess ou pour la tendance faiblarde "nulle" depuis 97. La proba est supérieure pour que la tendance depuis 97 et le Loess/60 ans se redressent encore, sinon ce serait revendiquer de fait un prochain vrai palier d'échelle climatique (/30 ans au moins) qui n'est pas attendu dans les modèles sur la France. Un tel palier comme par le passé se percevrait déjà comme dans les obs au niveau global quand ce fut le cas. Si le bruit moins chaud continuait encore au minimum 8 ans en France, la tendance depuis 97 deviendrait différente de celle d'avant 97 et donc significative d'un changement pour le climat , d'un palier climatique en France, ce qui est absent des modèles et très peu probable avec les obs et les stats vu le RC de fond. Ne pas oublier que les modèles qui sont meilleurs au niveau global fournis avec un IC plus correct se sont plantés (du moins l'interprétation des physiciens qui s'évertuent à les utiliser dans un domaine pour lequel ils ne sont pas encore bien faits : pour prévoir le bon niveau avec le bon timing et la bonne fréquence des bruits internes !) sur le faux hiatus. Il n'y avait que 2% de proba d'observer ce faux hiatus dans les modèles, alors qu'on n'était pas loin de 50% de proba en utilisant les obs+stats ( donc pas loin du maxi des possibilités avec les obs et les stats) pour la durée du faux hiatus d'être observé (sans un puissant Nino plus tôt, qui de fait discrimine à lui seul les durées de paliers internes par rapport aux records significatifs (>=0.1°) avec le signal de fond actuel depuis 70), car parfaitement conforme pour la tendance centrale depuis 98 pour les stats basées sur les obs. Je n'ai pas vu passer que les modèles même pour l'échelle globale "plus simple" à prévoir, sont devenus capables de prévoir le bruit interne. A ma connaissance, ils sont toujours inaptes pour placer correctement 3, 5, 10, 15, 20 ans en avance dans un échantillon de climat, les plus forts Nino qui sont les seuls à pouvoir avancer ou retarder la fin d'un palier interne ou de record battu significativement d'au moins 0.1° (pour la tendance de fond donnée sans changement significatif), ce qui est bien moins compliqué que pour prévoir une fin de palier interne ou de nouveau record significatif sur la France, car il n'y a pas qu'un paramètre aussi déterminant qui joue autant sur la T annuelle et les paliers internes en France. Donc le problème hors période de scénarios plus discriminants après 2050, est de parvenir à prévoir le fond plus précisément à l'échelle minuscule de la France. Avec le RC de fond, donc à cause de la tendance de fond significative, les données ne sont vraiment pas assez i.i.d pour faire une fixette sur le centre d'une moyenne classique, qui n'est pas assez pertinente, donc il faut faire quelque chose pour estimer plus correctement la toute dernière moyenne et le niveau du bout du signal d'échelle climatique. Le GIEC (voire MF, à vérifier avec les 1.4°de RC trouvés) prend donc la liberté d'estimer une moyenne/30 ans par la dernière moyenne/10 ans (ce qui serait une grosse erreur sans tendance significative) en plus d' autres méthodes comme : Le traitement du bruit. Ils le déterminent et le retirent pour estimer le signal de fond le plus probable jusqu'à nos jours. Ils calculent le dernier RC de fond avec différentes tendances linéaires totales et regardent l'évolution à différentes périodes. Ils intègrent les forçages comme pour le GWI. Dans mon cas pour la France, j'utilise le loess/60 ans qui a l'avantage de suivre de près les moyennes/30 ans sans capter leur micro bruit inutile pour l'échelle climatique tout en allant au bout de la période, en respectant les changements significatifs de tendance linéaire, tout en regardant aussi ceux /30 ans, /15 ans, /10 ans, le loess auto, l'évolution des moyennes/30 ans et les points de changements significatifs de tendances linéaires, pour voir la cohérence et ne pas être contaminé par le bruit et/ou des artéfacts visuels/statistiques fréquents avec les lissages et des pentes linéaires non significatives. Pour bouger le loess/60 ans à la baisse d'ici 2050 pour rejoindre les 0.3°/déc de fond des modèles, il faudra obligatoirement un palier climatique pas vu par les modèles sur la France, d'où l'improbabilité que ça arrive et la probabilité que les modèles ne cernent pas bien le fond (là le Loess/60 ans devrait être un peu sous la valeur centrale les modèles, comme au global, si c'était une simple question de bruit, vu que celui moins chaud on l'a déjà eu sur la France aussi). -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

Le loess/60 ans, c'est une tendance plus une comparaison de deux moyennes/30 ans, on est à l'échelle climatique donc je ne comprends pas pourquoi il faudrait centrer sur 2018 comme si nous avions du bruit interne qui jouait. C'est le fond climatique qui est important pour cette pente, donc il n'y a rien dans le bruit futur d'échelle interne, hors catastrophe qui pourrait bouger la pente et la faire ralentir à 0.27°-0.3°/déc alors qu'elle contient déjà un vrai palier climatique d'avant 1970 qui minimise déjà sa pente. Le faux hiatus global a déjà impacté la France et les modèles sont incapables de trouver le bon timing de ce genre de bruit interne déjà au niveau global alors à l'échelle de la France, c'est encore plus incertain pour eux de bien le situer et de le quantifier à l'avance. En fait en regardant de près le dernier rapport du GIEC sur la limite de 1.5°, pour les 1.4° de RC pour MF fin 2017, je pense que MF utilise peut-être une des dernières méthodes du GIEC qui prend une dernière moyenne/10 ans comme une estimation d'une moyenne/30 ans centrée sur cette période plus courte (donc la moyenne 2008-2017 serait dans ce cas considérée comme la moyenne/30 ans de 1998-2027 ce qui dans ce cas donne bien 1.4° de RC fin 2017) A noter que maintenant ils utilisent une moyenne de 4 séries et non plus seulement Hadley : Voir en particulier les pages 57, 58, (59 où ils analysent aussi des moyennes climatiques "débruitées", 1.04° de RC fin 2017 dans la figure 1.2 page 57. Voir tableau 1.1 avec différentes périodes de suivi du RC et les écarts entre les séries) : https://www.ipcc.ch/site/assets/uploads/sites/2/2018/11/SR15_Chapter1_Low_Res.pdf -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

Je ne comprends pas du tout pas pourquoi tu restes à l'époque de l'AR4 et que tu bloques en 2000 la valeur officielle de la France et même celle du GIEC. Le GIEC a mis à jour régulièrement le calcul officiel du RC après ton graphe tout comme MF. Sur HD climat on trouve ça avec un graphe terminé fin 2017 : Conforme à l'AR5 (mais pas pour les 1.4° mystérieux sur la France sur 1900-2017) : 1.34° sur la France sur 1901-2012 avec la même méthode à partir des anomalies MF plus précises du graphe des anomalies du panel MF sur HD climat (1.34° aussi avec ma série). Il n'y a aucune indication sur la façon de trouver leurs 1.4° en tendance moyenne de RC sur la France fin 2017. Ca ne correspond à rien en tendance ici. La tendance centrale sur 1900-2018 est 1.58° pour ma série reconstituée, 1.57° pour la leur avec des anomalies plus précises. Même sur 1901-2018 qui dégage de fait une donnée "chaude", elle est de 1.61° pour les 2 séries. Sur 1900-2017 c'est 1.50° de RC (1.51° pour ma série). De plus les 2.7°/siècle sur la France, c'est pratiquement la tendance centrale faiblarde (2.76°/siècle) trop courte pour qu'elle soit significative, observée sur 2000-2018. Si on prend la pente sur une échelle climatique qui justement est peu sensible au bruit, celle du loess /60 ans pour la période sans changement significatif de tendance linéaire avec les données d'anomalies sur 70-2018, elle est de 3.6° /siècle pendant que la tendance linéaire sur la même période à partir des anomalies est de 4° (3.96°)/siècle. Logique que la linéaire soit plus pentue que le loess/60 ans avec aucune donnée d'avant le changement significatif de tendance dans le calcul à l'inverse du loess/60 ans qui récupère des données d'avant 70 dans le calcul (donc de fait avec des données du vrai plateau climatique dans le calcul de la pente du loess/60 ans depuis 70 ). Plus le temps passe et plus la pente de ce loess/60 ans s'aligne sur la pente linéaire depuis 70, plus forte que celle du Loess, malgré une tendance plus faible en apparence ces dernières années (2000-2018) car la tendance sur 70-1999 a donné 4.6°/siècle (plus forte qu'en apparence). La pente du Loess/60 ans restera probablement plus faiblarde que la linéaire depuis 70, jusque vers 2030 (donc au bout des 60 ans sans nouveau changement significatif de tendance). Donc il est fort probable que le RC sur la France devienne plus fort que ce qu'indique déjà le Loess/60 ans actuellement et voire la linéaire depuis 70 vu que le RC est aussi sensé s'accélérer d'autant plus avec tous les schizophrènes profonds dans les plus inquiets qui s'acharnent de fait à alimenter la chaudière toujours plus. De plus en début d'année dernière dans un de mes posts en comparant le loess/60 ans pour la T globale à la méthode GIEC du GWI pour suivre le RC, qui prend les forçages en compte, on a vu que le Loess/60 ans est moins pentu que leur estimation du RC, donc il est plus que probable que le RC est plus fort aussi sur la France que ne l'indique ce Loess/60 ans. Ca ne dit rien pour les prévis très lointaines, surtout avec le facteur d'incertitude principal (pas tant que ça quand on regarde de près l'histoire) qui est le comportement humain plus que très largement capable d'auto réduire très massivement sa propre population par les guerres civiles et militaires ( et donc de fait ses émissions), bien plus et avant que le RC soit capable d'en faire autant... Une animation sympa : https://twitter.com/neilrkaye/status/1081192550826950657 -

Statistiques et anomalies climatiques nationales

ChristianP a répondu à un sujet de Aldébaran dans Evolution du climat

RC depuis 1900 +1.58° selon une des méthodes du GIEC en prenant la tendance moyenne depuis 1900, +1.33° / normale 1900-1929. -

Canicule : d'ici 2050, des températures records de l'ordre de 55 degrés en France ?

ChristianP a répondu à un sujet de Ventdautan dans Evolution du climat

J'avais commencé à répondre au mois d'août sur ce sujet qui rejoint le même problème sur les valeurs extrêmes à 50° et + avec le RC prévu. Un record absolu de Tx battu ou pas, n'a aucun sens sans savoir ce que représente un peu le record précédent à battre (d'autant plus à l'intérieur des terres ou pire vers les pôles où la variabilité est plus grande). Pour avoir une idée un peu plus juste du record potentiel et significatif réellement d'un état climatique stable donné et pire d'un climat avec une tendance de fond au RC, il faut énormément plus de données que les séries "modernes" de durée nanométrique pour cet usage, et qui en prime ne sont pas homogènes et toujours impossibles à corriger correctement au pas journalier surtout pour un record. Par exemple, le record de Paris de 1947 avec l'ancien abri Montsouris qui surchauffe surtout en Tx estivale par beau temps et vent faible (écart médian + 2° pour ces cas jusqu'à +3.5° mais pendant un an d'essais à Trappes avec un été pas folichon dans le coin sans aucun rapport avec 2003 et les étés banals dans le SE) avec en prime ensuite l'arrosage moderne du parc (-0.5° d'écart moyen en Tx estivales) fait que le record moderne recalé à la louche aux normes passées de 1947 donnerait probablement en valeur estimée autour de 42.5° ( 2° pour l'abri et 1° pour l'arrosage auto, car -0.5° de moyenne en Tx, est donné pour toutes conditions confondues, y compris avec les jours pluvieux et nuageux.) Pour voir la possibilité de 50° et plus en France après 2050, autour de 2075 ou plus ( Attention c'est surtout pour après 2050 et non en 2050, une année particulière, notre ami de Futura science, explique ces détails : https://www.futura-sciences.com/planete/actualites/climatologie-records-temperature-plus-50-c-france-61662/ ) , Voyons avec un exemple pour le record absolu moderne remarquable du Luc du 7 juillet 82 avec 42.7° toujours pas battu malgré le net RC supplémentaire depuis 82 : On remarque sur le graphe, que ce vieux record dans un bon site relevé aux normes actuelles (en prime avec beaucoup de vent ce jour-là soufflant de la direction hyper dégagée de cette station qui fait que cette valeur est très probablement équivalente à celle relevée dans un abri méca de haute qualité, un record qui vaut probablement plus de 45° dans des stations aux mêmes normes de mauvaises qualités que les 44.1° de Conqueyrac (avec abri Cimel surchauffant + cloisonnée pour le vent de terre + pente Sud trop forte, radiative) et St Christol les Alès (cloisonnée pratiquement dans toutes les directions, obstacles blancs rayonnants pour les Tx, serres proches, thermo à maxi et mini disposés contre la paroi Ouest de l'abri + thermographe douteux (donné à +-0.8° même si bien réglé), alors que personne n'est sensé chez MF continuer à vérifier l'étalonnage des thermographes de postes manuels depuis longtemps), est toujours nettement décalé de nos jours de la courbe de la significativité des records journalières. Tout record journalier n'atteignant pas ce niveau à 95% n'est pas encore assez significatif de la climatologie moyenne observée, d'autant plus avec une tendance significative, faute de recul et donc de milliers d'années de données journalières. Beaucoup de valeurs sont en retard par rapport à la moyenne des records et donc encore plus par rapport à ce qu'on est sensé observer dans 95% des cas quand on aura assez d'échantillons. Ce record de 1982 est toujours considéré comme très significatif aujourd'hui vu qu'aucune des valeurs plus récentes, n'a réussi à se décaler plus loin de l'IC supérieur que celle de 82. On peut voir de plus près en zoomant uniquement sur les Txx journalières que bien des records journaliers peuvent être très éloignés sur peu de jours. Quand on voit que pour le 9/07 le record est de 36.3° malgré le RC en plus depuis 82, alors que le record du 7/07 est de 42.7° sans ce RC, ça montre bien tout le problème du manque de milliers d'années de relevés pour obtenir des records cohérents/significatifs chaque jour pour un état moyen donné. Même si c'est moins prononcé au niveau annuel, c'est le même genre de problème qu'il faut avoir en tête pour se faire une idée d'un record absolu de Tx (ou Tn) potentiel vraiment assez significatif du maximum assez probable d'un état moyen donné. Donc même sans calculs élaborés de durée de retour, même sans recaler la courbe de significativité supérieure de l'IC, qui sera située plus bas fin 81 que sur ce graphique (vu qu'on retire un paquet de valeurs records et chaudes avec le RC depuis) où de nos jours il reste encore un surplus de 2.9° d'écart (39.8° pour le niveau à 95% le 7/07), une valeur équivalente à 82 donnerait probablement au meilleur moment thermique début août plus de 46° avec un bon mistral et vent d'Ouest (et donc plus avec un vent de terre résiduel faible ne permettant pas de dissiper le biais classique d'abri Stevenson/Socrima même dans ce très bon site dégagé). Ce n'est juste qu'une question d'échantillonnage de situations météo pour qu'on observe cette valeur de nos jours sans plus aucun RC supplémentaire ( ni plus rien du tout dans le pipeline). Si on utilise des méthodes plus pro pour le calcul des durées de retour extrêmes car la distribution des extrêmes n'est pas "Normale", avec la loi GEV et maximum de vraisemblance sur la base de la série de Txx annuelles, pas adaptée faute d'échantillons suffisants fin 1981, 42.7° était considérée pour cette loi comme impossible malgré que j'utilise les données qui ne sont pas claires d'avant 1959 et donc des 40° probablement pas propres et dopés qui sont présents, (J'ai vu les photo chez MF de l'ancien site qui est vraiment différent et bien moins bon que l'actuel, en 82) et qui ne sont d'ailleurs pas utilisées dans la série homogénéisée de Txm de MF qui débute qu'à partir de 1959 (au lieu de 1946). Donc malgré des valeurs probablement aux hormones dans le tas pour cette estimation, 42.3° en valeur centrale maxi possible (relativement aux capacités de ce paquet R, http://www.assessment.ucar.edu/toolkit/ et non à la réalité, vu que la durée de retour énorme, c'est considérer que la valeur est impossible) renvoyait en 81 une durée de retour de 10 millions d'années et l'IC à 95% de la valeur maxi sur une telle période faute d'échantillons suffisants, est important [38.8°, 45.8°] Même si on raisonne non plus en valeur centrale, mais en valeur limite d'IC à 95%, 42.7° en 81 c'était sensé être observé 2.5 fois en 100 périodes de 400 ans = 40 000 ans ( car la valeur centrale qui a une durée de retour de 400 ans en 81 = 41.0° IC à 95% [39.3 , 42.7] ) En 81 une durée de retour de 100 ans sur la base de la série de Txx annuelles disponible, renvoyait une Txx de : 40.4° [39.2°, 41.7°] . 41.3°[ 39.4, 43.3°] pour 1000 ans. On peut aussi se concentrer uniquement sur les Txx de l'été ou d'un mois avec la loi GEV, mais ça n'améliore pas encore assez l'estimation. C'est avec la loi GPD que l'estimation est plus réaliste, car on utilise la série des Tx dépassant un certain seuil pour récupérer le plus d'échantillons d'extrêmes, toutes celles en queues de distribution (dans le cas présent les Tx >= 35°), vu que parfois plusieurs fortes valeurs et donc des 40° ou autres, peuvent être relevées la même année et sont donc cette fois toutes prises en compte. En s'arrêtant à fin 81 : Fin 81 avec les données dispo, 42.7° [39.5° ; 45.9°] avait en valeur centrale une durée de retour de 3000 ans qui est passée à 70 ans selon la même loi avec le RC supplémentaire avec les données de 82 à fin 2017. La valeur équivalente à 42.7° en valeur centrale de nos jours avec la durée de retour de 3000 ans est de 46.5° [41,° ; 51.2°] pour l'analyse avec un seuil de la série d'extrêmes à 36° (ma sélection du seuil peut-être discutable, mais il faut trouver le juste milieu entre la récupération d'un nb suffisant d'échantillons, les indications des critères AIC et BIC, la tête de la courbe/ aux données et les proba renvoyées. Plus on recule le niveau de seuil et donc plus on utilise de données et moins on est dans la queue de distribution des extrêmes et moins la loi des extrêmes s'applique et plus les critères AIC et BIC se dégradent et plus les données extrêmes observées (ou futures même probables) deviennent faussement improbables. A l'inverse, moins on a de données en utilisant un seuil plus restrictif et plus les IC s'envolent, la valeur centrale et les bornes perdent de plus en plus de sens). En valeur limite d'IC, au lieu de 3000 ans en valeur centrale, la durée de retour de 46.5° est de 250 ans pour 44.0° en valeur centrale [41.5° ; 46.5°]. 43.1° en valeur centrale [ 41.2°, 44.9°] a encore une durée de retour de 100 ans de nos jours malgré le RC au Luc (42.2° en août 2017 nouveau record mensuel battant de 1.2° celui de 2003). Il faut bien voir qu'une durée de retour/valeur centrale c'est en moyenne et donc il existe obligatoirement de nombreuses périodes de 100 ans sans jamais observer cette valeur, mais bien moins, comme d'autres avec bien plus que la valeur centrale. C'est pour cette raison qu'il est très difficile de vraiment estimer un vrai maxi (ou mini) possible au regard des séries nanométriques actuelles pour l'objectif , même si on disposait de 150 ans de données journalières propres (c'est pour cette raison que ça n'a pas de sens de dire on a observé que 43°, donc c'est impossible 50° avec bien plus de RC). 30 échantillons de 100 ans, 3000 ans pour le pas journalier, c'est quand même bien mieux en stats plutôt que moins de 1 échantillon pour le Luc et bien d'autres stations, de plus non homogènes ! Il faut bien voir que ces IC sont aussi plus grands à cause du manque de centaines d'années de relevés pour récupérer assez de valeurs rares et non pas seulement parce qu'il est normal qu'il y ait un IC de valeurs probables pour chaque période de retour concernée (c'est pareil pour une tempête qu'on estime arriver 1 fois/ siècle, ce n'est qu'une moyenne, il y en a 0 de cette force dans plus de 1/3 des siècles et plusieurs dans un certains nombres de siècles, donc à notre échelle de vie réduite, difficile de savoir ce qu'est une véritable tempête du siècle !). Pour moi, vu que sans aucun RC supplémentaire, sans plus rien émettre, au Luc un 46.5° est bien possible car elle est même plus qu'équivalente à 42.7° de 1982 (il faut voir que le surplus de données a réduit les IC par rapport au calcul fin 1981, donc en réalité, c'est une valeur plus forte que 46.5°, que renverra l'IC sup, avec moins de données, comme en 1981) avec du RC puissant prévu en plus d'ici 2075, il ne fait aucun doute pour moi qu'on atteindra les 50° et plus dans l'intérieur de la France, mais quand, même si on stabilisait le RC de l'état moyen au niveau prévu en 2075, ça peut arriver dans la foulée, les années autour, comme dans 200 ou 300 ans et plus, pour un même RC . A ce niveau, pour l'année des 50° et plus, ce ne sera plus qu' une question d'échantillonnage aléatoire des conditions météo pour le réchauffement donné supplémentaire, car le bruit météo est capable de générer des situations très décalées de l'état moyen et on ne peut pas savoir quand malgré une prévision parfaite de l'état moyen, ni s'en rendre compte réellement avec nos séries si courtes pour l'échelle des records absolus. C'est bien pour cette raison que battre un record même de beaucoup ne veut rien dire tout comme ne pas le battre comme celui du Luc qui résiste, ne peut rien dire sur le RC ! Sauf si vous voulez vous noyer toujours un peu plus profondément dans le bruit 🙂 Pour le Luc si près assez près de la mer, c'est aussi plus compliqué de récupérer les bonnes conditions météo pour chiffrer, car il faut obligatoirement un vent de terre présent quand l'air le plus chaud résiste encore dans le SE, ce qui n'arrive pas souvent d'autant plus avec la dépression thermique dans cette cuvette qui contrarie souvent le vent résiduel de terre (vent d'Ouest et Mistral) qui permet ces records (A voir d'ailleurs si le RC ne va pas de plus en plus renforcer la dépression thermique dans ce coin et donc rendre encore plus rares les vents de terre résiduels à gros scores dans ce secteur l'été.) Si on analysait les données pour les 42.5° de 1983 de la station hyper dégagée dans cette direction de vent de l'aéro de Fréjus/St Raphaël , abri pourtant à quelques centaines de mètres du bord de mer, ça paraissait encore plus totalement impossible en 81 avec toutes les techniques imaginables. Même de nos jours ce n'est pas gagné de revoir cette valeur avec le RC ! C'est un sacré bon coup de la météo ! On ne peut estimer réellement avec l'intuition d'après les relevés observés, et à peine approcher avec les stats, les réelles possibilités de valeurs extrêmes avec des séries si courtes de Tx et si peu fiables dans le temps (avant 1950 voir 1959 pour celles du Luc et bien d'autres stations) et donc vu les modifications de l'occupation des sols d'ici 2075, du béton en plus, de la forêt probablement en moins dans le secteur, avec le RC en plus, il vaut mieux miser sur les modèles capables de pondre les situations météo et les valeurs associées possibles d'après les paramètres physiques. Depuis que je fais des calculs sur ces sujets, j'ai toujours vu des valeurs observées, pourtant données impossibles avec les stats avant de les observer, se produire. Alors celles données un peu probables avec les stats, ont des chances d'être garanties (sans pouvoir dire quand). Même en "anormalité" de base, la vague de chaleur de cette année n'est pas franchement remarquable au Luc (avec 38.1° au mieux contre 42.2° en 2017 malheureusement coupée très tôt dans son élan par la bascule de vent de terre à la brise de mer. Connaissant bien l'évolution de la Tx au Luc qui monte bien plus tardivement sous vent de terre, le record absolu aurait été pulvérisé, le record national probablement aussi, ce n'était qu'une question de météo et donc de timing fin). Le fait marquant cette année au moment de la réalisation du graphe il y a un bon moment, n'est pas dans le chaud, mais dans le froid avec 3 valeurs très décalées en février (laissant même croire à un bug quand j'ai vu ça, mais chez MF c'est pareil, et cohérent avec mes relevés ici, 3 valeurs différentes ici, mais très proches. Au Luc, Tx 2.3°, 3 jours consécutifs, déjà que ce n'est pas courant d'afficher des valeurs si froides, mais identiques ! La proba de sortir un truc pareil doit être très faible, quasi impossible ! Donc voilà un exemple de la puissance de la météo dans l'aléatoire, pour déjouer toutes les proba) :- 308 réponses

-

- 12

-

-

-

Suivi du temps dans les régions méditerranéennes: Novembre 2018

ChristianP a répondu à un sujet de Toulnono83 dans Le temps en France

Nouveau record mensuel d'octobre de 437.5 mm (ancien 301.2 mm en 2013, mesures depuis 1993) , 3 ème valeur de la station après les 444.2 mm en Nov 2011, record absolu de 493.4 mm en Nov 2014. Pour les toulonnais, hier en regardant dans des archives, j'ai vu un maxi de 410 mm en oct 1839 (430 mm à Hyères) Je n'ai pas regardé si l'info est passée, la station de Toulon la Mitre a été déplacée dans l'arsenal il y a peu (attention la classification de la fiche est encore pour l'ancienne. A priori il reste encore la T et la pluviométrie à la Mitre pour comparer) https://donneespubliques.meteofrance.fr/metadonnees_publiques/fiches/fiche_83137001.pdf -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Cette pluie abondante sans fin m'a laissé du temps ! @calou34 😀 Il faut surtout remercier Serge avec sa phrase sur le plateau, qui a motivé ce post, car sans sa parole de scientifique, je ne l'aurais pas pondu. Avec Fred c'est inutile a priori, car c'est par définition impossible que des arguments même scolairement corrects, aient un impact, du moins pour le moment, vu qu'il n'a jamais admis de telles erreurs, ce qui est logique dans son cas, il faut avancer autre chose que des démonstrations : https://enjeuxenergies.wordpress.com/2018/10/27/climat -les-raisons-cognitives-de-linaction-cerveau-psycho-4/?fbclid=IwAR0jpnDB_lU5__DBUKVfQZNIvJ4F6zxMZUBle2GebJb8FKdPxUjMwgOk7qI Oui pro, dans mon esprit, c'est rémunéré en parlant dans les médias de ce sujet, mais quand c'est aussi un scientifique (rémunéré ou pas) ou un ex météorologue de MF qui s'expriment, ils sont tous sensés s'être assez formés/informés, être plus sérieux et rigoureux dans ce domaine que la moyenne des collégiens (les uns pour mériter leur salaire, les autres pour rester à la hauteur de leur qualification de scientifique), pour ne pas propager à l'infini des énormités pareilles. @CP3 Un calcul, une méthode et/ou la théorie, établis à l'instant t, sont valides jusqu'à ce quelqu'un démontre le contraire. La croyance dans ce cas, c'est de revendiquer que c'est faux, que c'est autre chose, sans jamais le démontrer de façon scolaire et scientifique. Une opinion et une pensée aussi lumineuses soient-elles pour certains, ne peuvent valider/invalider quoi que ce soit en science. http://23dd.fr/climat/histoire-rechauffement-climatique/111-glossaire-refutabilite-falsifiabilite http://www.charlatans.info/verite-science.php @Cotissois Je n'ai pas fouillé ces séries car connues pour être plus incertaines pour la climato et en prime le bruit météo, c'est plus ton domaine. L'incertitude est plus grande au pas journalier qu'au pas mensuel rapporté par meteor, lui même plus incertain que le pas annuel. Dans les autres séries, comme Hadley, c'est la couverture du globe la principale cause d'incertitude, la moins incertaine c'est GISS (enfin d'après leur calcul d'incertitude à l'époque où je les avais regardées de près il y a quelques années, à vérifier maintenant que c'est toujours le cas). Ca m'a poussé à réfléchir sur le bruit et le fond pour le pas journalier : Donc hors incertitude journalière de l'anomalie, en fait pour analyser les écarts d' anomalies globales de T d'un jour/quelques jours sur les autres, on retrouve le même genre d'erreur de raisonnement qu'au niveau climatique, mais à l'envers. Ceux qui revendiquent l'ENSO pour expliquer une/des anomalies journalières bien plus chaudes ou plus froides que d'autres jours proches, c'est équivalent à dire que le signal de fond du RCA influence la T mensuelle ou annuelle globale d'un mois/d'une année sur l'autre, bien plus que le bruit interne (Rien que l'ENSO dans le cas extrême à 95% pourrait faire varier l'anomalie annuelle de +0.15° à -0.15° en plus de la valeur attendue avec la tendance (avec tous les autres bruits neutres) en 3 ans environ. 0.3° de variation/ 3 ans que le RCA moyen actuel de 0.017°/an ne peut pas réaliser en moins de pratiquement 18 ans. Le bruit qui est interne pour le climat est de fait un signal de fond pour l'échelle temporelle journalière, donc il est négligeable pour l'analyse du bruit au pas journalier d'un jour sur l'autre, ses variations rapides seront prises de fait en compte par l'analyse de la météo à l'échelle globale. Ca se vérifie. Le signal de fond moyen pour le pas journalier est donné approximativement par le loess auto qui est la synthèse de la variabilité interne au climat. Ce signal de fond pour le pas journalier est la résultante visible du RCA + ENSO + cycle solaire + volcans + aérosol + PDO +AMO ...et autres bricoles connues ou pas. L'écart maximal dans le loess auto d'un jour sur l'autre est de seulement 0.000256° ! (Maxi relevé pendant la pente+ récente du loess auto avec l'aide du Nino 2016). Donc avec ou sans incertitude de l'anomalie journalière, ce n'est pas la peine de regarder de ce côté là ! Sans le loess auto, on retrouve le même ordre de grandeur pour l'ENSO dans le le cas extrême à 95% entre un ENSO+ à +0.15° et un ENSO- à -0.15° en 3 ans, on aurait une variation journalière moyenne que de 0.000278° (sans un autres bruits, tous neutres), mais comme on n'est pas dans ce cas extrême, la variation due à l'évolution de l'ENSO actuelle, est beaucoup plus faible entre des jours donnés, c'est négligeable à cette échelle. L'influence de l'ENSO est vu stable pour le pas journalier vu que c'est une moyenne (le bruit journalier dans l'ENSO sera pris en compte de fait par les SST journalière de la zone). Autour de ce fond de l'indice ENSO qui ne bouge pas assez à cette échelle, c'est de la météo pure qu'il faut analyser à l'échelle globale, continentale et maritime. Pour moi il faut donc un raisonnement plus proche de celui qu'on a pour analyser la T journalière d'un jour sur l'autre dans une station donnée, mais à l'échelle globale. On ne va pas prendre l'ENSO, le cycle solaire, ni le RC, ni les volcans, ..., pour expliquer des variations d'anomalies entre des jours/groupe de jours. Là c'est du même ordre, même si la variabilité est moindre avec la moyenne globale de toutes les stations et SST, il y a obligatoirement différents paramètres météo globaux qui jouent plus d'un jour à l'autre/périodes de quelques jours, comme par exemple une anomalie globale+ d'insolation/24h sur les continents et glaces, plutôt que sur les mers, une anomalie+ globale de couverture nuageuse nocturne (+ de nuages bas la nuit sur les continents/glaces), anomalie+ globale de vent de mer plutôt que de terre/de glace, anomalie+ globale de vitesse de vent nocturne sur les terres/glaces (hausse de T nocturne par brassage sur de plus grandes étendues que d'habitude), anomalie+ de pression basse sur les continents/glaces, anomalie+ d'étendue de précipitation diurne et/ou nocturne sur les continents, bas géopotentiels et autres éléments de météo pure que tu pourras trouver capables de synthétiser ou d'être des indicateurs de diverses anomalies globales de paramètres qu'on n'a pas à disposition pour y parvenir. Parfois ces anomalies explicatives potentielles, s'additionnent presque toutes dans un même sens ou dans l'autre, bien que dans la grande majorité des cas, certaines se compensent plus ou moins (C'est comme pour le bruit au niveau climatique, un ENSO+ puissant pourra se produire en même temps qu'un cycle solaire+, puissant, avec l'absence de bons volcans depuis longtemps, une diminution des aérosols artificiels, sous une AMO+, une PDO+, une IPO+, avec un Blob..., enfin la fournaise totale pour tous les bruits, le pied !😂 Et inversement bien des bruits négatifs dans le même sens vers le froid.) C'est encore une question d'échelle temporelle. Pour le pas journalier, il faut faire de la météo à l'échelle globale. Il faudrait trouver les anomalies annuelles, mensuelles et journalières globales en nb d'écart-type sur les continents/glaces (calculées d'après l'anomalie d'écart-type de chaque maille) et celles sur les mers/glaces pour nous donner une idée de ce qui varie le plus loin de la normale dans ces cas (en °C on ne peut pas vraiment le voir). J'ai toujours trouvé dommage que les organismes ne publient pas en plus des données/cartes habituelles au niveau global, les données/cartes d'anomalies en nb d'écart-type d'après le nb d'ET spécifique à chaque maille. Si les anomalies classiques en °C, chaudes se retrouvent plus que d'habitude sur les mers que sur les continents/glaces, l'anomalie globale sera moindre du fait que sur la mer un niveau très élevé équivalent en °C est impossible à atteindre. Le nb d'ET global augmentera dans ce cas et on verra du rouge sombre en pleine mer, équivalent au rouge sombre qu'on trouve sur les continents/glaces avec les énormes anomalies en °C sur les cartes d'anomalies classiques, alors que l'anomalie globale sera parfois plus faible malgré une anomalie en ET plus forte (Inversement si le froid d'intensité équivalente en ET, se retrouve plus souvent au-dessus des mers que d'habitude) Je me rappelle avoir vu ce type de carte dans des prévis du RC de je ne sais plus quel organisme et c'était bien plus parlant, car on pouvait comparer le vraiment plus chaud que d'habitude de chaque maille, alors qu'en °C on ne perçoit pas vraiment le problème du RC en mer, bord de mer et dans toutes les zones ou l'ET est faible. +1° d'anomalie à Ouessant ça n'a rien à voir avec +1° à Strasbourg, à Moscou ou vers l'Arctique. Une carte et des données d'anomalies d' ET montreront les véritables anormalités (Certaines anomalies peuvent être très anormales sans qu'on s'en rende compte dans les zones à faible variabilité et paraître très anormales dans les zones à forte variabilité alors qu'elles ne le sont pas !) @th38 , une référence donnée est spécifique à chaque mois pour enlever le cycle annuel, donc il y a des écarts différents. Quand on utilise des anomalies issues d'une référence mensuelle, on supprime du bruit saisonnier qui n'est pas dû à une variation du fond, mais à des variations habituelles, comme par exemple, avec la différence entre les mois d'été de l'hémisphère Nord et de l'hémisphère Sud, car il est recouvert de bien plus d'eau.