ChristianP

Adhérent Infoclimat-

Compteur de contenus

2904 -

Inscription

-

Dernière visite

-

Jours gagnés

1

Type de contenu

Profils

Forums

Calendrier

Tout ce qui a été posté par ChristianP

-

Oui Ludo, l'anémo doit être sur ce genre de bouée feu assez haute dans le secteur : http://farm1.staticflickr.com/33/60417694_3f79df2256.jpg

-

Et oui, les vents énormes sont relativement courants dans les bonnes tempêtes en mer sur ces points de mesure. A noter que la 62170 est une vraie bouée avec l'anémo à hauteur normalisée (OMM) de 3 m sur mer (Ce qui est équivalent à une mesure à 10 m de haut sur un terrain plat avec végétation courte de 5 à 10 cm dans un rayon de 250 m et des obstacles au-delà, à une distance de plus de 20 fois leur hauteur), alors que la mesure 62304 un peu plus importante, est relevée avec un anémo à 14 m de haut sur un bateau phare.

-

Suivi de l'englacement au pôle nord

ChristianP a répondu à un sujet de sirius dans Evolution du climat

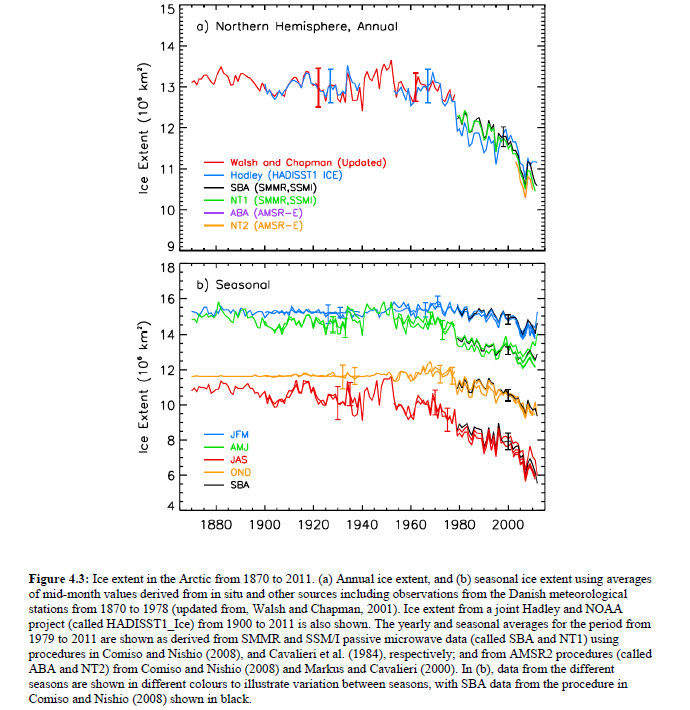

La science n'est pas une histoire d'opinions, heureusement pour nous, sinon elle se règlerait au café du commerce du Net et d'ailleurs, ou dans les urnes, où aucun travail, ni aucune rigueur scientifique n'est demandée, l'opinion du pire écervelé ayant la même valeur et le même poids que celle des meilleurs scientifiques ! La science explique les faits et autres notions, à l'aide de démonstrations scientifiques rigoureuses qui sont débattues devant les pairs. Ce sont les explications émises qui peuvent-être différentes tout en étant rigoureusement démontrées et scolairement justes, ce qui n'empêchera pas qu'une ou plusieurs de ces explications peuvent-être des hypothèses plus ou moins fausses à l'instant t (pour x raisons : manque de données, de connaissances, d'outils plus performants, de notions fondamentales, ...). Des explications s'opposent sur un même sujet quand il n'y a pas assez de preuves, mais même quand il existe toutes les preuves nécessaires, comme la terre est ronde, fumer tue massivement... (donc pour des faits qui vont bien au-delà des 95% de confiance pour la théorie climatique), il existera toujours des personnes pour les contredire pour x raisons sans rapport avec la démarche scientifique, sans avancer aucune démonstration au moins valide d'un point de vue scolaire. Avec la tendance à la baisse donnée, on s'attend toujours à ce que les valeurs se trouvent de part et d'autres de la tendance centrale dans certaines limites (IP à 95% que tu devrais apprendre à calculer pour enfin pouvoir dire ou non si une valeur est normale ou non pour la tendance donnée à la baisse) et non pas toujours en dessous des autres valeurs (tout le monde d'un peu sensé en stats, s'attendait à ce qu'une valeur compense celle de 2012, pour redresser un peu la distribution autour de la tendance de fond à la baisse, sans savoir quand. Le gros problème de la recherche c'est d'arriver à expliquer et à prévoir les détails et donc de parvenir à situer précisément le bruit, les valeurs au-dessus ou en dessous de la tendance à la baisse, vu que la science nous indique avec une grande confiance, qu'il y a eu et qu'il y aura une baisse sur le fond.) Il n'y a pas de rebond, ni de pause (avec le niveau vers le 20 octobre), vu que même la toute dernière moyenne/10 ans avec 2013 continue de se dégrader. 2013 pour cette période, réduit encore la plus récente moyenne/10 ans (qui n'est pas une normale, pas plus que celle des années 2000) qui de fait intègre 2012. Pour que la moyenne/10 ans rebondisse avec 2013 et donc n'évolue plus à la baisse au moins cette année et pour cette période précise (vers le 20 octobre), il aurait fallu que la valeur de 2013 soit la 10 ème plus haute des 10 valeurs présentes dans la dernière moyenne 2004-2013 et qu'en prime 2013 affiche une valeur supérieure à 2003. (Et là on ne discute même pas d'un rebond/d'une pause de la normale/30 ans ou de la tendance de fond, où il il faudrait un truc incroyable pour que ce soit le cas) La fin des années 2000, c'est il y a 4 ans seulement, donc logique que des valeurs avec un moindre déficit que 2012 ou 2007, toujours important pour parvenir à réduire la dernière moyenne/10 ans, s'approchent de la moyenne des années 2000. La dernière moyenne/10 ans n'est pas du tout indépendante et n'est vraiment pas loin du niveau des années 2000 (ni au niveau de la valeur de 2007 qui fait partie de la précédente moyenne) pour qu'une valeur actuelle proche de la moyenne 2000-2009, indique quoique ce soit. C'est l'écart annuel le plus important enregistré, entre 2012 et 2013 qui impressionne ceux qui oublient systématiquement la tendance de fond et de suivre les moyennes. Cet écart à cause du bruit météo, montre un échantillon de l'indépendance des valeurs dues à la météo (qu'on vérifie objectivement en retirant le signal significatif, il n'y a pas de corrélation significative de l'ensemble du bruit.) Cette valeur de 2013, n'a pas de poids significatif pour le fond (tout comme la valeur de 2012, n'en avait pas, sinon on n'aurait pas observé la valeur de 2013), ni pour le bruit de septembre prochain, même si cette valeur était relativement élevée. 2006 qui avait récolté plus d'extent que 2013 à cette même période, n'a pas empêché d'observer le mini de 2007 et n'a pas plus ralenti la tendance de fond, comme pour bien d' autres valeurs par le passé depuis que la tendance est significativement à la baisse, c'est le fond qui compte, c'est l'évolution du climat qui prime, la météo ne joue plus que pour 1/3 environ. La tendance de fond pilote, la météo module toujours les valeurs autour de la tendance (là à la baisse) et produit du bruit relativement irréductible ( enfin du moins tant qu'il reste assez de glace et que la mer n'est pas trop chaude, car c'est certain que s'il n'y a plus de quoi couvrir la valeur sup de l' IP à 95% de la tendance donnée, le bruit va se réduire logiquement, en fonction des possibilités physiques réelles) La météo ne change pas la donne, elle ne crée pas de tendance climatique de fond non nulle, c'est ce qui modifie le climat qui change la donne (voir l'AR5 pour les causes et les incertitudes) Depuis le graphe de Tamino, on a l'évolution de l'extent depuis 1870 donné dans l'AR5 avec les barres d'erreurs plus larges pour les obs passées : On ne peut pas dire que la valeur mini de 2013 est exceptionnelle pour la tendance linéaire du NSIDC, on est loin d'être à plus de 2 sigma de la valeur centrale. Avec les stats, ce sont uniquement ceux qui se seraient appuyés uniquement sur la tendance quadratique ou exponentielle calculée avec la valeur de 2012, qui auraient été dans les choux et qui n'auraient pas pu envisager cette valeur, car hors IP à 95%, mais pas ceux qui ont utilisé des tendances quadratiques antérieures (significativement différentes de la linéaire plus haut), vu qu'en stats pour estimer la valeur suivante plus efficacement, il vaut mieux éviter de pondre un modèle qui intègre la toute dernière valeur qui est la plus extrême, sans qu'il y ait eu sa compensation statistique par rapport à la tendance initiale. Voir quelques rapports : http://nsidc.org/news/press/2013_minimum_final.html Une autre analyse ici en allemand http://www.meereisportal.de/de/meereisbeobachtung/meereis_beobachtungsergebnisse/beobachtungsergebnisse_aus_satellitenmessungen/einschaetzungen_der_meereissituation/ traduit par google : http://translate.googleusercontent.com/translate_c?depth=1&hl=fr&ie=UTF8&prev=_t&rurl=translate.google.com&sl=auto&tl=fr&u=http://www.meereisportal.de/de/meereisbeobachtung/meereis_beobachtungsergebnisse/beobachtungsergebnisse_aus_satellitenmessungen/einschaetzungen_der_meereissituation/&usg=ALkJrhiUSk_IMzad5H7dvaH8Nl5ZR09T3Q (Voir aussi l'analyse sur l'Antarctique intéressante : http://translate.googleusercontent.com/translate_c?depth=1&hl=fr&ie=UTF8&prev=_t&rurl=translate.google.com&sl=auto&tl=fr&u=http://www.meereisportal.de/de/meereisbeobachtung/meereis_beobachtungsergebnisse/beobachtungsergebnisse_aus_satellitenmessungen/einschaetzung_der_aktuellen_meereissituation_antarktis/&usg=ALkJrhjjitrf6WdgkcSXS2ka8W_Mj4XsyA ) -

En fait il y a eu 81 km/h de vent maxi à Albert-Bray, dans IC c'est probablement une rafale max/ 10 mn avant le relevé (certains synops ne donnent que cette donnée) Même sans ce petit décalage, l'écart est faible pour ces deux stations éloignées (dont Cambrai plus Nord) pour des rafales sur 0.5 s représentatives d'une échelle de 5 m. Il faudrait voir l'installation de l'anémo de Cambrai qui a relevé un vent moyen/10 mn plus fort. Celle d'Albert-Bray est au top classe 1, avec un site qui génère probablement peu de turbulences qui peuvent engendrer parfois des rafales anormalement fortes pour un vent moyen donné. Le coeff vent max/ vent moyen a l'air un peu meilleur à Bray sur ce coup du moins, donc pas de sous-estimation. Le vent a très probablement soufflé foncièrement plus fort à Cambrai.

-

Si tout ce message me concerne, c'est que tu interprètes certains propos comme souvent, vu qu'il n'y a aucune prévis dans mon texte ( je n'ai d'ailleurs pas cherché à prévoir la puissance de ce coup de vent, il y a assez de passionnés et de services de météo de qualité pour me faire plaisir simplement en les lisant) je ne risque donc pas de discuter ou de rediscuter de la prévis, je te fais confiance pour faire ressortir ce qui clocherait J'ai posté une simple remarque générale sur le fait qu'il n'y a pas toujours besoin que la pression soit très basse pour que ça mouline très fort, en donnant un exemple.

-

Ce n'est pas la profondeur de la dépression qui compte toujours le plus, c'est le gradient, la vitesse de creusement et de déplacement. 3 février 90 à 12h TU, 70 Nds de vent moyen à la pointe du Roc (rafale 90 Nds) avec une dep à 990 hPa à ce moment là (vent maxi entre le gradient 1000 et 990 hPa). Changement de pression de +20.7 hPa/3h à Grandville, le centre se déplaçait à 40 Nds (Météo Marine de R. Mayençon) Il y a pas mal de monde en mer dans ces secteurs très fréquentés pour fournir des relevés de pression suffisants pour les analyses, même si tous les navires ne participent pas au réseau (les avions aussi alimentent et des navires de guerre aux relevés non pointés sur les cartes) Ici on peut voir en temps réel les navires pour des zones limitées, couvertes par le système relativement proches des côtes : http://www.marinetraffic.com/ais/fr/default.aspx

-

Dans la nuit : 120 km/h à St Ségal 115 km/h à la Pointe du Raz 114 km/h à Camaret 113 km/h à Plougonvelin (Normal que largement à l'avant d'un "Christian" ça mouline déjà )

-

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

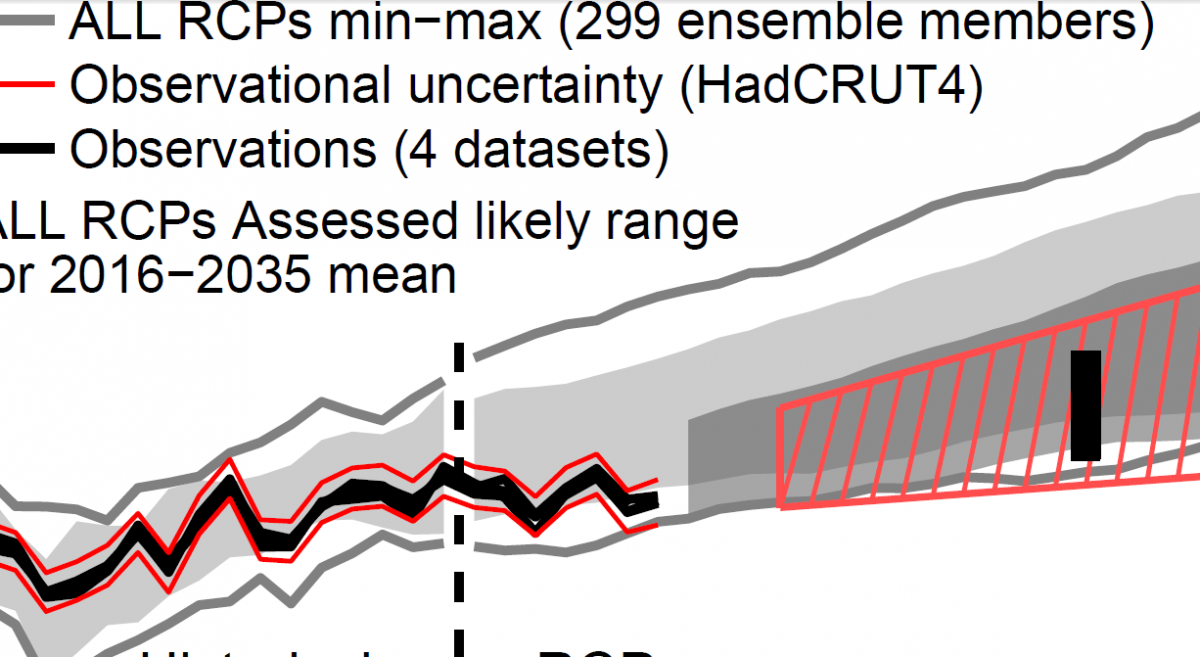

Gpiton, avec les projections à court terme (2016-2035), c'est quand même une prévis intermédiaire entre les prévis décennales et les projections classiques de plus long terme, la confiance est moyenne, il y a encore trop de bruit pour sortir une prévis assez efficace avec les modèles actuels. Dans le chapitre 11 (la fonction de limitation du nb de citations à 10 dans un message du forum est pénible, voici la 11 ème sans cadre) : Key points are: 1) the uncertainty in near-term projections is dominated by internal variability and model spread. This finding provides some of the rationale for considering near-term projections separately from long-term projections. Même si c'est du court-terme, ces projections ne sont pas initialisées avec les les obs : Dans le graphe 11.25 de l'AR5 (TS.14 dans le résumé) de l'article que tu pointes dans un message précédent, je ne vois pas l'IC sup de l'obs, sortir de l'IC à 90 % du graphe central (et donc encore moins de l'IC classique à 95% absent), donc même si ce n'est pas loin de sortir, on ne peut pas dire objectivement que c'est sorti, d'autant plus que la valeur modèle représentant la limite à 90%, a aussi son propre IC qu'on ne montre pas dans ce graphe (cette valeur limite est plus incertaine que ne le sera l'obs pile à ce même niveau) On ne peut pas exclure des scénarios, vu que pendant cette période, ça ne fait pas vraiment de différences : En 2030, il n'est pas prévu d'écarts importants à cause des scénarios. C'est plus une histoire de différences de modèles que de scénarios : On peut voir dans la synthèse des projections à court-terme du chapitre 11, que pour la période 2012-2035, on a même un IC inférieur à 90% qui tombe à 0.11°/déc (donc une tendance moindre avec l'IC à 95 % classique) : Ca signifie de fait que même avec une tendance nulle et ses IC classique sur la période 2012-2035, on ne pourra même pas affirmer que c'est incompatible avec la prévis. Même en raisonnant à partir de l'AR4 et des 0.2°/déc/30 ans (soit +0.6°/30 ans pour la moyenne climatique), une tendance /30 ans est connue à au mieux 0.05° près (statistiquement, sans même combiner les incertitudes de mesures et de la détermination de la T globale), donc un peu moins incertaine que celle /24 ans (comme 2012-2035), il faudrait une tendance de moins de 0.1°/déc/30 ans pour pouvoir indiquer que la tendance prévue ( celle de 0.2°/déc/30 ans) est incorrecte, alors qu'en testant les changements à partir des 2 moyennes/30 ans indépendantes, on détectera plus facilement, si la valeur observée est compatible ou non avec l'évolution la moyenne/30 ans. Il faut bien faire la distinction entre la prévis climatique ( qui est le changement de l'état moyen/30 ans) et une tendance sur 30 ans, qui elle, n'est équivalente qu' à une comparaison de 2 moyennes/15 ans. C'est une tendance/60 ans qui représente l'évolution climatique, car c'est la première tendance d'échelle climatique qui recouvre au moins 2 échantillons de climat. Une tendance/30 ans permet en général de distinguer le signal forcé hors de la variabilité naturelle, mais vraiment pas celle de l'évolution du climat, cible des modèles. Quand tu traces une tendance sur 7 ans, c'est comme comparer 2 moyennes / 3.5 ans..., quelque "peu" bruitées. A noter qu'il suffirait de relever une tendance de 0.23°/déc /2013- 2030, pour que la valeur tombe pile sur la prévis de 0.2°/déc (avec GISS), ce qui est encore largement faisable, étant donné que sur 92-2006, donc sur 15 ans, cette série a affiché une tendance de 0.28°/déc (cette fois on partirait d'un niveau relativement bas à cause du surplus de Nina et non plus à cause d'un volcan) Se servir de tendances partielles ou même d'une complète sur un seul échantillon de climat qui contient 30 années, ça n'a pas d'autre sens que d'analyser des variations dans l'échantillon lui-même. Ce n'est pas l'évolution du climat étant donné qu'il est impossible de voir l'évolution sans comparer moins 2 échantillons de 30 ans (que ce soit avec des moyennes ou des tendances, il faut 60 ans de données) On peut prendre un exemple local réel assez comique pour celui qui serait obnubilé que par une tendance complète sur un seul échantillon et qui refuserait de comparer au moins 2 échantillons. Avec une Tx moyenne mensuelle phénoménale de 38.0° en août 2003 dans une station MF à Draguignan (fermée depuis), malgré la tendance fortement négative des Tx sur l'ensemble des 31 jours de ce mois (-2.6°/décade, donc -8.1°/31j pour tout ce mois bouillant !), ça ne signifie pas pour autant que la Tx moyenne d'août 2003, est devenue plus froide ou stable par rapport aux autres mois d'août. C'est le mois d'août le plus chaud en Tx jamais enregistré, sans qu'on puisse le savoir si on reste fixé uniquement sur cette tendance pourtant complète sur l'échantillon, en oubliant de consulter un ou d'autres échantillons de moyennes/31 j représentant un ou des autres mois d'août à comparer pour chercher une évolution ! Quand on compare deux moyennes/20 ans, pour suivre l'évolution du climat, c'est mieux que de tirer une tendance sur 20 ou 30 ans, mais il manque quand même 20 ans de données. Je ne comprends d'ailleurs toujours pas pourquoi (vu que je ne suis pas tombé sur l'explication dans l'AR5) le GIEC est encore sur 20 ans alors qu'à l'époque de l'AR4, les scientifiques n'étaient déjà pas chauds pour utiliser cette durée, d'autant plus que l'AR5 martèle toujours la même chose sur la durée de base pour le pas climatique minimal cible des modèles climatiques : Dans la FAQ aussi : Là encore dans l'AR5 à l'occasion de la mise en avant d'une tendance sur 23 ans (1990-2012), il est bien indiqué que les projections des modèles ne sont pas faites pour ces échelles temporelles courtes : (Petite parenthèse : Par rapport à la discussion sur Tamino dans un sujet plus haut, j'ai vu qu'un peu plus bas que ce paragraphe plus haut, sa méthode de traitement du bruit est considérée comme valide par le GIEC (Rahmstorf et al., 2012, c'est la mise à jour de FR 2011) vu qu'ils l'utilisent dans l'AR5 : ) Donc ce n'est donc pas parce-que le GIEC nous communique des graphes et prévis avec des valeurs moyennes/1 an, /20 ans ou des tendances /10 ans, que la cible de la prévis et la capacité efficace des modèles sont annuelles, décennales, internes à une période de 30 ans. Ce ne sont pas des modèles décennaux, qui eux ne sont qu'expérimentaux et insuffisants d'après tous les scientifiques (le consensus est de 100%, à part comme d'habitude chez les négativistes qui sortent les ratés des prévis expérimentales des modèles décennaux pour faire croire que les modèles climatiques sont bidons, car leur spécialité est de mélanger volontairement les échelles temporelles) FAQ du chapitre 11 : D'après les calculs de ton message du 10 octobre, tu avais indiqué des valeurs les moins probables pour 2016-2035 / 1986-2005. L' AR 5 indique ici ce qui est le moins probable pour l'évolution de la moyenne de 2016-2035 : Donc le réchauffement le plus probable de la moyenne/20 ans en 2016-2035 (avec une confiance moyenne, donc dans l'absolu, la proba n'est pas fameuse) serait d'au plus 0.39° (1° - 0.61° ; 0.61°+-0.06°, c'est l'anomalie de 86-2005 donnée par l'AR5) J'ai regardé pour la série au pas annuel GISS, je trouve une anomalie de 0.4° pour 1986-2005 sans arrondir, avec l'IC à 95% [0.33° ; 0.47° ] . Sur 2006-2012, la moyenne des anomalies est de 0.584°, IC à 95% [0.534° ; 0.635°] Donc le réchauffement de cette petite moyenne est déjà statistiquement significatif, malgré le bruit à ces échelles courtes. Pour la tendance climatique de fond, il y a un graphe de l'AR5 intéressant pour l'estimer assez bien sur 61 ans, vu qu'on nous donne la période où la tendance des forçages naturels est nulle (avec des IC particulièrement faibles), sur 1951-2011 : La tendance de fond est de 0.126°/déc +-0.028° avec GISS. On ne peut pas faire mieux, car non seulement c'est la tendance minimale d'échelle climatique qui recouvre 2 échantillons de climat, mais en prime de fait elle prend en compte une éventuelle oscillation d'environ 60 ans (donc par définition influence quasi-nulle pour le fond, sur la période complète) Si on regarde la période précédente de 61 ans, 1890-1950, la tendance est de 0.061°/déc +-0.019° (hausse faible mais déjà significative d'un RC) et elle est significativement différente la tendance 1951-2011. Il est donc très improbable que la tendance climatique de fond sur 60 ans descende significativement sous l'actuelle, il est bien plus fortement probable que la tendance climatique de fond /61 ans augmente significativement au delà de celle enregistrée (0.126°/déc), vu le changement sur le fond avec un forçage moindre et des rétroactions minimes dans une bonne partie de cette période (ceci pour un même forçage naturel nul, qui n'est pas garanti pour les 60 prochaines années) -

Suivi de l'englacement au pôle sud

ChristianP a répondu à un sujet de northern lights dans Evolution du climat

Il y a 9 jours, c'était largement un record pour la période satellite, actu c'est revenu au niveau de 1980 (record de ces jours). http://arctic.atmos.uiuc.edu/cryosphere/antarctic.sea.ice.interactive.html -

Surchauffe remarquable des abris MF avec un RG très moyen

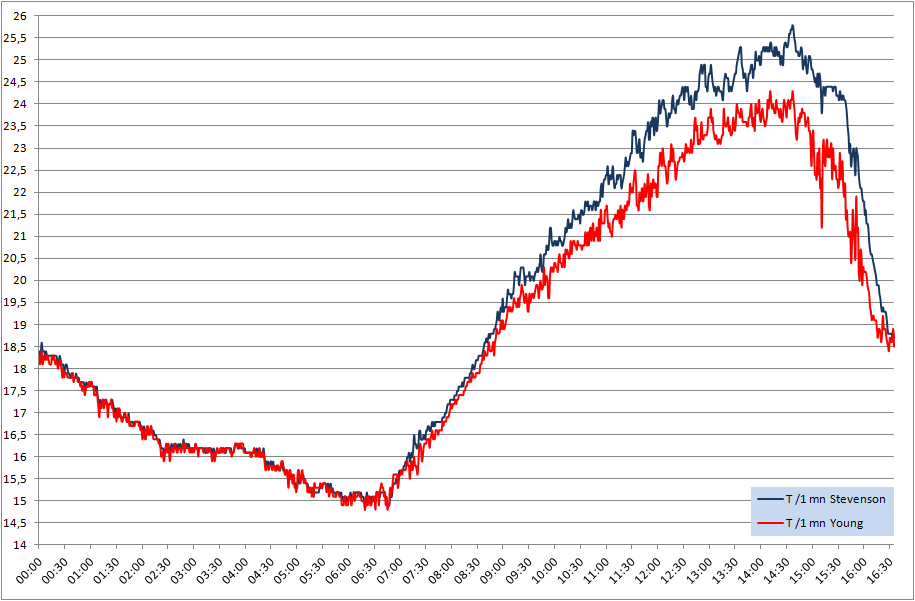

ChristianP a posté un sujet dans Instrumentation

Surchauffe remarquable aujourd'hui de 1.5° à 2° (selon les références) de la Tx avec l'abri Stevenson MF en classe 2 (idem à 0.1° près dans le Socrima tout neuf en classe 2) avec seulement 347 W/m2, par rapport au Young ventilé méca à 6 m/s en classe 2. Un exemple remarquable aujourd'hui à 16h36 loc (graphe en UTC), ce qui est tardif ici pour une Tx surtout en cette saison, car d'habitude les brises marines ventilent systématiquement, ce qui n'est pas le cas ce jour, car c'était la fin d'un d'épisode de Mistral, au moment où il est tombé (Tx relevée après 3 min de vent moyen/1 mn < 1 m/s à 16 m et après 11 mn < 1 m/s à 2 m, 0.0 m/s au moment de la Tx, ce qui est très rare ici avec du soleil chaud à ces horaires) Tx dans l'abri Stevenson : 26.1° au thermo MF, 25.9° à la thermistance Davis (25.8°/ 1 mn), 25.8° à la Pt 1000 Contre, dans l'abri Young ventilé méca : 24.1° Tx de référence et 24.4° en instantané au Davis SHT 75 (24.3°/1 mn) et 24.3° à la Pt 1000. Le sol est humide et vert, c'est typique d'une pure erreur due à l'abri à ventilation naturelle par vent calme et soleil assez rasant (le noir intérieur améliorera probablement ce genre de cas). Même l'été je ne relève pas ce type d'écart, car le sol est bien plus sec et la végétation carbonisée, des petites bulles d'air plus chaud montent par convection à cause du sol surchauffé et sont aspirées par l'abri méca, compensant la surchauffe de l'abri MF seul. -

Comparatif des moyennes 1951-1980 et 1981-2010 dans le Sud-Ouest

ChristianP a répondu à un sujet de acrid vintaquatre dans Climatologie

Bonsoir, Oui il vaut mieux Biscarosse pour suivre l'évolution de la T dans le temps que le CF, même si je ne connais pas son évolution, au moins le secteur de la station actuelle est resté assez naturel. Si tu ne trouves pas que le CF surchauffe plus que Biscarosse en moyenne, c'est probablement parce que le CF est plus froid en réalité (à normes comparables), ce qui masque l'écart réel. Il y a très longtemps, bien avant qu'IC existe, que j'ai détecté des valeurs anormales en Tx l'été au CF, avant de connaître le site et son cloisonnement. En toutes saisons, c'est surtout le goudron sous et autour de l'abri, et les constructions proches (dont une énorme et étendue) , qui donnent des Tn différentes par rapport à l'époque où il n'y en avait pas (là par rapport au sable représentatif du coin, c'est encore pire d'installer du goudron et du béton pour les Tn, que par rapport à la terre) Enfin par rapport au Cap Cépet, c'est presque rien, l'anémo et l'abri au lieu d'être installés sur le sommet actuel, en 70 ils se situaient tout en bas au niveau de la rade de Toulon, à St Mandrier à la base des hélicos, l'abri sous des arbres, le mât d'anémo sur une jetée...; difficile de détecter de vraies évolutions dans les données brutes avec des changement pareils, surtout quand on ne nous communique pas les dates de changements ! Le problème pour le suivi de la T, ce sont surtout les changements dans le temps. Une classe 5 qui reste classe 5 dans le temps, en climato c'est mieux qu'une classe 5 qui devient classe 1, alors qu'on gagne pourtant en qualité pour le temps réel, les nouveaux records et les modèles purement météo. Ce changement très favorable, n'est pas bon pour analyser des données brutes dans le temps. Pour Cazaux, c'est bon de nos jours, mais si c'est comme au Luc et que la station a changé de site alors que ce n'est pas indiqué dans la climathèque, dans un coin différent même très proche, ce n'est pas gagné. -

Comparatif des moyennes 1951-1980 et 1981-2010 dans le Sud-Ouest

ChristianP a répondu à un sujet de acrid vintaquatre dans Climatologie

Et oui, c'est comme à Toulon, d'après les photos, la différence n'est pas importante entre le site de 1971 et maintenant. Le carnage pour les relevés s'est donc produit entre 1946 et bien avant 1971. C'est même assez incroyable la différence autour de l'abri en moins de 20 ans, on passe de la classe 1 à 4. Attention pour le Cap Ferret, s'ils n'ont pas déplacé l'abri très loin et/ou rasé le quartier depuis les photos que j'ai vues passer et la dernière de Google Earth, c' est une pure classe 5 à cause de l'urbanisation massive très près de l'abri, la totale, un gros cloisonnement en prime et même le sol sous l'abri est artificiel. Toulon est bonne en comparaison, vu que l'abri est à quelques mètres de la mer, près du bord de la falaise ! La station de Bordeaux-Mérignac même en étant plus proche d'une grande ville est autrement plus propre actuellement, site probablement classe 2, mais l'important c'est de voir comment était placé l'abri dans le temps. La meilleure des trois stations et la plus naturelle, c'est celle de Cazaux qui a l'air classe 1 en prime, si elle est bien pointée. Il existe des stations qui sont mieux installées malgré l'urbanisation maintenant qu'avant, et inversement. Quand on tombe sur des photos anciennes d'une station et qu'on compare, c'est assez incroyable et heureusement qu'il existe l'homogénéisation ! Difficile de travailler assez sérieusement sans les Tmm homogénéisées par MF, qu'on peut commander maintenant dans la publithèque, mais on ne peut pas choisir uniquement les Tmm pour limiter le coût, donc ce n'est pas donné : 150 euros pour une seule station avec tous les paramètres dispo homogénéisés, y compris les RR et la DI homogénéisées (quand la mesure existe depuis longtemps), mais bon MF effectue un boulot monstre pour homogénéiser, bien plus lourd que pour établir une normale, je trouve donc ça autrement plus rentable et plus scientifiquement correct que de payer pour une fiche climato classique de données brutes avec des records parfois sans queue ni tête, si on ne dispose pas des métadonnées précises... -

Salut Ludo Hyperterminal ici, c'était juste pour récupérer sur un micro tous les échantillons de rafales d'au moins 0.33 s afin d'étudier comment fonctionnaient les rafales courtes ou longues sur mon site, ce pas court obtenu sur le micro après une modification perso dans la console pour améliorer le débit entre le micro et la console (liaison trop lente pour les capacités de l'anémo d'autant plus que le vent est fort), que j'avais demandée à Peet Bros, vu qu'il indiquait quelque part que c'était possible. En dehors, j'utilisais le logiciel de base de Peet Bros (qui lui extrait les rafales max sur un pas bien plus court que 0.33 s quand c'est le cas, comme enregistré dans la console, ainsi que le vent moyen/1 mn, etc, mais il ne fournit pas un listing de tous les échantillons de rafales sur quelques centièmes de seconde, comme Davis, c'est une synthèse toutes les minutes ou autres selon configuration choisie), sans datalogger (il n'y a pas de mémoire en cas de coupure du micro). Il existe des dataloggers hors Peet Bros, un plus cher que la station complète et maintenant un autre sur IP plus abordable,compatible avec d'autres stations il me semble (pour ce modèle que je n'ai pas en tête, c'est passé dans ce forum il y a pas mal de temps)

-

Calcul de l'ensoleillement avec Weatherlink

ChristianP a répondu à un sujet de Seb-50 dans Instrumentation

Bonjour ! J'avais déjà consulté sur ton site, ton type de graphe très intéressant et très parlant. Si tu parles d'une "ombre portée nette" sur le sol, par rapport à ce qu'on entendait souvent par le passé (et parfois encore), pour indiquer la limite de l'insolation, ça n'a pas servi à définir la valeur du seuil de 120W/m2 de direct (c'est un seuil purement matériel qui a été choisi pour correspondre le mieux au brulage du papier dans de bonnes conditions de l'ancien héliographe avec un papier de qualité et un modèle de qualité, ce qui n'était pas le cas dans tous les pays ). Il ne faut donc pas s'occuper des ombres visibles, nettes ou pas, mais des mesures objectives du pyrhéliomètre (il est indiqué qu'une erreur de +- 25% au seuil, génère une une erreur sur la DI du jour de 3%). Nos capteurs avec une faible hauteur solaire, mesurent le rayonnement global sur plan horizontal, qu'il y ait peu de direct ou pas en proportion à certains moments, n'a pas d'importance comme avec les pyrano pro. Pour le rayonnement réfléchi capté, c'est un problème d'obstacles, de normes d'installation. Comme souvent, l'installation et le site, même au niveau amateur, ont bien plus d'importance que la précision du capteur. Pour l'histoire des 5% de déviation, le problème vient probablement de la traduction de "5% of full scale" qui n'a pas été réalisée par Davis. Alors là, si j'ai bien appris quelque chose en lisant les essais pro du matériel, c'est que le prix n'est pas assez souvent une référence en mesure de nos jours (c'était plus le cas dans le passé, avec moins d'arnaqueur pro). Si on me demandait de choisir entre un anémo MF à moulinet (Degréane ou Pulsonic) et un anémo Davis ou un NRG pour mesurer dans les vents cycloniques, mon choix se portera sur les Davis et NRG et surtout pas sur les modèles de MF à moulinet... Un des meilleurs abris à ventilation naturelle au monde : le 7714 Davis, ceux de MF et bien d'autres très chers, sont derrières dans les conditions extrêmes de rayonnement en Algérie. Le pluvio MF hors de prix en comparaison, ne récolte pas plus d'étoiles (3 sur 5), que le Davis dans les longs essais pointus de l'OMM. Le comble ici, c'est que les bords du cône en métal du modèle pro de MF ont été endommagés par la grêle de 3 cm, alors qu'aucun des bords de plusieurs cônes Davis, n'est abimé (Même pas le plastique de celui qui a plus de 20 ans !) Le problème principal pour un réseau pro avec le pyrano Davis, c'est l'absence de ventilation/chauffage, car bien étalonné, hors conditions de givre et de neige, il est assez efficace d'autant plus pour déterminer une DI qui demande moins de précision. Le capteur CM11 du réseau MF a une incertitude +- 3.5% et de +- 4.3% pour le CM6 B (incertitude réelle vérifiée par divers services nationaux de météo. Il faut toujours se méfier de l'incertitude donnée par les constructeurs même pro, j'ai vu des anémo hors de prix, renvoyer des 30% d'erreurs dans les essais MF, des abris méca très chers moins bons que des abris MF et donc que l'abri Davis, quasi donné en comparaison) Mon objectif bien avant l'existence d'IC et de la mode du Net, a toujours été de rechercher le meilleur rapport précision+fiabilité/prix , par rapport à la façon de mesurer les paramètres météo, demandée par l'OMM. Pour moi avec la précision de la méthode de calculs de MF, ça n'a plus aucun sens d'investir dans un héliographe Cimel déjà 8 à 10 fois plus cher qu'un pyrano MF, même pour un réseau pro (sans parler de la maintenance de l'héliographe à fibre, pas donnée), d'autant plus que les météo et climato, ont plus besoin du rayonnement global que de la DI seule (Dixit, le centre radiométrique de Carpentras). C'est normal que les capteurs pro ou non, affichent parfois des pics énormes (d'après MF ça peut monter à 1600 W/ m2), bien plus importants que le rayonnement théorique maxi possible à l'instant t , après le passage ou près de nuages, à cause des réflexions multiples sur les bords des nuages. Il existe aussi des réflexions avec le givre (jusqu'à + 50% dans des essais entre un capteur MF sans la ventilation, par rapport à un même capteur avec ventilation, c'est à ce niveau que le Davis aura des problèmes) Dans le graphe de ton message, si pour cette même période de l'année, les bombements sont systématiques vers le début et la fin de courbe, ce n'est pas normal sans passages nuageux et ni givre (peut-être des réflexions sur des obstacles présents ?) Le problème en amateur, c'est surtout que les utilisateurs ne peuvent pas vérifier l'étalonnage du matériel livré (sans matériel en double pour se rendre sur place près d'un capteur de référence pour comparer) ou n'envoient pas leur capteur au labo avant utilisation pour vérifier l'étalonnage d'origine. Il ne demande pas souvent un capteur avec un certificat NIST, qui a un coût. Le seuil à choisir, c'est celui donné à chaque instant par la méthode MF faite pour des mesures sur plan horizontal. Les paramètres essentiels sont les deux coeff A et B, donc à mon avis, il est indispensable que l'utilisateur puisse régler ces paramètres pour son site/son climat, pour obtenir le meilleur résultat dans des conditions moyennes de trouble atmosphérique (ou lorsqu'il demande les coeff pour son coin directement à MF) Même pour l'utilisateur qui ne souhaite pas demander les coeff à MF, il peut vérifier assez objectivement que les coeff choisis, sont assez bons en moyenne, pour un trouble moyen, en regardant s'il récupère effectivement assez souvent de la DI (par ciel clair avec ce trouble moyen) à partir d'une hauteur de 3.5° (si ce n'est pas le cas assez souvent, il faut modifier le/les coeff pour obtenir un FC plus important (dans la formule, FC = A+ B * cos((2pi/365)*d) ) Si l'utilisateur n'a que des obstacles légèrement plus hauts, il peut vérifier au minimum qu'il y a systématiquement insolation dès leur passage pour ce même trouble moyen. Si les obstacles sont systématiquement plus haut que 8° en toutes saisons aux horaires concernés, il ne pourra pas tester, il faut donc règler le FC pour que le soleil présent par ciel clair soit comptabilisé assez souvent avec 11° en cas de trouble fort, car d'après MF, par trouble fort, les 120 W/m2 s'affichent en moyenne entre 9 à 11° de hauteur. Il faut bien voir que nos capteurs Davis sont souvent mieux placés sur un toit (ou parfois sur des mâts), que chez MF avec des capteurs à moins de 2 m du sol. Si tu voyais l'installation du pyranomètre MF à Bormes chez l'ONF et que tu mesurais la hauteur des obstacles, tu comprendrais pourquoi, je trouve absurde de comparer les valeurs brutes de Bormes (qui n'a rien à voir avec cette station très loin du village perché), à celles du Luc (même pour l'énergie solaire, ça n'a pas de sens de ne pas préciser au moins la durée des masques pour chaque jour, vu que l'utilisateur des données qui ne connaîtra pas l'état des masques sur cette station, ne pensera pas obligatoirement à déduire l'énergie solaire qu'il récoltera sur un terrain bien plus normal à Bormes. En fait le gros problème avec les données MF vendues sur leur espace même pro, c'est la pauvreté des métadonnées, on ne sait pas ce qu'on achète.) Ici je suis vraiment au milieu des collines et de la forêt, avec un sommet de 300 m + arbres de 20/25 m, à moins de 200 m au Sud, un site bien plus défavorable au niveau du relief et des obstacles, que beaucoup de coins vers Gujan et ailleurs (Ex : J'ai pris la photo sur le versant Nord (je ne suis pas au sommet) au Sud d'un de mes capteurs solaires sur le mât d'anémo : http://sphotos-c.ak.fbcdn.net/hphotos-ak-ash4/478134_114308708733939_755539708_o.jpg ) Avec une installation du capteur à 10 m de haut sur le mât d'anémo, la hauteur de 3° (qui n'est quand même pas si faible, ça représente quand même un obstacle de 10.2 m de haut à 100 m du capteur installé à 5 m de haut sur un toit), est régulièrement respectée pour les horaires concernés (mais pas toujours selon les saisons) vu que ce sont les obstacles dans les secteurs du lever et coucher qui sont importants. J'ai vu passer des formules simples aux plus complexes pour déterminer le direct théorique. MF utilise un modèle simple (SMARTS 2, en 2001 du moins) qui permet à chaque instant de calculer le rayonnement direct par ciel clair en fonction du trouble atmosphérique et de la quantité d'eau condensable dans l'atmosphère (w en gr/cm2, calculée d'après la T et la HR) J'ai retrouvé dans une doc MF sur le rayonnement et à l'OMM, cette formule du direct pour une surface normale aux rayons solaires : S'= S'o * exp(-T/(0.9 + 9.4 * sin h)) S'o : constante solaire à corriger de la distance terre-soleil à l'instant t . T : Trouble atmosphérique (facteur de Linke, exemple en zone tempérée 2.5 en hiver à 4 en été, sauf stations d'altitude, zone urbaine +20 à 30%, zone industrielle polluée jusqu'à +80%. Sur le Net tu trouveras des formules qui prennent en compte des paramètres météo mesurés par la station, donc possible de l'intégrer à ton calcul théorique du direct) h : hauteur du soleil -

Suivi de l'englacement au pôle sud

ChristianP a répondu à un sujet de northern lights dans Evolution du climat

C'est quand même très fort que certains habitués des ces forums, toujours les mêmes (je ne parle pas donc pas des nouveaux ou pour ceux qui ne lisent jamais de publications en anglais), soit disant passionnés de climato, ne consultent pas le tout récent rapport du GIEC pour récolter et nous diffuser l'avis de la science, plutôt que le leur. Il suffit de l'ouvrir, du moins pour ceux qui n'ont pas un poil dans la main et qui s'intéressent sincèrement à cette science et à ce que pensent les scientifiques à l'issu des débats et de la revue des travaux déjà revus par le processus classique. Dans le dernier pavé de plus de 2000 pages de l'AR5, voir le chapitre 4. Quelques morceaux de l'AR5 sur le sujet. It is very likely that the annual Antarctic sea ice extent increased at a rate of between 1.2 and 1.8% per decade between 1979 and 2012. There was a greater increase in sea ice area, due to a decrease in the percentage of open water within the ice pack. There is high confidence that there are strong regional differences in this annual rate, with some regions increasing in extent/area and some decreasing. Ice loss from Greenland is partitioned in approximately similar amounts between surface melt and outlet glacier discharge (medium confidence), and that both components have increased (high confidence). The area subject to summer melt has increased over the last two decades (high confidence). [4.4.2] The Antarctic Ice Sheet has been losing ice during the last two decades (high confidence). There is very high confidence that these losses are mainly from the northern Antarctic Peninsula and the Amundsen Sea sector of West Antarctica, and high confidence that they result from the acceleration of outlet glaciers. [4.4.2, 4.4.3, Figures 4.14, 4.16, 4.17] The average rate of ice loss from Antarctica likely increased from 30 [–37 to 97] Gt yr–1 (sea level equivalent, 0.08 [–0.10 to 0.27] mm yr–1) over the period 1992–2001, to 147 [72 to 221] Gt yr–1 over the period 2002–2011 (0.40 [0.20 to 0.61] mm yr–1). [4.4.3, Figures 4.16, 4.17] In parts of Antarctica, floating ice shelves are undergoing substantial changes (high confidence). There is medium confidence that ice shelves are thinning in the Amundsen Sea region of West Antarctica, and low confidence that this is due to high ocean heat flux. There is high confidence that ice shelves round the Antarctic Peninsula continue a long-term trend of retreat and partial collapse that began decades ago. [4.4.2, 4.4.5] (Un négativiste va probablement nous sortir qu'une tendance de fond aussi significative d'une perte, va changer significativement avec 1, 2 ou 3 données de plus, alors que l'accélération de cette fonte significative, n'est pas loin de devenir significative.) FAQ dans l'AR 5 : FAQ 4.2: How is Sea Ice Changing in the Arctic and Antarctic? The sea ice covers on the Arctic Ocean and on the Southern Ocean around Antarctica have quite different characteristics, and are showing different changes with time. Over the past 34 years (1979–2012), there has been a downward trend of 3.8% per decade in the annual average extent of sea ice in the Arctic. The average winter thickness of Arctic Ocean sea ice has thinned by approximately 1.8 m between 1978 and 2008, and the total volume (mass) of Arctic sea ice has decreased at all times of year. The more rapid decrease in the extent of sea ice at the summer minimum is a consequence of these trends. In contrast, over the same 34-year period, the total extent of Antarctic sea ice shows a smaller increase of 1.5% per decade, but there are strong regional differences in the changes around the Antarctic. Measurements of Antarctic sea ice thickness are too few to be able to judge whether its total volume (mass) is decreasing, steady, or increasing. A large part of the total Arctic sea ice cover lies above 60°N (FAQ 4.2, Figure 1) and is surrounded by land to the south with openings to the Canadian Arctic Archipelago, and the Bering, Barents, and Greenland seas. Some of the ice within the Arctic basin survives for several seasons, growing in thickness by freezing of seawater at the base and by deformation (ridging and rafting). Seasonal sea ice grows to only ~2 m in thickness but sea ice that is more than one year old (perennial ice) can be several metres thicker. Arctic sea ice drifts within the basin, driven by wind and ocean currents: the mean drift pattern is dominated by a clockwise circulation pattern in the western Arctic and a Transpolar Drift Stream that transports Siberian sea ice across the Arctic and exports it from the basin through the Fram Strait. Satellites with the capability to distinguish ice and open water have provided a picture of the sea ice cover changes. Since 1979, the annual average extent of ice in the Arctic has decreased by 3.8% per decade. The decline in extent at the end of summer (in late-September) has been even greater at 11% per decade, reaching a record minimum in 2012. The decadal average extent of the September minimum Arctic ice cover has decreased for each decade since satellite records began. Submarine and satellite records suggest that the thickness of Arctic ice, and hence the total volume, is also decreasing. Changes in the relative amounts of perennial and seasonal ice are contributing to the reduction in ice volume. Over the 34-year record, approximately 17% of this type of sea ice per decade has been lost to melt and export out of the basin since 1979 and 40% since 1999. While the area of Arctic sea ice coverage can fluctuate from year to year because of variable seasonal production, the proportion of thick perennial ice, and the total sea ice volume, can only recover slowly. Unlike the Arctic, the sea ice cover around Antarctica is constrained to latitudes north of 78°S because of the presence of the continental land mass. The Antarctic sea ice cover is largely seasonal, with an average thickness of only ~1 m at the time of maximum extent in September. Only a small fraction of the ice cover survives the summer minimum in February, and very little Antarctic sea ice is more than two years old. The ice edge is exposed to the open ocean and the snowfall rate over Antarctic sea ice is higher than in the Arctic. When the snow load from snowfall is sufficient to depress the ice surface below sea level, seawater infiltrates the base of the snow pack and snow-ice is formed when the resultant slush freezes. Consequently, snow-to-ice conversion (as well as basal freezing as in the Arctic) contributes to the seasonal growth in ice thickness and total ice volume in the Antarctic. Snow-ice formation is sensitive to changes in precipitation and thus changes in regional climate. The consequence of changes in precipitation on Antarctic sea ice thickness and volume remains a focus for research. Unconstrained by land boundaries, the latitudinal extent of the Antarctic sea ice cover is highly variable. Near the Antarctic coast, sea ice drift is predominantly from east to west, but further north, it is from west to east and highly divergent. Distinct clockwise circulation patterns that transport ice northward can be found in the Weddell and Ross Seas, while the circulation is more variable around East Antarctica. The northward extent of the sea ice cover is controlled in part by the divergent drift that is conducive in winter months to new ice formation in persistent open water areas (polynyas) along the coastlines. These zones of ice formation result in saltier and thus denser ocean water and become one of the primary sources of the deepest water found in the global oceans. Over the same 34-year satellite record, the annual extent of sea ice in the Antarctic increased at about 1.5% per decade. However, there are regional differences in trends with decreases seen in the Bellingshausen and Amundsen seas, but a larger increase in sea ice extent in the Ross Sea that dominates the overall trend. Whether the smaller overall increase in Antarctic sea ice extent is meaningful as an indicator of climate is uncertain because the extent varies so much from year to year and from place to place around the continent. Results from a recent study suggest that these contrasting trends in ice coverage may be due to trends in regional wind speed and patterns. Without better ice thickness and ice volume estimates, it is difficult to characterize how Antarctic sea ice cover is responding to changing climate, or which climate parameters are most influential. There are large differences in the physical environment and processes that affect the state of Arctic and Antarctic sea ice cover and contribute to their dissimilar responses to climate change. The long, and unbroken, record of satellite observations have provided a clear picture of the decline of the Arctic sea ice cover, but available evidence precludes us from making robust statements about overall changes in Antarctic sea ice and their causes. -

Calcul de l'ensoleillement avec Weatherlink

ChristianP a répondu à un sujet de Seb-50 dans Instrumentation

Bonjour Jean-Marc, Et oui il est plus faible sur plan horizontal avec nos capteurs, c'est bien pour cette raison que la méthode donne justement de l'insolation alors qu'on ne récolte même pas 120W/m2 de global et donc pas 120W/m2 de direct sur plan horizontal (vu qu'on est sensé récolter du diffus en plus du direct et selon l'albédo des obstacles quand il y en a, plus ou moins de réfléchi) Il y aussi probablement un problème dans ton estimation du direct, à cause du trouble atmosphérique moyen pris en compte, vu que dans la doc MF, je constate qu'on a plus de 120W/m2 de direct théorique avant les 3° de hauteur. Exemple à l'occasion d'une tentative d'amélioration de la méthode par MF, qui intégre un programme pour déterminer le trouble atmosphérique d'Angström, d'après les paramètres météo de la station auto, qui va générer des valeurs FC variables en temps réel (pour alimenter la formule de la méthode), avec un trouble de 0,024 (une visibilité de 120 km) le matin et un FC = 0.8, pour un 9 juillet à Carpentras, ils récoltent 125 W/m2 de direct pour 1.66° de hauteur, seuil de 120 W/m2 franchit un peu avant dans cette minute. A 3.07° de hauteur, ils ont 202 W/m2 de direct et ils indiquent qu'on perd 9 ' de soleil ce matin à cause du filtre des hauteurs < 3°. La méthode sans filtre, voit bien l'insolation dès le lever du jour. Le soir avec une même visi, mais avec un FC légèrement plus faible avec des conditions météo un peu différentes, on perd 8' à cause du filtre des 3°, donc au total du jour -17' de DI pour cause de masques virtuels (quand les masques ne sont pas présents sur la station, alors qu'on filtre) Enfin le problème c'est le fort trouble atmosphérique, qui fait qu'on sous-estimera souvent la réalité de la DI vers ces hauteurs. Avec un fort trouble atmosphérique un 9 juillet à Carpentras, on perd 27' (12' le matin et 15' le soir pour ce cas) de DI même par rapport aux 3° de hauteur (la méthode ne verra une DI qu'avec 152 W/m2 de direct dans la réalité) donc par rapport au vrai lever/coucher du soleil on perd bien plus, car avec ce trouble, le matin on a 121 W / m2 qu'à 12.42° de hauteur ( soit 66 mn plus tard que le cas précédent pour atteindre 125W/m2 avec peu de trouble pour le même jour). Ce cas avec fort trouble, correspond plus à tes calculs théoriques du direct. Ca ne concerne pas que l'été, un 21 décembre, je vois une valeur de 120W/m2 de direct pour 1.46° de hauteur (faible trouble, mais plus important que le 9 juillet, 0.036, visi 85 km) et 225 W/m2 de direct à 3.05° de de hauteur (11' perdues à cause du filtre sur ce matin) Pour ta station au climat et au comportement (pour l'insolation) assez différents de celui de Carpentras, avec plus de trouble atmosphérique près du bassi , il vaut mieux utiliser d'autres coeff pour un climat plus semblable. J'avais lu les explications sur tes fichiers, que je n' ai pas testés et je ne demandais pas particulièrement à ce que tu modifies tes applis. Comme tu me parlais de ta préférence pour les pourcentages, j'indiquais simplement les valeurs nécessaires pour combler tout le monde, aussi bien les climatologues pour-lesquels il faut s'abstraire des masques et obligatoirement en tenir compte pour comparer la DI des différentes stations selon les normes OMM, que pour la production d'énergie solaire ou autres, où au contraire il faut les garder et montrer le déficit réel dû aux obstacles artificiels ou non. Quand on s'occupe des masques, il ne s'agit surtout pas de comptabiliser systématiquement de la DI quand il y a un masque qui passe, ça n'aurait pas de sens (par exemple, il faut tenir compte de la DI chaque jour juste après le passage (et avant quand c'est le cas) du masque. Les erreurs bien réelles certains jours, se compensent sur assez de jours, vu que le comportement du ciel, différent pendant et après/avant le passage du masque, est aléatoire). Les meilleurs atlas de DI journalière jamais publiés en France donnaient les pourcentages, les proba pour chaque jour, avec et sans masques pour la station donnée si c'était le cas. Eux utilisaient le rapport d'insolation journalier R. R(j)= S(j)/Sm0 (j, phi) S(j) est la durée d'insolation où le direct a dépassé les 120 W/m2 (+- 20%) Smo(j,phi) est la durée d'insolation maximale possible. Il est dit que ceci permet de s'abstenir de l'aspect "astronomique" dans la variation de l'insolation et de caractériser l'aspect proprement climato (quand la station n'a pas de masques) Sans masques la durée maximum possible est So (j ,phi) qui est la durée astronomique du jour calculée à partir de la latitude. Quand il y a des masques, on exprime Smo (j, phi) de la manière suivante : Smo (j,) = So(j,phi) * Rmo(j) Rmo(j) est le coeff de réduction topo qui s'évalue à partir du diagramme solaire et des masques du lieu. Pour les valeurs purement horaires en tenant compte des masques, la méthode utilisée par les US est pour le moment la meilleure. Ils intègrent dans le programme de leurs stations, les relevés des masques quand il y en a et d'après les paramètres météo mesurés par la station, avant, pendant et après le passage des masques et aussi selon l'insolation avant et après, le programme détermine, s'il y a eu ou non probablement du soleil. Ils ont démontré que la méthode améliore significativement et rend bien plus comparables les mesures des stations que de ne pas du tout traiter les masques. La pire arnaque climatologique pour moi quand on veut comparer les données de DI de différentes villes, c'est de ne pas traiter les masques artificiels > 3°, comme des arbres, des constructions, des poteaux et autres, alors qu'ils n'ont rien à voir avec la topo naturelle du lieu (les montagnes/collines). Dans la doc sur le site Davis, je ne vois pas cette histoire de 5% de la déviation. L'incertitude du pyrano Davis est de +- 5% sur toute la gamme avec l'acquisition comprise (certains auront remarqué que la console n'actualise pas toujours la valeur toutes les 50/60 s, ce qui génère une erreur supplémentaire à celle du capteur à certains instants t. En corrigeant la mesure en fonction de la T, on tombe à +-3% d'incertitude) Les tests de quelques exemplaires par l'OMM donnent des incertitudes plus faibles, une petite sous-estimation (mais bon là Davis n'envoie pas à l'OMM des capteurs sans vérifier l'étalonnage au dernier moment) Ce que j'ai remarqué pendant la période ou IC proposait une carte des valeurs des pyrano des StatIC et sur mes 3 capteurs depuis longtemps, c'est que généralement ce capteur sous-estime (pour les voisins que j'ai bien en tête, la seule station du coin où il surestime trop, c'est Solliés-Ville, toutes les autres StatIC sous-estiment trop le RG par ciel limpide, Carnoux, Marseille, Aubagne, Le Luc, en tenant compte bien entendu des diff d'altitude, de mini décalages horaires, des conditions de visi, d'humidité et de la T). Ici j'ai dû calibrer des capteurs à la hausse pour coller au mieux au pyrano MF (en allant sur place avec un pyrano Davis qui me sert de référence pour régler les deux autres) Il n'y a pas longtemps, j'ai vérifié la cohérence à distance, les explications sont dans le texte de chaque photo: http://www.facebook.com/photo.php?fbid=203291373169005&set=a.203291333169009.1073741840.100004644305349&type=3&theater Même sur place près d'un pyrano, il est préconisé de vérifier un capteur avec des hauteurs solaires élevées (plus de 70°), donc vers midi solaire pas loin du 21 juin, par ciel limpide. Attention aux données MF de RG dans IC, qui sont déduites du cumul horaire de RG (en joules/cm2), une fois converti en W/m2, à l 'inverse de nos valeurs instantanées, c'est équivalent à une moyenne /60 mn en W/m2 chez nous (d'ailleurs pour une comparaison plus cohérente, il faudrait qu'IC moyenne les valeurs des 6 derniers relevés instantanés / 10 mn de l'heure du relevé (h, h-10, h-20 , h-30, h-40 , h-50) du RG des StatIC pour l'heure pile, car la valeur instantanée Davis surestime le matin et sous-estime l'AM, par rapport à la valeur MF qui est la moyenne de l'heure qui vient de se terminer) PS : Je n'ai pas encore lu de près ton MP que je viens juste de voir après avoir rédigé cette réponse. -

Calcul de l'ensoleillement avec Weatherlink

ChristianP a répondu à un sujet de Seb-50 dans Instrumentation

Bonjour ! Il y a plusieurs doc et dans celle de la détermination de la DI à partir du pyrano que j'ai utilisée, il est écrit en gras, que le seuil de l'éclairement énergétique du rayonnement global G au-dessus duquel on peut considérer qu'il y a insolation devient : G seuil = ( A + B cos((2pi/365)*d))* 1080(sin h)^1.25 Pour gagner de la précision, il faudrait se procurer au CDM ou à la Direction Régionale, les derniers coeff A et B de la station MF la plus proche. Ces coeff ont été améliorés depuis la doc de 2001 à partir des mesures de références et de la climato pour chaque lieu. Dans la doc à l'OMM : For Northern Hemisphere A and B coefficient resides in a range respectively of 0,67‐0,77 and 0.04 ‐ 0.06, probably depending more on local climatology than on latitude. Résultats de la méthode MF et leurs coeff selon différentes stations : Ce seuil de référence variable chaque minute est aussi dans la dernière publication à l'OMM : b. Carpentras method or Météo‐France algorithm (MFA) This method has been developed at the European Regional Radiation Centre of Carpentras and described by Olivíeri (1998). It consists in the calculation of minutes of SD through the measurement of 1‐min averaged global irradiance (G) compared with an accurate threshold value. The MFA is run every minute and can be expressed by the following formula and test: If G ≥ GSeuil then SDMFA = 1 minute, otherwise SDMFA = 0 minute where: ‐ GSeuil = Fc 1080 (sin(h))1.25 (model) (b1) ‐ h ≥ 3° (data filtering) ‐ Fc = A + Bcos(2πd/365) (b2) with: ‐ Fc representing a fraction of global irradiance in clear sky in mean conditions of atmospheric turbidity; ‐ h being the elevation angle of the sun in degrees; ‐ d being the day number of the annual sequence; The Fc factor depends on the climatic conditions of the location and A,B coefficients can be empirically calculated through a long term comparison with SD measurements by means of a pyrheliometer. Météo‐France realized tables of A,B coefficients for different location latitudes and the following coefficient have been adopted for the present intercomparison for both locations (due to their similar latitude) : A = 0.73, B = 0.06 (note perso : les coef améliorés à utiliser maintenant à Carpentras sont A = 0.71 , B 0.05 , qui donnent qu'une heure d'erreur sur le cumul total de toutes les heures d'insolation relevées sur 2007 à 2010 : 11013 h calculées pour 11012 h mesurées par le pyrhéliomètre !) The elevation angle of the sun is calculated every minute contemporary to the sun hour angle, right ascension and geocentric declination according to the astronomical formulas reported in Annex 7.D Chapter 7 of CIMO Guide. The data filtering (h ≥ 3°) is applied before the execution of the main test and permits the filtering of errors due to the imperfection of the model, height of the sun (low heights) and the atmospheric refraction. The CIMO Guide admits indeed a tolerance of 3° above the horizon for the requirement of an uninterrupted view of the sum at all times of the year for SD detectors. In a further national study, Météo‐France scientists in Carpentras demonstrated that the errors introduced by the data filtering on h produce a small underestimation that due to their systematic nature can be corrected after a long term period of measurements. Il faut bien voir que c'est un modèle statistique, même s'il est basé sur certaines mesures physiques, il ne déduit pas la mesure de rayonnement direct d'un capteur de rayonnement direct orienté vers le soleil et donc c'est le seuil modélisé qui est la "bonne" référence variable à chaque minute. Avec la mesure du diffus, habituellement on déduit le direct sur surface horizontale, qui n'est pas assez identique au direct récupéré par un capteur toujours bien orienté vers le soleil en fonction de son azimut et de son élévation aussi (c'est comme si on orientait en permanence un panneau solaire, en azimut et en élévation, pour qu'il capte en permanence le maximum d'énergie, mais dans ce cas juste celle du direct), il faudrait donc un autre calcul pour déduire le direct d'un capteur toujours bien orienté vers le soleil. Sinon pour la durée, pour moi il vaut mieux utiliser les deux, le pourcentage et la durée qui offrent des informations complémentaires. Ex : 50% de la DI possible dans une station dans une même période au Pôle Nord ou à l'Equateur, ça ne parle pas assez si le nb d'heures n'est pas communiqué et s'il y a des masques à certaines périodes, il faut même 4 données, les pourcentages et des durées avec et sans masques (Comme d'habitude, il me faut des mesures à gogo !) -

Calcul de l'ensoleillement avec Weatherlink

ChristianP a répondu à un sujet de Seb-50 dans Instrumentation

Je n'avais pas vu passer ce sujet, sacré boulot ! Normalement le seuil de 120W/m2 de direct, ne concerne pas le résultat du calcul de la méthode MF du calcul de la DI à partir d'un pyrano, mais les valeurs des capteurs de rayonnement directs, qui eux suivent de près le soleil et captent plus d'énergie bien dans l'axe du soleil que les mêmes capteurs toujours bien horizontaux. Ce qui fait qu'il y a insolation avec la méthode MF, c'est que la valeur donnée par le pyrano Davis ou non, dépasse la valeur calculée par la méthode MF(c'est le seuil donné pour le jour et la minute donnés), même quand elle est inférieure à 120W/m2 (du moins pour les hauteurs de soleil à partir de 3°, on ne comptabilise pas le soleil avec des hauteurs plus faibles avec la méthode MF, car MF a déterminé que les écarts sont trop importants en-dessous de 3° de hauteur) -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Oui Gpiton j'avais vu les problèmes possibles dans la publication de Foster et R (FR) et j'avais suivi les détails très intéressants ici, traités en 3 parties : http://troyca.wordpress.com/2013/02/23/could-the-multiple-regression-approach-detect-a-recent-pause-in-global-warming-part-3/ (Pour ceux qui voudraient voir la réponse aux forçages des volcans et du soleil dans certains modèles climatiques, c'est intéressant) Mais bon rien ne permet de savoir avec assez de certitude ce qui est le plus pertinent, d'autant plus que Troy pense que la réalité se situe plutôt entre son analyse à partir des modèles et celle de FR. De plus au contraire de FR, son travail n'est pas passé par les pairs pour le moment et des scientifiques trouvent encore assez valide FR, pour continuer à le citer dans des publications revues, donc ça ne paraît pas franchement tranché (mais bon à priori, vu que j'ai peut-être raté des épisodes) Et oui logique que ce ne soit pas comme d'habitude, vu que dans ce cas, c'est dans le cadre de l'explication de la variabilité interne et non pour le diagnostique de l'évolution du pas climatique. Même sans s'occuper de la significativité, il est normal dans ce cas, d'afficher cette variation avec un lissage de 10 ans bien trop court pour suivre l'évolution du climat (un Lowess/10 ans c'est comme afficher une moyenne mobile / 5 ans), tant que ça reste dans le contexte de l' analyse du bruit. Si on masque le bruit en lissant trop, on ne risque pas de pouvoir l'analyser quand c'est l'objectif, de même que si on brouille trop le signal du climat en laissant trop de bruit en ne lissant pas assez pour faire ressortir l'évolution du climat quand on s'y intéresse, on ne risque pas d'analyser l'évolution du climat. Une durée se choisit en fonction de l'objectif et de la significativité quand c'est nécessaire. Il n'y a aucune contradiction dans les articles de Tamino à ce sujet depuis le début de son blog que j'ai suivi très attentivement à cause de sa remarquable pédagogie pour expliquer les méthodes stats. Dans le sujet suivant, Il ne dit pas le contraire en montrant une tendance interne sur 15 ans de +0.28°, significativement différente de la pente sur 75-2012 et il ne dit pas que le changement est significatif pour autant, parce que la pente actuelle nulle sur 15 ans est pourtant significativement différente de celle à 0.28°, http://tamino.files.wordpress.com/2013/09/gisstrend06.jpg , http://tamino.files.wordpress.com/2013/09/gisstrend12.jpg , d'autant plus que des données de ces deux tendances se recouvrent et ne sont pas indépendantes (condition indispensable pour la validité des tests, du moins si on ne compense pas en corrigeant le nb de degrés de liberté), ça n'aurait pas de sens de parler d'un changement à cause des différences significatives "brutes" (vu qu'on sait qu'en corrigeant les IC en calculant le vrai nombre de degrés de liberté à cause du recouvrement, ça élargit les IC, ce qui rend le changement non significatif, comme quand ça ne l'est pas quand on veille à ne pas recouvrir) Tamino ne parle pas de la significativité ou non de ce changement de tendance des hivers de l'HN, car il a surtout voulu montrer avec son graphe des hivers avec des IP (et non des IC) que les hivers de l'HN se sont comportés de façon différente des autres saisons et qu' ils sont froids dans le contexte de la tendance au RC (ils sont loin d'être froids dans l'absolu, car la moyenne des hivers 2001-2013 de l'HN est significativement plus chaude que celle sur 1975-2000, assez largement : http://meteo.besse83.free.fr/imfix/hiverhnman752000.png , sur 99-2013 / 75-98, ça n'y change rien, http://meteo.besse83.free.fr/imfix/hiverhnman751998.png ...) C'est une variation interne non encore significative de peu, non climatique, qui est compatible avec ce que rapporte la publication sur l'impact des SST dans la zone d'El Nino sur les hivers de l'HN. Il fallait bien montrer la différence de comportement des différentes saisons en rapport avec le bruit concerné. Que la tendance soit significative ou pas, n'a pas d'importance, vu qu'on zoome justement sur l'influence de la variabilité pour pouvoir l'extraire et l'expliquer. En plus de l'intérêt pour la publication concernée, j'avais rapporté le graphe de Tamino avec les IP, simplement pour donner un exemple concret et récent aux passionnés, d'un cas où on pouvait objectivement se pencher sur les calculs de significativité d'un changement de tendance, vu que tant qu'il n'y a pas au moins 2 valeurs hors IP, ce n'est pas la peine de perdre son temps (C'est Tamino qui a donné il y a des années sur son blog, cette méthode pour envisager un changement significatif possible au plus tôt à partir des valeurs hors IP , mais c'est avec la méthode des IC plus performante, qu'on vérifie plus efficacement la significativité d'un changement de tendance) Je reviens plus en détail sur l'absence de significativité du changement de la tendance des hivers, car je n'ai pas diffusé les bons chiffres (le fond n'a pas du tout changé, je me suis juste trompé dans la citation des chiffres), de plus j'ai vu que certains ailleurs d'IC, pourtant bien plus pointus que moi, semblent confondre l'IP tracé par Tamino (Intervalle de Prédiction des valeurs, la distribution des valeurs à laquelle on s'attend autour de la tendance donnée), qui n'est pas l'IC, (l'Intervalle de Confiance de la pente de la tendance, l'incertitude de l'estimation de la pente) Un IP n'est pas fait pour déterminer très précisément la significativité d'un changement de tendance, car de fait on se base sur des valeurs extrêmes (< 2.5% de valeurs froides ou < 2.5% chaudes) qui suivent des lois différentes et rendent plus difficile la détection précise d'un changement significatif, à l'inverse de l'IC qui concerne bien plus directement le paramètre qu'on estime, la pente de la tendance. Comme après 1945 au pas annuel global, où on se doutait dès 1948 avec les IP, d'un possible changement de tendance, il avait fallu attendre 1952 pour que ça se confirme et trouver la tendance significativement différente avec les IC (la significativité dépend aussi du niveau des autres valeurs dans l'IP et pas seulement des valeurs hors IP, ce qui est malheureusement le cas quand on cherche à estimer la significativité avec les seuls IP, on se fixe que sur les valeurs extrêmes hors IP) Pour ceux qui voudraient vérifier les calculs, j'ai utilisé R comme Tamino, pour être certain d'utiliser la même fonction intégrée au package interne "stats". Les données des hivers de l'HN pour GISS ( http://data.giss.nasa.gov/gistemp/tabledata_v3/NH.Ts+dSST.txt ) sont dispo dans le cache de google ici, depuis que des fonctionnaires US sont virés du boulot : http://webcache.googleusercontent.com/search?q=cache:wScCxatt4RkJ:data.giss.nasa.gov/gistemp/tabledata_v3/NH.Ts%2BdSST.txt+&cd=1&hl=fr&ct=clnk&gl=fr&lr=lang_en|lang_fr&client=firefox-a Intervalle de confiance de la pente de la tendance pour la période donnée (ça signifie que la pente de la tendance qu'on calcule se situe quelque part dans 95% des cas entre ces 2 bornes à 2.5% et 97.5%) 1975-2000 > confint(reglm) 2.5 % 97.5 % x 0.01828873 0.03821041 Donc pour que le changement soit significatif, il faut que l'IC supérieur de l'autre tendance à comparer, soit inférieure à 0.01828873° / hiver (la tendance centrale sur 1975-2000 est 0.028°/hiver) 2001-2013 > confint(reglm) 2.5 % 97.5 % x -0.03985252 0.02183055 Donc pas de différence significative sans recouvrement de données. Avec un an de recouvrement, ce n'est toujours pas significatif. 2000-2013 > confint(reglm) 2.5 % 97.5 % x -0.03287723 0.01977833 Il faut un recouvrement de 2 ans pour trouver une différence significative. La tendance 1999-2013 est significativement différente de celle sur 1975-2000, mais comme indiqué ça n'a pas de sens pour chercher un changement significatif vu qu'il faut corriger le nb de d.d.l. ce qui élargira les IC et donc fait perdre la significativité et rend inutile cette pratique. 1999-2013 > confint(reglm) 2.5 % 97.5 % x -0.03127857 0.01420714 En respectant la condition d'indépendance des données sans recouvrement, en 2014 le changement de tendance des hivers de l'HN sera significatif, si l'anomalie hivernale ne dépasse pas 0.65°, ce qui est possible avec une anomalie à peine inférieure à la moyenne des 13 derniers hivers (0.68°) 2001-2014 (avec 0.65° pour l'hiver 2014) > confint(reglm) 2.5 % 97.5 % x -0.03432112 0.01801343 Le fait est, que sauf erreur de ma part, le changement de la tendance hivernale de l'HN n'est pas encore significatif et qu'on ne sait pas prévoir avec une confiance à 95%, le niveau de l'anomalie hivernale suivante, pour être assez certain que la tendance aura changé significativement un an en avance (l'observation d'une valeur d'au plus 0.65° est loin de récupérer les 95% de proba nécessaires) Je ne comprends pas trop l' histoire de "on ne peut pas prouver s'il a raison ou s'il a tord", vu que ce ne sont pas des prévis, mais une simple lecture objective des obs avec les stats, donc que des proba plus ou moins grandes. Personne, même pas Tamino qui est engagé, ne va s'amuser à dire que le réchauffement depuis 98 est statistiquement significatif (pour la T annuelle globale), alors qu'il n'est pas significatif aussi de peu avec les méthodes admises et malgré le fait qu'on se doute qu'il est toujours bien plus probablement présent qu'absent sur le fond, en prenant assez de recul et en suivant les moyennes, ou en analysant le bruit. Sinon, plus généralement, pour savoir si le climat global se sera effectivement significativement réchauffé depuis fin 98 malgré le palier actuel au pas annuel, il ne faudra pas attendre 60 ou 120 ans et bien longtemps. On récoltera la fin de nos 60 ans de données nécessaires, quand la période de 1999-2028 sera terminée. De plus entre temps, on a (aura) des indices, comme des moyennes plus courtes qu'on peut comparer. Par exemple, la moyenne 99-2012 malgré des IC plus larges avec le poids de la variabilité sur ce type de période courte, est significativement plus élevée que celle de notre échantillon de climat fin 1998. Notre dernier échantillon de climat fin 2012 ou à jour le mois précédent (la dernière moyenne/30 ans) montre depuis janvier 99, un réchauffement de plus de 0.2°. Ca signifie que sans au moins une légère tendance à la baisse sur l'autre partie (2013-2028) de l'échantillon de climat, pour réduire cette hausse déjà en stock, on ne pourra qu'observer un RC significatif du climat (de la moyenne/30 ans) fin 2028, même si le palier actuel se poursuit jusque là et d'autant plus s'il reste un peu pentu positivement comme depuis 98, la hausse ne pourra que se poursuivre, étant donné que même sans cette pente +, les 0.2° engrangés seront de fait un changement significatif de climat en 2028 (le chevauchement de données des deux moyennes/30 ans prendra fin, on aura deux échantillons de climat assez indépendants). Mais c'est clair que cette valeur de +0.2x° / 30 ans, ne serait pas considérée comme une réussite pour les modèles conçus pour prévoir plus précisément la hausse de T à partir de cette durée. Certains ne se rendent donc pas compte, que le RC depuis 99 est déjà conséquent, de plus de 0.2° (hausse d'un écart-type environ) sur les 0.68° observés depuis la fin du premier échantillon de climat sur 1880-1909 (moyenne/30 ans des 3 séries HAD, NOAA, GISS), par rapport au dernier échantillon sur 1983-2012. J'apprécie plutôt de comparer des échantillons de climat (des moyennes sur 30 ans), donc la première (1880-1909) avec la dernière (1983-2012), ça fait un changement de climat de 0.68° pour les trois séries GISS, HAD, NOAA (respectivement, 0.69°, 0.67°, 0.68°). Les 0.85° de réchauffement sur 1880-2012, du dernier rapport AR5, sont calculés à partir de la moyenne des tendances linéaires des 3 séries, GISS, HAD, NOAA qui donnent respectivement : 0.87°, 0.83°, 0.86° . -

Statistiques et anomalies climatiques globales

ChristianP a répondu à un sujet de Sam82 dans Evolution du climat

Oui Cotissois, de plus je viens de le vérifier par calculs, le changement n'est pas encore significatif de peu, ça se jouera l'hiver prochain. Sa tendance bleue est calculée sur 1975-2000, elle est de 0.179°/déc +-0.104° (IC : Intervalle de Confiance de la pente à 95%). C'est normal qu'il cherche à prolonger cette tendance sans intégrer les autres valeurs après 2000 s'il veut envisager un changement, pour vérifier d'abord si les anomalies suivantes sont toujours assez souvent dans l'IP (intervalle de prédiction) associé à cette tendance. Il a indiqué par le passé, qu'on peut commencer à tester la significativité des changements visibles et possibles si au moins 2 valeurs sortent en très peu de temps de l'IP (vu qu'on est sensé qu'en relever 2.5 / 100 ans, on peut commencer à suspecter un changement significatif proche), donc là avec 4 valeurs sous les 6 dernières, c'est à vérifier. Ensuite je vois que sur son graphe, le prolongement rouge ne démarre pas après 2000, mais vers 98 ou 99, donc à voir si c'est une simple erreur graphique, où s'il a comparé une autre tendance qui chevauche la précédente. Normalement il aurait dû comparer les IC des deux tendances sans chevauchement, comme il l'a montré maintes fois, donc en utilisant celle qui suit la première, celle sur 2001-2013 qui est de -0.05°/déc +-0.15° (donc l'IC sup est de 0.10° et passe encore encore un peu au-dessus de l'IC inf (0.075°) de de la précédente tendance, donc pas encore significatif) Je pense qu'il a largement arrondi les calculs à la louche comme à son habitude, ou simplement il n'a cherché qu'à montrer l'évolution des saisons en rapport avec ce que montre la publication. Enfin quoiqu'il en soit, même si le changement avait été strictement significatif, vu que je le martèle assez souvent ici, il n'avait aucun rapport avec la tendance de fond d'échelle climatique du réchauffement des hivers (donc sur 60 ans au moins), la dernière tendance depuis 2001, étant trop courte (tout en étant significative), ça aurait été simplement un changement significatif de tendance interne au climat des hivers. -

Précision du capteur de température de la Davis VP2

ChristianP a répondu à un sujet de fafou dans Instrumentation